Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Функция рисования в настоящее время поддерживает рисовальные модели DMXAPI, TokenFlux, AiHubMix и 硅基流动. Вы можете зарегистрировать аккаунт на 硅基流动 и добавить его как поставщика для использования.

При возникновении вопросов о параметрах наведите курсор на значок ? в соответствующей области, чтобы просмотреть описание.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

# OpenAI

## Получение API-ключа

* На официальной странице [API Key](https://platform.openai.com/api-keys) нажмите <mark style="background-color:green;">`+ Create new secret key`</mark>

<img src="../../.gitbook/assets/file.excalidraw (1).svg" alt="" class="gitbook-drawing">

* Скопируйте сгенерированный ключ и откройте [настройки провайдеров](broken-reference) в CherryStudio

* Найдите провайдера OpenAI и вставьте полученный ключ

<figure><img src="../../.gitbook/assets/image (9).png" alt=""><figcaption></figcaption></figure>

* Нажмите "Управление" или "Добавить" внизу страницы, добавьте поддерживаемые модели и активируйте переключатель провайдера в правом верхнем углу для начала использования.

{% hint style="info" %}

- Прямой доступ к сервисам OpenAI недоступен в регионах Китая (кроме Тайваня). Требуется самостоятельное решение вопроса с прокси;

- Необходим положительный баланс счёта.

{% endhint %}Windows 版本安装教程

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Внимание: Windows 7 не поддерживает установку Cherry Studio.

Нажмите, чтобы скачать подходящую версию

Если браузер предупреждает, что файл не является доверенным, выберите "Сохранить"

Выбрать "Сохранить"→Доверять Cherry-Studio

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Перед получением API-ключа для Gemini у вас должен быть проект Google Cloud (если он уже есть, этот шаг можно пропустить)

Перейдите в Google Cloud, создайте проект, введите название проекта и нажмите "Создать проект"

На официальной странице API-ключа нажмите 密钥 创建API密钥 (Создать API-ключ)

Скопируйте сгенерированный ключ и откройте настройки провайдеров в CherryStudio

Найдите провайдера Gemini и введите полученный ключ

Нажмите "Управление" или "Добавить" внизу, подключите поддерживаемые модели и активируйте переключатель провайдера в правом верхнем углу для начала использования.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Все данные, добавленные в базу знаний Cherry Studio, хранятся локально. В процессе добавления создается копия документа в каталоге хранения данных Cherry Studio.

Векторная база данных: https://turso.tech/libsql

После добавления документа в базу знаний Cherry Studio файл разбивается на несколько фрагментов, которые затем обрабатываются моделью эмбеддинга.

При использовании большой модели для ответов на вопросы система запрашивает связанные с вопросом текстовые фрагменты и передает их языковой модели для обработки.

Если есть требования к конфиденциальности данных, рекомендуется использовать локальную базу данных эмбеддингов и локальную большую языковую модель.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Войдите в . Если у вас нет учётной записи Alibaba Cloud, необходимо зарегистрироваться.

Нажмите кнопку 创建我的 API-KEY в правом верхнем углу.

В открывшемся окне выберите пространство по умолчанию (или создайте своё), при необходимости заполните описание.

Нажмите кнопку 确定 в правом нижнем углу.

В списке появится новая запись, нажмите кнопку 查看 справа.

Нажмите кнопку 复制.

Перейдите в Cherry Studio, в разделе 设置 → 模型服务 → 阿里云百炼 найдите поле API 密钥, вставьте скопированный ключ.

Настройте параметры согласно инструкции в разделе , после чего сервис будет готов к использованию.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Для использования GitHub Copilot необходимо иметь учётную запись GitHub и подписку на сервис GitHub Copilot. Подойдёт и бесплатная версия подписки (free), однако она не поддерживает новейшую модель Claude 3.7. Подробности смотрите на .

Нажмите «Войти в GitHub», чтобы получить Device Code и скопируйте его.

После успешного получения Device Code перейдите по ссылке в браузере, войдите в учётную запись GitHub, введите Device Code и подтвердите доступ.

После успешной авторизации вернитесь в Cherry Studio, нажмите «Подключить GitHub». При успешном подключении отобразятся имя пользователя и аватар GitHub.

Нажмите кнопку «Управление» внизу экрана — автоматически загрузится список поддерживаемых моделей.

В настоящее время для отправки запросов используется Axios, который не поддерживает socks-прокси. Рекомендуем использовать системный прокси или HTTP-прокси. Либо отключите настройки прокси в Cherry Studio и используйте глобальный прокси. Убедитесь, что ваше сетевое соединение стабильно, чтобы избежать ошибок при получении Device Code.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Войдите и перейдите на страницу токенов

Создайте новый токен (также можно использовать токен default↑)

Скопируйте токен

Откройте настройки поставщиков CherryStudio, в конце списка поставщиков нажмите Добавить

Введите имя для заметки, выберите поставщика OpenAI, нажмите OK

Вставьте скопированный ключ

Вернитесь на страницу получения API Key, скопируйте базовый адрес из адресной строки браузера, например:

Добавьте модели (нажмите "Управление" для автоимпорта или введите вручную), активируйте переключатель в правом верхнем углу для использования.

Интерфейс в других темах OneAPI может отличаться, но порядок добавления идентичен вышеописанному.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Войдите и откройте страницу токенов

Нажмите "Добавить токен"

Введите имя токена и нажмите "Отправить" (при необходимости настройте другие параметры)

Откройте настройки поставщиков CherryStudio и нажмите Добавить внизу списка поставщиков

Введите название, выберите провайдера "OpenAI", нажмите "ОК"

Вставьте скопированный ключ

Вернитесь на страницу получения API-ключа и скопируйте базовый адрес из адресной строки браузера, например:

Добавьте модели (нажмите "Управление" для автоимпорта или введите вручную), активируйте переключатель в правом верхнем углу для использования.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Когда для ассистента не задана модель по умолчанию, в новых диалогах по умолчанию будет использоваться модель, настроенная здесь.

Эта же модель используется для оптимизации подсказок и функций помощника при выделении текста.

После каждого диалога вызывается модель для генерации названия темы. Здесь задается модель, используемая для наименования.

Модель перевода, используемая для функции перевода в диалогах, полях ввода рисования и интерфейсе перевода, задается здесь.

Модель, используемая для функций быстрого помощника. Подробнее см. в разделе

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Cherry Studio поддерживает настройку чёрного списка двумя способами: вручную и через добавление источников подписок. Правила настройки можно найти в .

Вы можете добавлять правила для результатов поиска или щёлкать по иконке на панели инструментов, чтобы блокировать определённые сайты. Правила можно указывать с помощью (например: *://*.example.com/*) или с использованием (например: /example\\.(net|org)/).

Вы также можете подписываться на публичные наборы правил. Некоторые подписки перечислены на сайте: https://iorate.github.io/ublacklist/subscriptions

Ниже приведены некоторые рекомендуемые источники подписок:

暂时不支持Claude模型

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Перед получением API-ключа для Gemini необходимо иметь проект Google Cloud (если уже имеется, этот шаг можно пропустить)

Перейдите в для создания проекта: укажите название проекта и нажмите "Создать проект"

Откройте

В созданном проекте активируйте

Откройте интерфейс управления и создайте сервисный аккаунт

На странице управления сервисными аккаунтами найдите созданный аккаунт, нажмите Ключи и создайте новый ключ в формате JSON

После создания ключ автоматически сохранится на компьютер в виде JSON-файла — обязательно сохраните его

Выберите провайдера Vertex AI

Заполните соответствующие поля данными из JSON-файла

Нажмите "Добавить ", чтобы начать использование!

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Страница агентов является площадкой для ассистентов, где вы можете выбрать или найти нужный предустановленный модель. При нажатии на карточку ассистент добавляется в список помощников на странице диалога.

Вы также можете редактировать и создавать собственных помощников на этой странице.

Нажмите 我的, затем 创建智能体, чтобы начать создание своего помощника.

https://git.io/ublacklist

Китайский

https://raw.githubusercontent.com/laylavish/uBlockOrigin-HUGE-AI-Blocklist/main/list_uBlacklist.txt

Генерируемый ИИ

mcp-server-time

--local-timezone

<ваш стандартный часовой пояс, например: Asia/Shanghai>

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

В этом интерфейсе можно выполнять резервное копирование и восстановление данных локально и в облаке, просматривать локальный каталог данных и очищать кеш, настраивать экспорт, а также подключаться к сторонним приложениям.

В настоящее время резервное копирование данных поддерживает три способа: локальное резервное копирование, резервное копирование через WebDAV и резервное копирование в хранилище, совместимое с S3 (объектное хранилище). Подробные инструкции и руководства см. в следующих документах:

В настройках экспорта можно настроить параметры экспорта, отображаемые в меню экспорта, а также установить путь по умолчанию для экспорта в Markdown, стиль отображения и т.д.

Подключение сторонних приложений позволяет настроить соединение Cherry Studio со сторонними приложениями для быстрого экспорта содержимого диалогов в знакомые вам приложения для управления знаниями. В настоящее время поддерживаются следующие приложения: Notion, Obsidian, SiYuan Notes, YuQue, Joplin. Подробные инструкции по настройке см. в следующих документах:

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Автоматическая установка службы MCP (бета-версия)

Базовая реализация постоянной памяти на основе локальной графовой базы знаний. Это позволяет модели запоминать информацию о пользователе между разными диалогами.

MEMORY_FILE_PATH=/path/to/your/file.jsonРеализация MCP-сервера, предоставляющая инструменты для динамического решения задач через структурированный мыслительный процесс с возможностью рефлексии.

Реализация MCP-сервера с интеграцией API Brave Search, поддерживающая как веб-поиск, так и локальный поиск.

BRAVE_API_KEY=YOUR_API_KEYMCP-сервер для извлечения содержимого веб-страниц по URL.

Node.js сервер, реализующий протокол Model Context Protocol (MCP) для операций файловой системы.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Мы приветствуем вклад в Cherry Studio! Вы можете участвовать следующими способами:

1. Разработка кода: Создание новых функций или оптимизация существующего кода. 2. Исправление ошибок: Отправка исправлений для найденных вами багов. 3. Поддержка вопросов: Помощь в управлении GitHub Issues. 4. Дизайн продукта: Участие в дискуссиях о дизайне. 5. Написание документации: Улучшение пользовательских руководств и инструкций. 6. Участие в сообществе: Присоединение к обсуждениям и помощь пользователям. 7. Продвижение: Распространение информации о Cherry Studio.

Отправьте письмо по адресу [email protected]

Тема письма: Заявка на участие в качестве разработчика Содержание письма: Обоснование заявки

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Свяжитесь по электронной почте [email protected], чтобы получить права редактора.

Заголовок: Запрос прав редактора для Cherry Studio Docs

Текст письма: Укажите причину запроса

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Для предварительной обработки документов базы знаний необходимо обновить Cherry Studio до версии v1.4.8 или выше.

После нажатия «Получить API KEY» в браузере откроется страница запроса. Нажмите «Немедленно подать заявку», заполните форму, получите API KEY и введите его в соответствующее поле.

Выполните указанные выше настройки в созданной базе знаний, чтобы завершить конфигурацию предварительной обработки документов.

Результаты работы базы знаний можно проверить через поиск в правом верхнем углу

Советы по использованию базы знаний: При работе с моделью с более высокой производительностью измените режим поиска в базе знаний на распознавание намерений для более точных и широких формулировок запросов.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Поддерживается экспорт тем и сообщений в Siyuan Notes.

Откройте Siyuan Notes и создайте блокнот

Откройте настройки блокнота и скопируйте ID блокнота

Вставьте скопированный ID блокнота в настройки Cherry Studio

Укажите адрес вашего Siyuan Notes

Локальный

Обычно: http://127.0.0.1:6806

Собственное развертывание

Ваш домен: http://note.domain.com

Скопируйте API Token из Siyuan Notes

Вставьте его в настройки Cherry Studio и проверьте подключение

Поздравляем! Настройка Siyuan Notes завершена ✅ Теперь вы можете экспортировать содержимое Cherry Studio в ваши Siyuan Notes

macOS 版本安装教程

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Перейдите на официальную страницу загрузки и нажмите "Загрузить для Mac", либо воспользуйтесь прямой ссылкой ниже

Обратите внимание, что нужно скачать версию чипа, соответствующую вашему Mac

После завершения загрузки нажмите здесь

Перетащите значок для установки

Найдите значок Cherry Studio в Launchpad и нажмите на него. Если откроется главный интерфейс Cherry Studio, значит установка прошла успешно.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Для работы с базой знаний Dify MCP требуется обновить Cherry Studio до версии v1.2.9 или выше.

Откройте функцию Поиск MCP.

Добавьте сервер dify-knowledge.

Требуется настройка параметров и переменных окружения

Ключ базы знаний Dify можно получить следующим способом

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Следите за нашими социальными аккаунтами: , , , ,

Присоединяйтесь к нашим сообществам: , , ,

Cherry Studio — универсальная платформа-ассистент на основе ИИ, объединяющая многомодельные диалоги, управление базами знаний, ИИ-рисование, перевод и другие функции. Высоко настраиваемый дизайн Cherry Studio, мощные возможности расширения и удобный интерфейс делают его идеальным выбором для профессиональных пользователей и энтузиастов ИИ. Независимо от того, являетесь ли вы новичком или разработчиком, вы найдете подходящие ИИ-функции в Cherry Studio для повышения эффективности работы и творческого потенциала.

Один вопрос — несколько ответов: Поддержка генерации ответов от нескольких моделей одновременно для сравнения их работы. Подробнее в разделе .

Автоматическая группировка: Записи диалогов каждого помощника автоматически группируются для удобства поиска.

Экспорт диалогов: Экспорт полных или частичных диалогов в различные форматы (Markdown, Word и другие).

Расширенные настройки параметров: Поддержка пользовательских параметров для персонализации.

Магазин ассистентов: Тысячи специализированных помощников для перевода, программирования, написания текстов и других областей.

Разноформатная визуализация: Поддержка рендеринга Markdown, математических формул и предварительного просмотра HTML в реальном времени.

ИИ-рисование: Специальная панель для генерации изображений по текстовому описанию.

ИИ-миниприложения: Бесплатные онлайн-инструменты ИИ без необходимости переключения браузера.

Функции перевода: Специализированные решения для панели перевода, диалогового перевода и перевода промптов.

Управление файлами: Централизованная классификация файлов диалогов, рисунков и баз знаний.

Глобальный поиск: Быстрый поиск по истории и базам знаний.

Агрегация моделей: Поддержка моделей от OpenAI, Gemini, Anthropic, Azure и других основных провайдеров.

Автоматическое получение моделей: Полный список моделей без ручной настройки.

Ротация ключей: Использование нескольких API-ключей для обхода ограничений скорости.

Персонализация аватаров: Автоматически подобранные аватары для каждой модели.

Кастомные провайдеры: Поддержка сторонних провайдеров, совместимых с OpenAI, Gemini и Anthropic.

Кастомизация CSS: Глобальная настройка стилей интерфейса.

Адаптируемая структура диалогов: Виды списка/пузырьков с возможностью изменения стиля сообщений.

Пользовательские аватары: Установка аватаров для ПО и помощников.

Настройка бокового меню: Скрытие и упорядочивание функций по необходимости.

Множество форматов: Поддержка PDF, DOCX, PPTX, XLSX, TXT, MD и других файлов.

Разнообразные источники данных: Локальные файлы, веб-ссылки, карты сайта и ручной ввод.

Экспорт знаний: Возможность экспортировать обработанные базы знаний.

Поиск и проверка: Тестирование обработки документов в реальном времени.

Быстрые ответы: Быстрые решения вопросов в любом контексте (браузер, WeChat и т.д.).

Экспресс-перевод: Быстрый перевод слов или текста в других приложениях.

Суммаризация: Краткое содержание длинных текстов.

Объяснение: Простое объяснение сложных вопросов без использования промптов.

Стратегии бэкапов: Локальное резервное копирование, WebDAV и запланированные бэкапы.

Безопасность данных: Полностью локальное использование с местными LLM для предотвращения утечек.

Простота использования: Низкий порог входа для новичков.

Полная документация: Подробные руководства и справочники по часто задаваемым вопросам.

Постоянное развитие: Активная доработка функционала на основе обратной связи.

Открытый код и расширяемость: Возможность кастомизации через исходный код.

Управление знаниями: Быстрое создание и поиск в специализированных базах знаний.

Многомодельные диалоги и генерация контента: Одновременная работа с несколькими моделями.

Перевод и автоматизация: Решения для языковых коммуникаций и обработки документов.

ИИ-рисование и дизайн: Генерация изображений по текстовым описаниям.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Для работы с серверами ModelScope MCP требуется обновить Cherry Studio до версии v1.2.9 или выше.

В версии v1.2.9 Cherry Studio официально интегрирована с ModelScope MCP (魔搭), что значительно упрощает добавление серверов MCP, исключает ошибки конфигурации и предоставляет доступ к огромному количеству MCP-серверов в сообществе ModelScope. Давайте рассмотрим пошаговый процесс синхронизации MCP-серверов ModelScope в Cherry Studio.

В настройках MCP-серверов выберите Синхронизировать серверы

Выберите ModelScope и просмотрите доступные MCP-сервисы

Зарегистрируйтесь/войдите в ModelScope и изучите детали MCP-сервиса;

В деталях MCP-сервиса выберите подключение;

Нажмите Получить API токен в Cherry Studio, перейдите на сайт ModelScope, скопируйте API-токен и вставьте его обратно в Cherry Studio.

В списке MCP-серверов Cherry Studio вы увидите подключённые сервисы ModelScope и сможете использовать их в диалогах.

Для подключения новых MCP-серверов с сайта ModelScope просто нажмите Синхронизировать серверы для их добавления.

Вы освоили простую синхронизацию MCP-серверов ModelScope в Cherry Studio. Этот процесс устраняет сложности ручной настройки и предоставляет доступ к огромным ресурсам сообщества ModelScope.

Начните использовать эти мощные MCP-сервисы для расширения возможностей работы с Cherry Studio!

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

На этой странице представлен обзор функций интерфейса. Руководство по настройке можно найти в разделе базового учебника.

В Cherry Studio один поставщик поддерживает циклическое использование нескольких ключей. Ротация происходит последовательно по списку слева направо.

Добавляйте несколько ключей через запятую на английском языке. Пример:

Обязательно используйте запятую на английском языке.

При работе со встроенными поставщиками обычно не требуется указывать API-адрес. Если необходима корректировка, строго следуйте официальной документации.

Если поставщик предоставляет адрес вида https://xxx.xxx.com/v1/chat/completions, укажите только базовый адрес (https://xxx.xxx.com).

Cherry Studio автоматически добавит конечный путь (/v1/chat/completions). Неправильное заполнение может привести к неработоспособности.

Нажмите кнопку Управление в нижнем левом углу страницы настроек поставщика. В открывшемся списке поддерживаемых моделей нажмите + для добавления в список доступных моделей.

Нажмите кнопку проверки рядом с полем ввода API-ключа для тестирования конфигурации.

После успешной настройки обязательно активируйте переключатель в правом верхнем углу. Иначе провайдер останется неактивным, а его модели недоступными.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Откройте настройки Cherry Studio.

Найдите опцию MCP 服务器.

Нажмите 添加服务器.

Заполните параметры MCP Server (). Возможные поля для заполнения:

Имя: произвольное имя, например fetch-server

Тип: выберите STDIO

Команда: введите uvx

Параметры: введите mcp-server-fetch

(могут быть другие параметры в зависимости от сервера)

Нажмите 保存.

После настройки Cherry Studio автоматически скачает необходимый MCP Server - fetch server. После завершения загрузки можно начать использование! Примечание: при неудачной настройке mcp-server-fetch попробуйте перезагрузить компьютер.

Убедитесь, что сервер MCP успешно добавлен в настройках MCP 服务器

Как показано выше, благодаря функции fetch MCP, Cherry Studio лучше понимает запросы пользователей, находит релевантную информацию в сети и предоставляет более точные и полные ответы.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Этот метод очистки настроек CSS следует использовать при установке некорректного CSS или если после настройки CSS невозможно войти в интерфейс настроек.

Откройте консоль разработчика: в окне CherryStudio нажмите комбинацию клавиш Ctrl+Shift+I (для MacOS: command+option+I).

В открывшейся консоли перейдите на вкладку Console (Консоль).

Вручную введите команду document.getElementById('user-defined-custom-css').remove() - копирование и вставка скорее всего не сработают.

После ввода нажмите Enter для выполнения команды. Это очистит настройки CSS, после чего вы сможете снова войти в настройки отображения CherryStudio и удалить проблемный CSS-код.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Cherry Studio — это бесплатный проект с открытым исходным кодом. По мере роста проекта увеличивается и рабочая нагрузка команды. Чтобы снизить коммуникационные издержки и эффективно решать ваши вопросы, мы просим перед обращением соблюдать следующие шаги — это позволит команде больше времени уделять поддержке и разработке проекта. Благодарим за понимание!

Большинство базовых вопросов можно решить, внимательно изучив документацию:

Функционал ПО и вопросы использования описаны в документации ;

Частые вопросы собраны на странице — проверьте наличие решения там;

Сложные проблемы можно решить через поиск или задав вопрос в поисковой строке;

Обязательно читайте подсказки во всех документах — это поможет избежать многих проблем;

Проверяйте наличие схожих вопросов и решений на странице в GitHub.

Вопросы, не связанные с функциями клиента (ошибки моделей, некорректные ответы, настройки параметров и т.д.) рекомендуется сначала искать в интернете или описывать проблему ИИ для поиска решений.

Если первые два шага не помогли, обратитесь в , или QQ-группу. Подробно опишите проблему.

Для ошибок модели приложите полный скриншот интерфейса и сообщения об ошибке из консоли. Конфиденциальные данные можно замаскировать, но название модели, параметры и текст ошибки должны быть видны. Метод просмотра ошибок консоли: .

При ошибках ПО укажите конкретное описание и подробные . Если ошибка случайна — максимально детально опишите контекст, настройки и условия возникновения. Также укажите платформу (Windows, Mac, Linux) и версию ПО.

Запрос документации или предложения

Свяжитесь с @Wangmouuu в Telegram, QQ (1355873789) или напишите на почту: [email protected].

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

1.2 Нажмите настройки в левом нижнем углу и выберите【Silicon Flow】в разделе модельных сервисов

1.2 Перейдите по ссылке для получения API-ключа SiliconCloud

Войдите в (при первом входе система автоматически зарегистрирует аккаунт)

Перейдите в раздел , чтобы создать новый или скопировать существующий ключ

1.3 Нажмите "Управление" для добавления моделей

Нажмите кнопку "Диалог" в левом меню

Введите текст в поле ввода, чтобы начать чат

Модель можно сменить, выбрав её название в верхнем меню

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Контакты: г-н Ван 📮: [email protected] 📱: 18954281942 (не служба поддержки)

По вопросам использования:

Присоединяйтесь к пользовательскому чату через кнопку в подвале главной страницы

Пишите на [email protected]

Создавайте issues:

Для получения экспертной поддержки присоединяйтесь к нашему

Детали коммерческой лицензии:

sk-xxxx1,sk-xxxx2,sk-xxxx3,sk-xxxx4

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Резервное копирование данных Cherry Studio поддерживается через S3-совместимое хранилище (объектное хранилище). Распространённые S3-совместимые сервисы: AWS S3, Cloudflare R2, Alibaba Cloud OSS, Tencent Cloud COS и MinIO.

На основе S3-совместимого хранилища можно реализовать синхронизацию данных между устройствами по схеме: Компьютер A S3-хранилище Компьютер B.

Создайте бакет (Bucket) объектного хранилища и запишите его имя. Настоятельно рекомендуется установить для бакета режим приватного чтения/записи для предотвращения утечки резервных данных!

Обратитесь к документации вашего облачного провайдера, чтобы получить в консоли управления следующие параметры S3-хранилища: Access Key ID, Secret Access Key, Endpoint, Bucket, Region.

Endpoint: Адрес доступа к S3-хранилищу, обычно в формате https://<bucket-name>.<region>.amazonaws.com или https://<ACCOUNT_ID>.r2.cloudflarestorage.com.

Region: Регион расположения бакета, например us-west-1, ap-southeast-1. Для Cloudflare R2 укажите auto.

Bucket: Имя бакета.

Access Key ID и Secret Access Key: Учётные данные для аутентификации.

Root Path: Опциональный параметр, указывает корневой путь для резервных копий в бакете (по умолчанию пустой).

Документация

Cloudflare R2: Получение Access Key ID и Secret Access Key

Alibaba Cloud OSS: Получение Access Key ID и Access Key Secret

Tencent Cloud COS: Получение SecretId и SecretKey

Введите полученные данные в настройках резервного копирования S3. Нажмите "Backup" для создания резервной копии или "Manage" для просмотра и управления файлами резервных копий.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Используя или распространяя любую часть или элементы материалов Cherry Studio, вы признаёте и принимаете условия настоящего Соглашения, которое вступает в силу немедленно.

Настоящее Лицензионное соглашение Cherry Studio (далее – "Соглашение") регулирует условия использования, копирования, распространения и модификации Материалов.

"Мы" (или "Лицензиар") означает компанию Shanghai Qianhui Technology Co., Ltd. (上海千彗科技有限公司).

"Вы" (или "Лицензиат") означает физическое или юридическое лицо, использующее Материалы на условиях настоящего Соглашения.

"Третья сторона" означает лицо, не связанное отношениями контроля с Нами или Вами.

"Cherry Studio" означает программный комплекс, включающий (но не ограничиваясь): ядро, редакторы, плагины, примеры проектов, исходный код, документацию и сопутствующие элементы.

"Материалы" означает проприетарные разработки Cherry Studio и документацию, предоставляемую по настоящему Соглашению.

"Исходная форма" означает предпочитаемую форму для внесения изменений, включая исходный код, файлы документации и конфигурации.

"Компилированная форма" означает любую форму, полученную механической трансформацией Исходной формы (включая скомпилированный код, сгенерированную документацию).

"Коммерческое использование" означает прямое или косвенное извлечение коммерческой выгоды, включая продажи, лицензирование, подписки, рекламу, обучение, консалтинг и т.д.

"Модификация" означает любое изменение Исходной формы, включая адаптацию названия, логотипа, кода, функционала, интерфейса и т.д.

Бесплатное коммерческое использование (немодифицированный код): Мы предоставляем Вам неисключительную, всемирную, непередаваемую, безвозмездную лицензию на использование, копирование и распространение немодифицированных Материалов для коммерческих целей при соблюдении условий Соглашения.

Коммерческая лицензия (требуемые случаи): В ситуациях, описанных в Разделе 3 "Коммерческая лицензия", для реализации прав по настоящему Соглашению требуется получение письменной коммерческой лицензии от Нас.

Использование Материалов Cherry Studio требует письменной коммерческой лицензии в следующих случаях:

Модификация и производные работы: Внесение изменений в Материалы или создание производных работ (включая изменения названия, логотипа, кода, функционала, интерфейса и т.д.).

Корпоративные сервисы: Внутреннее использование или предоставление услуг на основе Cherry Studio корпоративным клиентам с поддержкой ≥ 10 пользователей.

Продажа оборудования: Предустановка или интеграция Cherry Studio в аппаратные продукты для продажи в комплекте.

Крупные закупки: Использование в рамках масштабных государственных или образовательных закупок, особенно в сферах безопасности и защиты данных.

Публичные облачные сервисы: Предоставление общедоступных облачных сервисов на базе Cherry Studio.

Вы можете распространять копии немодифицированных Материалов в Исходной или Компилированной форме при соблюдении условий:

Предоставление копии настоящего Соглашения всем получателям Материалов.

Сохранение во всех распространяемых копиях уведомления: `"Cherry Studio is licensed under the Cherry Studio LICENSE AGREEMENT, Copyright (c) 上海千彗科技有限公司. All Rights Reserved."`

Материалы могут подпадать под экспортный контроль. Используйте их в соответствии с применимым законодательством.

При использовании Материалов для создания ПО/моделей рекомендуется указать в документации: "Built with Cherry Studio" или "Powered by Cherry Studio".

Мы сохраняем все права на Материалы и производные работы. Правообладание модификациями, созданными Вами без коммерческой лицензии, остается за Нами.

Настоящим Соглашением не предоставляются права на использование товарных знаков Лицензиара.

Любые лицензии прекращаются при предъявлении Вами претензий о нарушении прав на Материалы.

Мы не обязаны поддерживать, обновлять или развивать Материалы.

Материалы предоставляются "как есть" без гарантий пригодности, безопасности или отсутствия нарушений прав третьих лиц.

Мы не несем ответственность за любой ущерб, возникший при использовании Материалов.

Вы обязуетесь возместить Нам убытки по претензиям третьих сторон, связанным с Вашим использованием Материалов.

Соглашение вступает в силу при начале использования Материалов.

При нарушении Вами условий Соглашение может быть расторгнуто. После расторжения Вы обязаны прекратить использование Материалов. Разделы 7, 9 и "2. Предоставляемые права" сохраняют силу после расторжения.

Соглашение регулируется законодательством Китайской Народной Республики.

Споры подлежат исключительной юрисдикции судов г. Шанхая.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Cherry Studio поддерживает импорт тем в базу данных Notion.

Откройте сайт Notion Integrations для создания приложения

Создайте приложение

Имя: Cherry Studio

Тип: Выберите первый вариант

Иконка: Сохраните это изображение

Скопируйте секретный ключ и вставьте его в настройки Cherry Studio

Откройте сайт Notion, создайте новую страницу, выберите тип "База данных", укажите название "Cherry Studio" и подключите по инструкции

Если URL вашей базы данных Notion выглядит так:

https://www.notion.so/<long_hash_1>?v=<long_hash_2>

то ID базы данных Notion - это часть <long_hash_1>

Укажите 页面标题字段名 (название поля заголовка страницы):

Если интерфейс на английском - введите Name

Если интерфейс на китайском - введите 名称

Поздравляем! Настройка Notion завершена ✅ Теперь вы можете экспортировать контент Cherry Studio в базу данных Notion

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Функция перевода Cherry Studio предоставляет быстрые и точные услуги по переводу текста, поддерживая взаимный перевод между множеством языков.

Интерфейс перевода состоит из следующих основных разделов:

Выбор исходного языка:

Любой язык: Cherry Studio автоматически распознает исходный язык и выполнит перевод.

Выбор целевого языка:

Выпадающее меню: выберите язык, на который нужно перевести текст.

Кнопка настроек:

При нажатии переходит к настройкам моделей по умолчанию.

Синхронизация прокрутки:

Переключает синхронизацию прокрутки (при прокрутке в любой области вторая область будет синхронно прокручиваться).

Поле ввода текста (слева):

Введите или вставьте текст для перевода.

Поле результата перевода (справа):

Отображает переведенный текст.

Кнопка копирования: копирует результат перевода в буфер обмена.

Кнопка перевода:

Нажмите эту кнопку, чтобы начать перевод.

История переводов (вверху слева):

Позволяет просмотреть историю переводов.

Выберите целевой язык:

В разделе выбора целевого языка укажите нужный язык.

Введите или вставьте текст:

Введите или вставьте текст в левое поле ввода.

Начните перевод:

Нажмите кнопку Перевести.

Просмотр и копирование результата:

Результат появится в правом поле.

Нажмите кнопку копирования, чтобы сохранить перевод в буфер обмена.

В: Что делать, если перевод неточен?

О: ИИ-перевод мощный, но не идеален. Для профессиональных текстов или сложных контекстов рекомендуется ручная проверка. Также можно попробовать сменить модель.

В: Какие языки поддерживаются?

О: Cherry Studio поддерживает множество основных языков. Полный список доступен на официальном сайте или в справке приложения.

В: Можно ли перевести целый файл?

О: Текущий интерфейс предназначен для перевода текста. Для перевода файлов используйте страницу диалогов Cherry Studio.

В: Что делать, если перевод медленный?

О: Скорость зависит от сети, длины текста и нагрузки серверов. Убедитесь в стабильности соединения и проявите терпение.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Войдите в VolcEngine

Или сразу перейдите по этой ссылке

В боковом меню выберите раздел Управление API-ключами

Создайте новый API-ключ

После создания кликните на значок глаза 🔍 рядом с ключом для просмотра и скопируйте его

Вставьте скопированный API-ключ в CherryStudio и активируйте переключатель провайдера

В разделе Управление активациями боковой панели активируйте нужные модели (серия Doubao, DeepSeek и др.)

В документе со списком моделей найдите ID нужной модели

В настройках CherryStudio откройте раздел Модели провайдеров → VolcEngine

Нажмите "Добавить" и вставьте ID модели в соответствующее поле

Повторите процедуру для добавления всех необходимых моделей

Доступно два варианта записи адреса API:

Стандартный в клиенте: https://ark.cn-beijing.volces.com/api/v3/

Альтернативный: https://ark.cn-beijing.volces.com/api/v3/chat/completions#

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Вы сталкивались с этим? Сохранили 26 полезных статей в WeChat, но больше никогда не открывали. На компьютере разбросаны 10+ файлов в папке "Учебные материалы". Хотите найти теорию, которую читали полгода назад, но помните лишь пару ключевых слов. Когда ежедневный объём информации превышает возможности мозга, 90% ценных знаний забываются за 72 часа. С помощью API платформы больших моделей Infinity AI + Cherry Studio вы можете создать личную базу знаний, превращающую пылящиеся статьи из WeChat и разрозненные учебные материалы в структурированные знания для точного доступа.

1. Сервис API Infinity AI: "Мыслительный центр" базы знаний, удобный и стабильный

Как "мыслящий центр" базы знаний, платформа больших моделей Infinity AI предоставляет такие версии моделей, как полная версия DeepSeek R1, и стабильные API-услуги. Сейчас после регистрации использование бесплатно без ограничений. Поддерживает популярные модели внедрения bge и jina для построения базы знаний. Платформа постоянно обновляет стабильные новейшие и мощные сервисы моделей с открытым исходным кодом, включая изображения, видео, аудио и другие модальности.

2. Cherry Studio: создание базы знаний без кода

Cherry Studio — это простой в использовании ИИ-инструмент. По сравнению с разработкой базы знаний RAG, которая требует 1-2 месяца на развёртывание, этот инструмент поддерживает операции без кода. Позволяет одним щелчком импортировать форматы Markdown/PDF/веб-страницы, обрабатывая 40 МБ файлов за 1 минуту. Также можно добавлять локальные папки компьютера, ссылки на статьи из избранного WeChat и заметки курсов.

Шаг 1: Подготовка

Посетите официальный сайт Cherry Studio и скачайте подходящую версию (https://cherry-ai.com/)

Зарегистрируйте аккаунт: войдите в платформу больших моделей Infinity AI (https://cloud.infini-ai.com/genstudio/model?cherrystudio)

Получение API-ключа: в разделе "Модельная площадь" выберите deepseek-r1, нажмите "Создать", получите APIKEY и скопируйте название модели

Шаг 2: В настройках CherryStudio выберите сервис Infinity AI в разделе моделей, введите API-ключ и активируйте сервис моделей Infinity AI

После выполнения этих шагов при взаимодействии выберите нужную большую модель для использования API-сервисов Infinity AI в CherryStudio. Для удобства здесь можно установить "Модель по умолчанию".

Шаг 3: Добавление базы знаний

Выберите любую версию модели внедрения серии bge или jina из платформы больших моделей Infinity AI

После импорта учебных материалов введите: "Проанализируйте вывод ключевых формул из третьей главы «Машинное обучение»"

Прилагается сгенерированное изображение результата

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

MCP (Model Context Protocol) — это открытый протокол, предназначенный для стандартизированной передачи контекстной информации крупным языковым моделям (LLM). Подробнее о MCP см. в разделе

Ниже на примере функции fetch показано, как использовать MCP в Cherry Studio. Подробности можно найти в документации.

В разделе Настройки → MCP-сервер нажмите кнопку Установить, чтобы автоматически загрузить и установить компоненты. Поскольку загрузка идёт напрямую с GitHub, скорость может быть низкой с высокой вероятностью сбоев. Успешность установки определяется наличием файлов в папках, указанных ниже.

Каталоги установки исполняемых файлов:

Windows: C:\Users\Имя_пользователя\.cherrystudio\bin

macOS/Linux: ~/.cherrystudio/bin

При проблемах с установкой:

Создайте символические ссылки на системные исполняемые файлы в указанных каталогах. При отсутствии каталогов — создайте их вручную.

Либо загрузите файлы вручную:

UV: https://github.com/astral-sh/uv/releases и разместите исполняемые файлы в соответствующем каталоге.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Создайте учётную запись и войдите на Huawei Cloud

Перейдите в консоль ModelArts, нажав на эту ссылку

Авторизация

В боковой панели перейдите в "Authentication Management", создайте и скопируйте API Key (секретный ключ)

Затем создайте нового поставщика в CherryStudio

После создания вставьте секретный ключ

В боковой панели перейдите в "Model Deployment" и активируйте все предложения

Нажмите "Call"

Скопируйте адрес из места ①, вставьте его в поле адреса поставщика в CherryStudio и добавьте в конце символ "#"

И добавьте в конце символ "#"

И добавьте в конце символ "#"

И добавьте в конце символ "#"

И добавьте в конце символ "#"

Зачем добавлять "#"? Смотрите здесь

Конечно, можно не смотреть, просто следуйте инструкциям;

Также можно использовать метод удаления v1/chat/completions при заполнении — делайте как удобно, но если не уверены, строго следуйте инструкциям.

Затем скопируйте название модели из места ②, в CherryStudio нажмите "+Add" для создания новой модели

Введите название модели без изменений и без кавычек, как показано в примере.

Нажмите "Add Model", чтобы завершить добавление.

如何注册tavily?

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Перейдите по указанному выше официальному сайту или в Cherry Studio: Настройки → Поиск в Интернете → нажмите "Получить ключ", чтобы перейти непосредственно на страницу входа/регистрации Tavily.

Если вы используете впервые, сначала зарегистрируйте аккаунт (Sign up), прежде чем войти (Log in). По умолчанию отображается страница входа.

Нажмите "Зарегистрировать аккаунт", введите свою основную электронную почту или используйте аккаунт Google/GitHub. Затем на следующем шаге создайте пароль - стандартная процедура.

🚨🚨🚨【Критический шаг】 После успешной регистрации потребуется динамическая верификация: отсканируйте QR-код для получения одноразового кода.

Есть два варианта решения:

Установите приложение для аутентификации от Microsoft — Authenticator 【сложнее】

Используйте мини-программу WeChat: Tencent Authenticator 【проще, рекомендуется】

Откройте мини-программу WeChat, найдите: Tencent Authenticator

После выполнения всех шагов вы увидите следующий интерфейс — это подтверждает успешную регистрацию. Скопируйте ключ в Cherry Studio и начинайте использовать платформу.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

В версии 0.9.1 CherryStudio представил долгожданную функцию базы знаний.

Ниже пошагово представлено подробное руководство по использованию CherryStudio.

Найдите модель в сервисе управления моделями, используя фильтр "Модели встраивания" для быстрого поиска;

Выберите нужную модель и добавьте её в "Мои модели".

Доступ к базе знаний: В левой панели инструментов CherryStudio нажмите значок базы знаний, чтобы перейти на страницу управления;

Добавление базы знаний: Нажмите "Добавить", чтобы начать создание базы знаний;

Наименование: Введите название базы знаний и добавьте модель встраивания (например, bge-m3), чтобы завершить создание.

Добавление файлов: Нажмите кнопку "Добавить файлы" для выбора файлов;

Выбор файлов: Выберите поддерживаемые форматы (pdf, docx, pptx, xlsx, txt, md, mdx и др.) и откройте их;

Векторизация: Система автоматически выполнит векторизацию. При появлении зелёной галочки (✓) процесс завершён.

CherryStudio поддерживает несколько способов добавления данных:

Папка каталога: Добавьте целую папку — поддерживаемые файлы автоматически векторизуются;

Веб-ссылка: Поддерживает URL-адреса, например ;

Карта сайта: Поддерживает XML-карты сайта, например ;

Простой текст: Поддерживает ввод пользовательского текста.

После завершения векторизации можно выполнять запросы:

Нажмите кнопку "Поиск в базе знаний" внизу страницы;

Введите запрос;

Просмотрите результаты;

Оценка релевантности отображается для каждого результата.

Создайте новый диалог. В панели инструментов нажмите "База знаний" → выберите нужную базу;

Введите вопрос — модель сгенерирует ответ на основе полученных данных;

Источники данных отображаются под ответом для быстрого просмотра.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Cherry Studio поддерживает резервное копирование данных через WebDAV. Вы можете выбрать подходящий сервис WebDAV для облачного резервного копирования.

С помощью WebDAV можно синхронизировать данные между несколькими устройствами по схеме: Компьютер A WebDAV Компьютер B.

Войдите в Nutstore, нажмите на имя пользователя в правом верхнем углу и выберите «Информация об аккаунте»:

Выберите «Настройки безопасности» и нажмите «Добавить приложение»

Введите название приложения, сгенерируется случайный пароль;

Скопируйте и сохраните пароль;

Получите адрес сервера, учетную запись и пароль;

В настройках Cherry Studio → настройках данных заполните информацию WebDAV;

Выберите резервное копирование или восстановление данных, а также можно настроить периодичность автоматического резервного копирования.

Сервисы WebDAV с низким порогом входа — это, как правило, облачные хранилища:

(требуется подписка)

(требуется покупка)

(бесплатно предоставляется 10 ГБ, ограничение на размер одного файла — 250 МБ.)

(Dropbox предоставляет 2 ГБ бесплатно, можно приглашать друзей для увеличения до 16 ГБ.)

(бесплатно предоставляется 10 ГБ, также можно получить дополнительно 5 ГБ за приглашения.)

(бесплатным пользователям предоставляется 10 ГБ.)

Кроме того, есть сервисы, которые требуют самостоятельного развертывания:

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Cherry Studio — это мультиплатформенный десктопный клиент, поддерживающий установку на Windows, Linux и MacOS. Он объединяет основные LLM-модели и предоставляет сценарную поддержку. Пользователи могут повысить эффективность работы через интеллектуальное управление диалогами, кастомизацию с открытым исходным кодом и мультитематические интерфейсы.

Cherry Studio теперь глубоко интегрирован с высокопроизводительным API-каналом PPIO — благодаря гарантиям корпоративного уровня вычислений достигается высокая скорость отклика DeepSeek-R1/V3 и доступность сервиса 99.9%, обеспечивая быстрый и плавный опыт.

В руководстве ниже представлена полная схема подключения (включая настройку ключей). Активируйте продвинутый режим «Умная маршрутизация Cherry Studio + Высокопроизводительный API PPIO» за 3 минуты.

Сначала скачайте Cherry Studio с официального сайта: (Если не открывается, используйте ссылку на Quark Disk: )

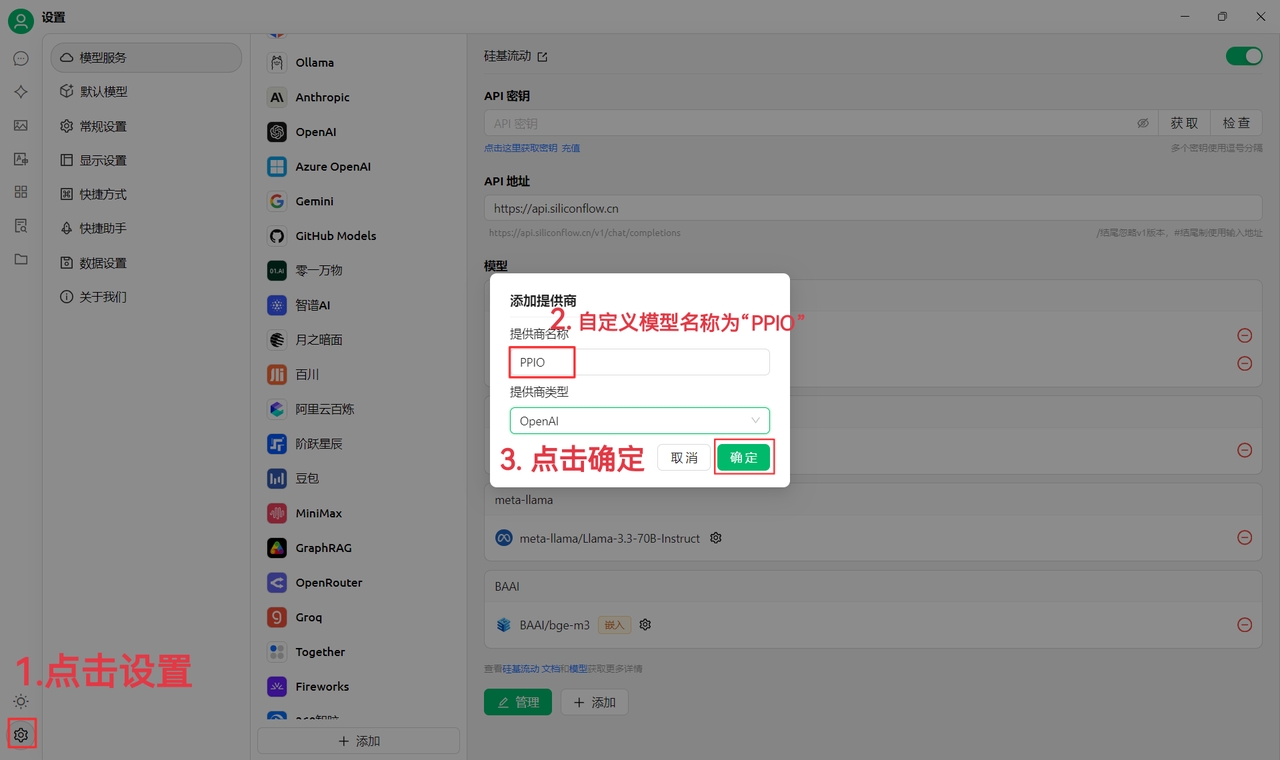

(1) Нажмите настройки в левом нижнем углу, укажите имя провайдера: PPIO, нажмите «ОК»

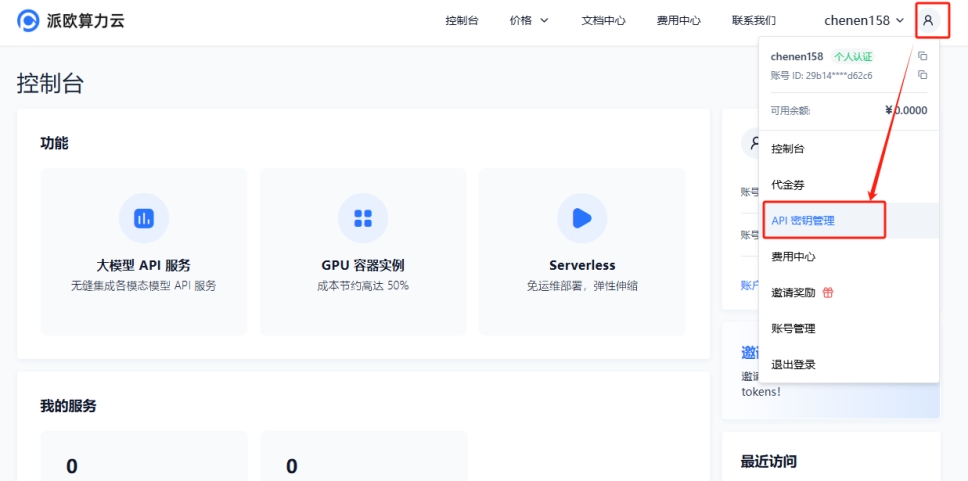

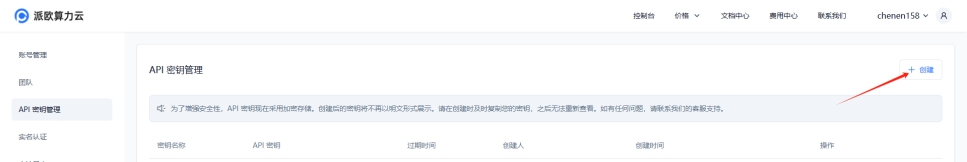

(2) Перейдите в , щёлкните на [аватар пользователя] → [Управление API-ключами]

Нажмите [+ Создать] для генерации нового ключа API. Укажите имя ключа. Ключ отображается только при создании — обязательно скопируйте и сохраните его, чтобы не прерывать дальнейшее использование

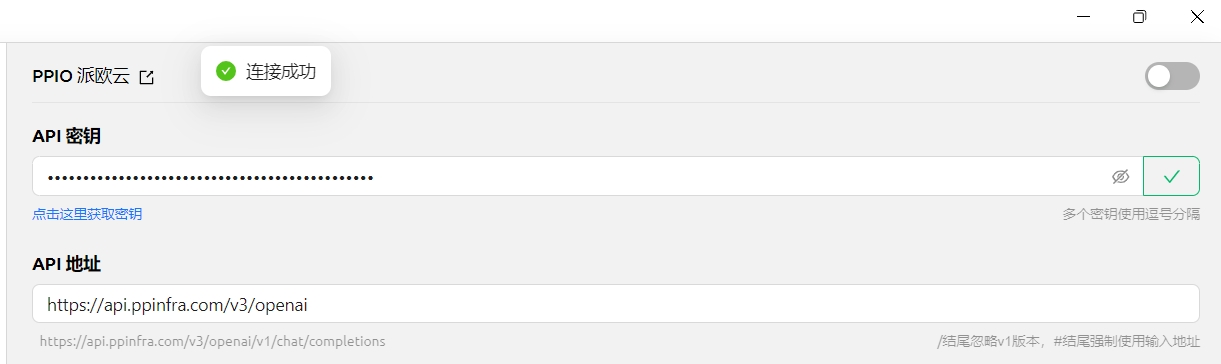

(3) Вставьте ключ в CherryStudio: выберите [PPIO Pai Ou Cloud], введите API-ключ с сайта, нажмите [Проверить]

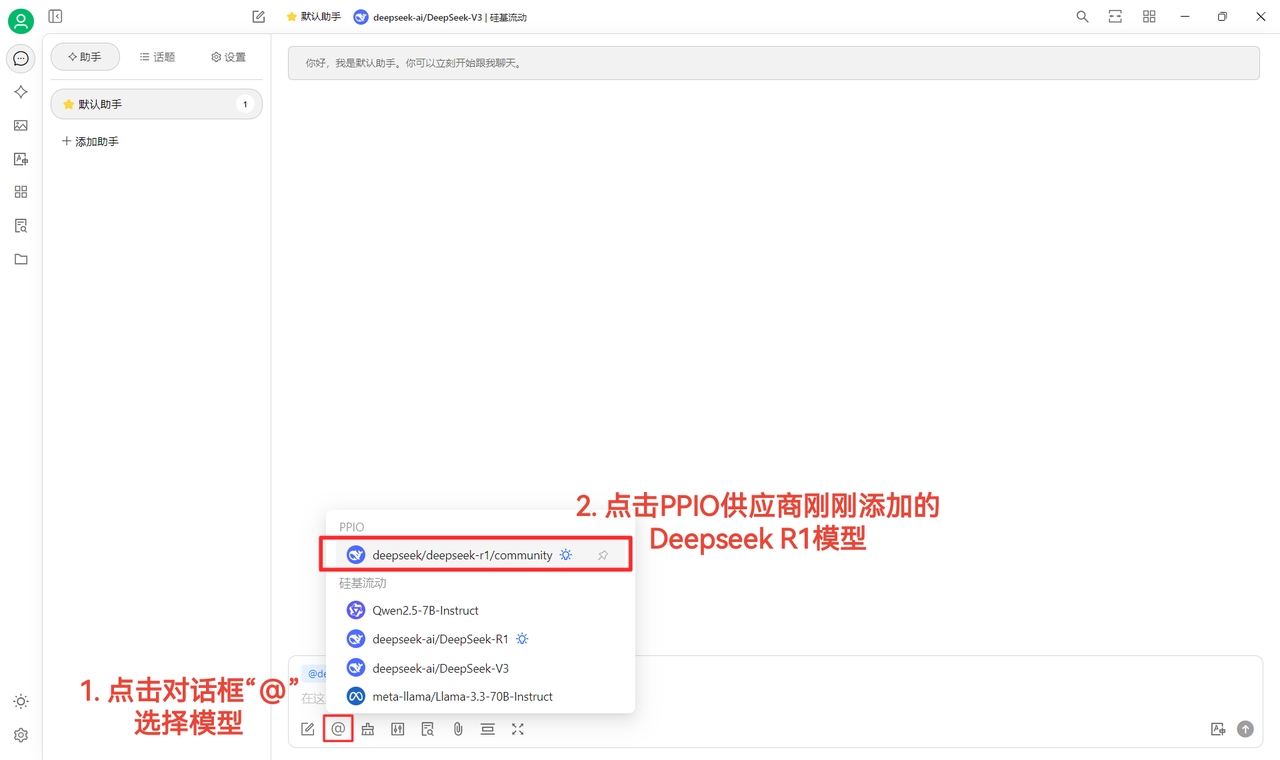

(4) Выберите модель: например, deepseek/deepseek-r1/community. Для смены модели просто выберите другую.

DeepSeek R1 и V3 community — пробные версии. Это полнофункциональные модели со всеми параметрами, без разницы в стабильности и эффективности. Для массового использования пополните счёт и переключитесь на не-community версию.

(1) После успешной [Проверки] можно использовать сервис

(2) Нажмите [@], выберите модель DeepSeek R1 от PPIO и начинайте общение~

[Источник материалов: ]

Если предпочитаете визуальное обучение — на Bilibili есть видеоурок. Пошагово поможем освоить настройку «PPIO API + Cherry Studio». Перейдите по ссылке →

[Источник видео: sola]

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Данные Cherry Studio сохраняются согласно системным стандартам и автоматически размещаются в пользовательском каталоге. Точные пути следующие:

macOS: /Users/username/Library/Application Support/CherryStudioDev

Windows: C:\Users\username\AppData\Roaming\CherryStudio

Linux: /home/username/.config/CherryStudio

Также можно посмотреть расположение здесь:

Способ 1: Создайте символическую ссылку. Завершите работу приложения, переместите данные в нужное расположение, затем создайте ссылку из оригинального пути к новому местоположению.

Подробные инструкции смотрите здесь:

Способ 2: Используйте особенности приложений Electron и измените путь через параметры запуска.

--user-data-dir Пример: Cherry-Studio-*-x64-portable.exe --user-data-dir="%user_data_dir%"

Пример реализации:

init_cherry_studio.bat (кодировка: ANSI)

Структура каталога user-data-dir после инициализации:

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Для автоматической установки MCP требуется обновление Cherry Studio до версии v1.1.18 или выше.

Помимо ручной установки, Cherry Studio включает инструмент @mcpmarket/mcp-auto-install — более простой способ установки сервера MCP. Для использования достаточно ввести соответствующую команду в диалоге с LLM-моделью, поддерживающей сервисы MCP.

Важно на этапе тестирования:

@mcpmarket/mcp-auto-install находится в бета-версии

Результат зависит от «интеллекта» LLM-модели: параметры могут добавляться автоматически, но в некоторых случаях потребуется ручная настройка параметров MCP

Поиск источников выполняется в @modelcontextprotocol, но можно настроить кастомные параметры (см. ниже)

Например, введите команду:

Система автоматически определит требования и выполнит установку через @mcpmarket/mcp-auto-install. Инструмент поддерживает различные типы серверов MCP, включая:

filesystem (файловая система)

fetch (HTTP-запросы)

sqlite (база данных)

и другие...

Переменная MCP_PACKAGE_SCOPES позволяет кастомизировать источники поиска сервисов MCP. Значение по умолчанию:

@modelcontextprotocol.

@mcpmarket/mcp-auto-install

帮我安装一个 filesystem mcp server// `axun-uUpaWEdMEMU8C61K` - пользовательский ID сервиса

"axun-uUpaWEdMEMU8C61K": {

"name": "mcp-auto-install",

"description": "Automatically install MCP services (Beta version)",

"isActive": false,

"registryUrl": "https://registry.npmmirror.com",

"command": "npx",

"args": [

"-y",

"@mcpmarket/mcp-auto-install",

"connect",

"--json"

],

"env": {

"MCP_REGISTRY_PATH": "详情见https://www.npmjs.com/package/@mcpmarket/mcp-auto-install"

},

"disabledTools": []

}

PS D:\CherryStudio> dir

目录: D:\CherryStudio

Mode LastWriteTime Length Name

---- ------------- ------ ----

d----- 2025/4/18 14:05 user-data-dir

-a---- 2025/4/14 23:05 94987175 Cherry-Studio-1.2.4-x64-portable.exe

-a---- 2025/4/18 14:05 701 init_cherry_studio.bat@title CherryStudio Initialization

@echo off

set current_path_dir=%~dp0

@echo Текущий путь:%current_path_dir%

set user_data_dir=%current_path_dir%user-data-dir

@echo Путь к данным CherryStudio:%user_data_dir%

@echo Поиск Cherry-Studio-*-portable.exe в текущей директории

setlocal enabledelayedexpansion

for /f "delims=" %%F in ('dir /b /a-d "Cherry-Studio-*-portable*.exe" 2^>nul') do ( # Этот код совместим с версиями с GitHub и с официального сайта; для других версий измените самостоятельно

set "target_file=!cd!\%%F"

goto :break

)

:break

if defined target_file (

echo Найден файл: %target_file%

) else (

echo Совпадающие файлы не найдены, выход из скрипта

pause

exit

)

@echo Подтвердите действие

pause

@echo Запуск CherryStudio

start %target_file% --user-data-dir="%user_data_dir%"

@echo Операция завершена

@echo on

exitPS D:\CherryStudio> dir .\user-data-dir\

目录: D:\CherryStudio\user-data-dir

Mode LastWriteTime Length Name

---- ------------- ------ ----

d----- 2025/4/18 14:29 blob_storage

d----- 2025/4/18 14:07 Cache

d----- 2025/4/18 14:07 Code Cache

d----- 2025/4/18 14:07 Data

d----- 2025/4/18 14:07 DawnGraphiteCache

d----- 2025/4/18 14:07 DawnWebGPUCache

d----- 2025/4/18 14:07 Dictionaries

d----- 2025/4/18 14:07 GPUCache

d----- 2025/4/18 14:07 IndexedDB

d----- 2025/4/18 14:07 Local Storage

d----- 2025/4/18 14:07 logs

d----- 2025/4/18 14:30 Network

d----- 2025/4/18 14:07 Partitions

d----- 2025/4/18 14:29 Session Storage

d----- 2025/4/18 14:07 Shared Dictionary

d----- 2025/4/18 14:07 WebStorage

-a---- 2025/4/18 14:07 36 .updaterId

-a---- 2025/4/18 14:29 20 config.json

-a---- 2025/4/18 14:07 434 Local State

-a---- 2025/4/18 14:29 57 Preferences

-a---- 2025/4/18 14:09 4096 SharedStorage

-a---- 2025/4/18 14:30 140 window-state.json

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Cherry Studio не только интегрирует ведущие сервисы ИИ-моделей, но и предоставляет мощные возможности настройки. С помощью функции Пользовательские поставщики ИИ-услуг вы можете легко подключить любую необходимую ИИ-модель.

Гибкость: Больше не ограничивайтесь предустановленным списком поставщиков, свободно выбирайте наиболее подходящие ИИ-модели.

Разнообразие: Пробуйте ИИ-модели с разных платформ, открывая их уникальные преимущества.

Контроль: Управляйте своими API-ключами и адресами доступа напрямую, обеспечивая безопасность и конфиденциальность.

Кастомизация: Интегрируйте приватно развернутые модели для специфических бизнес-задач.

Всего несколько шагов, чтобы добавить своего поставщика в Cherry Studio:

Откройте настройки: В левой панели Cherry Studio нажмите «Настройки» (значок шестерёнки).

Перейдите к моделям: На странице настроек выберите вкладку «Модели».

Добавьте поставщика: В разделе «Модели» нажмите кнопку «+ Добавить» под списком поставщиков.

Заполните данные: В открывшемся окне укажите:

Название поставщика: Присвойте узнаваемое имя (например: MyCustomOpenAI).

Тип поставщика: Выберите из выпадающего списка поддерживаемые типы:

OpenAI

Gemini

Anthropic

Azure OpenAI

Сохраните: Нажмите «Добавить» для сохранения конфигурации.

После добавления найдите поставщика в списке и настройте детали:

Статус активации: Переключатель справа в списке включает/выключает службу.

API-ключ:

Введите ключ API, полученный от поставщика.

Кнопка «Проверить» справа тестирует валидность ключа.

API-адрес:

Укажите базовый URL для доступа к API.

Сверьтесь с документацией поставщика для корректного адреса.

Управление моделями:

Нажмите «+ Добавить», чтобы вручную добавить ID модели (например gpt-3.5-turbo, gemini-pro).

* Для названий моделей обратитесь к документации поставщика. * Кнопка «Управление» позволяет редактировать или удалять добавленные модели.

После настройки выберите своего поставщика и модель в чат-интерфейсе Cherry Studio для начала работы!

vLLM — быстрая и удобная библиотека вывода LLM, аналогичная Ollama. Этапы интеграции с Cherry Studio:

Установите vLLM: Следуйте официальной инструкции (https://docs.vllm.ai/en/latest/getting_started/quickstart.html).

pip install vllm # если используете pip

uv pip install vllm # если используете uvЗапустите vLLM: Активируйте сервис через OpenAI-совместимый интерфейс двумя способами:

Через vllm.entrypoints.openai.api_server

python -m vllm.entrypoints.openai.api_server --model gpt2Через uvicorn

vllm --model gpt2 --served-model-name gpt2Сервис запустится на порту 8000 (или указанном через --port).

Добавьте vLLM в Cherry Studio:

Создайте нового поставщика по инструкции выше.

Название: vLLM

Тип: OpenAI

Настройте vLLM:

API-ключ: Оставьте пустым или введите любое значение.

API-адрес: Укажите http://localhost:8000/ (или ваш порт).

Управление моделями: Введите название запущенной модели (например gpt2).

Начните диалог: Выберите vLLM и модель в чат-интерфейсе для общения!

Изучите документацию: Перед добавлением проверьте у поставщика параметры API-ключей, адресов и моделей.

Проверяйте ключи: Используйте кнопку проверки для валидации API-ключей.

Следите за адресами: У разных поставщиков и моделей могут отличаться API-адреса.

Добавляйте нужные модели: Включайте только используемые модели, чтобы избежать перегрузки.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Присоединяйтесь к Telegram группе для получения помощи:

GitHub Issues:

Свяжитесь с разработчиками по почте: [email protected]

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Пояснения:

Сохранил маркеры списка [x]/[ ] в оригинальном формате

Технические термины и названия (SSO, JavaScript, iOS, Android) оставлены без перевода

Для 多模型回答对比 использован термин "многомодельное сравнение ответов"

全部模型支持联网 переведено как "режим 'Поиск в Интернете' для всех моделей"

推出第一个正式版 переведено как "выпуск первой стабильной версии"

Для AI 通话 использован термин "AI-звонки" (AI-calls)

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Добро пожаловать в Cherry Studio (далее "Программное обеспечение" или "Мы"). Мы придаем большое значение защите вашей конфиденциальности. Настоящая Политика конфиденциальности объясняет, как мы обрабатываем и защищаем ваши личные данные. Пожалуйста, внимательно ознакомьтесь с настоящим соглашением перед использованием программного обеспечения:

Для оптимизации пользовательского опыта и улучшения качества программного обеспечения мы можем анонимно собирать следующие не персонифицированные данные:

• Информация о версии ПО; • Частота и активность использования функций ПО; • Анонимные логи ошибок и сбоев.

Эта информация полностью анонимна, не содержит идентифицирующих данных и не может быть связана с вами.

Для максимальной защиты вашей конфиденциальности мы категорически заявляем:

• Не собираем, не храним, не передаем и не обрабатываем ваши API Keys для сервисов моделей; • Не собираем, не храним, не передаем и не обрабатываем какие-либо данные диалогов, включая контент чатов, инструкции, данные базы знаний, векторные данные или пользовательский контент; • Не собираем, не храним, не передаем и не обрабатываем любые идентифицирующие личные данные.

Программное обеспечение использует предоставленные вами API Keys сторонних провайдеров моделей для выполнения вызовов и диалоговых функций. Сервисы моделей (например, Large Language Models, API) предоставляются выбранными вами провайдерами. Cherry Studio выступает исключительно как локальный инструмент для взаимодействия с API.

Таким образом:

• Все данные диалогов между вами и сервисами моделей не относятся к Cherry Studio: мы не храним и не передаем эти данные; • Вам необходимо самостоятельно ознакомиться и принять политики конфиденциальности ваших провайдеров моделей на их официальных сайтах.

Вы самостоятельно несете риски конфиденциальности, связанные с использованием сервисов моделей. За политики обработки данных, меры безопасности и ответственность отвечают исключительно провайдеры сервисов. Мы не несем за это ответственности.

Настоящее соглашение может обновляться с выходом новых версий ПО. При внесении существенных изменений мы уведомим вас соответствующим образом.

Если у вас возникли вопросы относительно настоящего соглашения или мер защиты конфиденциальности в Cherry Studio, свяжитесь с нами.

Благодарим за выбор и доверие к Cherry Studio. Мы продолжим обеспечивать безопасные и надежные продукты.

{% hint style="danger" %}

Внимание: Для генерации изображений Gemini требуется использовать интерфейс чата, поскольку Gemini обеспечивает мультимодальное интерактивное создание изображений и не поддерживает регулировку параметров.

{% endhint %}Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

4xx (коды ошибок клиента): Обычно возникают из-за синтаксических ошибок в запросе, неудачной аутентификации или проверки подлинности.

5xx (коды ошибок сервера): Обычно вызваны проблемами на стороне сервера, такими как сбой сервера, превышение времени обработки запроса.

400

Неверный формат тела запроса

Проверьте содержимое ошибки в ответе или просмотрите сообщение об ошибке в . Действуйте согласно подсказке.

[Тип 1]: Для моделей Gemini может потребоваться привязка карты; [Тип 2]: Превышение размера данных (особенно для визуальных моделей); [Тип 3]: Использование неподдерживаемых параметров. Проверьте с чистым ассистентом; [Тип 4]: Превышение лимита контекста. Очистите контекст или уменьшите количество сообщений.

401

Ошибка аутентификации: модель не поддерживается или аккаунт заблокирован

Свяжитесь с поставщиком услуги для проверки статуса аккаунта

403

Нет прав на запрашиваемое действие

Проверьте сообщение об ошибке в диалоге или

404

Запрашиваемый ресурс не найден

Проверьте путь запроса

422

Корректный формат, но семантическая ошибка

Ошибки обработки данных (например: пустые значения; ожидалась строка, но передано число/булево значение)

429

Превышена скорость запросов

Подождите некоторое время перед повторным запросом

500

Внутренняя ошибка сервера

При постоянном возникновении обратитесь к поставщику услуги

501

Сервер не поддерживает запрашиваемую функцию

502

Неверный ответ от вышестоящего сервера

503

Сервер временно недоступен из-за перегрузки или обслуживания

504

Превышено время ожидания ответа от сервера

Нажмите на окно клиента Cherry Studio и используйте горячие клавиши: Ctrl + Shift + I (Mac: Command + Option + I)

В открывшемся окне консоли перейдите в Network → Выберите последний элемент с красным × (для диалогов: completions; для рисования: generations) → Нажмите Response для просмотра полного ответа (область ④ на изображении).

Если причина ошибки неясна, отправьте скриншот этого окна в официальном чате.

Этот метод работает не только для диалогов, но и для тестирования моделей, добавления базы знаний, рисования и других операций. Всегда открывайте консоль перед запросом.

Если формула отображается как код, проверьте наличие разделителей:

Синтаксис разделителей Встроенные формулы

Одинарный доллар:

$formula$Или

\(formula\)Отдельные блоки формул

Двойной доллар:

$$formula$$Или

\[formula\]Пример:

$$\sum_{i=1}^n x_i$$

Ошибки рендеринга/искаженный текст часто возникают при использовании китайских символов. Попробуйте переключить движок формул на KateX.

Статус модели недоступен

Убедитесь, что модель поддерживается провайдером и активна.

Использована модель без функции встраивания

Выберите специализированную модель для встраивания.

Проверьте, поддерживает ли модель распознавание изображений. В Cherry Studio модели со значком глаза поддерживают эту функцию.

Если функция не работает:

В списке моделей провайдера найдите нужную модель

Нажмите значок настроек рядом с названием

Активируйте опцию "Изображения"

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

С помощью пользовательского CSS вы можете изменить внешний вид программы, чтобы он лучше соответствовал вашим предпочтениям, например:

:root {

--color-background: #1a462788;

--color-background-soft: #1a4627aa;

--color-background-mute: #1a462766;

--navbar-background: #1a4627;

--chat-background: #1a4627;

--chat-background-user: #28b561;

--chat-background-assistant: #1a462722;

}

#content-container {

background-color: #2e5d3a !important;

}:root {

font-family: "汉仪唐美人" !important; /* Шрифт */

}

/* Цвет текста при раскрытии глубокого размышления */

.ant-collapse-content-box .markdown {

color: red;

}

/* Переменные темы */

:root {

--color-black-soft: #2a2b2a; /* Темный цвет фона */

--color-white-soft: #f8f7f2; /* Светлый цвет фона */

}

/* Темная тема */

body[theme-mode="dark"] {

/* Цвета */

--color-background: #2b2b2b; /* Темный цвет фона */

--color-background-soft: #303030; /* Светлый цвет фона */

--color-background-mute: #282c34; /* Нейтральный цвет фона */

--navbar-background: var(-–color-black-soft); /* Цвет фона панели навигации */

--chat-background: var(–-color-black-soft); /* Цвет фона чата */

--chat-background-user: #323332; /* Цвет фона сообщений пользователя */

--chat-background-assistant: #2d2e2d; /* Цвет фона сообщений ассистента */

}

/* Специфичные стили для темной темы */

body[theme-mode="dark"] {

#content-container {

background-color: var(-–chat-background-assistant) !important; /* Цвет фона контейнера контента */

}

#content-container #messages {

background-color: var(-–chat-background-assistant); /* Цвет фона сообщений */

}

.inputbar-container {

background-color: #3d3d3a; /* Цвет фона поля ввода */

border: 1px solid #5e5d5940; /* Цвет границы поля ввода */

border-radius: 8px; /* Скругление границ поля ввода */

}

/* Стили кода */

code {

background-color: #e5e5e20d; /* Цвет фона кода */

color: #ea928a; /* Цвет текста кода */

}

pre code {

color: #abb2bf; /* Цвет текста в предварительно отформатированном коде */

}

}

/* Светлая тема */

body[theme-mode="light"] {

/* Цвета */

--color-white: #ffffff; /* Белый цвет */

--color-background: #ebe8e2; /* Светлый цвет фона */

--color-background-soft: #cbc7be; /* Светлый цвет фона */

--color-background-mute: #e4e1d7; /* Нейтральный цвет фона */

--navbar-background: var(-–color-white-soft); /* Цвет фона панели навигации */

--chat-background: var(-–color-white-soft); /* Цвет фона чата */

--chat-background-user: #f8f7f2; /* Цвет фона сообщений пользователя */

--chat-background-assistant: #f6f4ec; /* Цвет фона сообщений ассистента */

}

/* Специфичные стили для светлой темы */

body[theme-mode="light"] {

#content-container {

background-color: var(-–chat-background-assistant) !important; /* Цвет фона контейнера контента */

}

#content-container #messages {

background-color: var(-–chat-background-assistant); /* Цвет фона сообщений */

}

.inputbar-container {

background-color: #ffffff; /* Цвет фона поля ввода */

border: 1px solid #87867f40; /* Цвет границы поля ввода */

border-radius: 8px; /* Скругление границ поля ввода, настройте по вкусу */

}

/* Стили кода */

code {

background-color: #3d39290d; /* Цвет фона кода */

color: #7c1b13; /* Цвет текста кода */

}

pre code {

color: #000000; /* Цвет текста в предварительно отформатированном коде */

}

}Для получения дополнительных переменных темы обратитесь к исходному коду: https://github.com/CherryHQ/cherry-studio/tree/main/src/renderer/src/assets/styles

Тематическая библиотека Cherry Studio: https://github.com/boilcy/cherrycss

Коллекция тем для Cherry Studio в китайском стиле: https://linux.do/t/topic/325119/129

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Быстрый помощник — это удобный инструмент, предоставляемый Cherry Studio, который позволяет вам быстро обращаться к функциям искусственного интеллекта из любого приложения для мгновенных операций: вопросов, переводов, обобщений и объяснений.

Откройте настройки: Перейдите в Настройки → Сочетания клавиш → Быстрый помощник.

Активируйте переключатель: Найдите и включите переключатель Быстрый помощник.

Настройте сочетание клавиш (опционально):

Для Windows по умолчанию: Ctrl + E.

Для macOS по умолчанию: ⌘ + E.

Вы можете настроить свое сочетание, чтобы избежать конфликтов или адаптировать его под ваши привычки.

Вызов: В любом приложении нажмите заданное сочетание (или комбинацию по умолчанию) для открытия быстрого помощника.

Взаимодействие: В окне быстрого помощника доступны функции:

Быстрые вопросы: Задайте любой вопрос ИИ.

Перевод текста: Введите текст для перевода.

Обобщение контента: Введите длинный текст для сжатия.

Пояснение: Введите концепт или термин для объяснения.

Закрытие: Нажмите ESC или щелкните вне окна помощника.

Конфликты сочетаний: При конфликтах с другими приложениями измените сочетание.

Дополнительные функции: Помимо указанных функций, помощник может генерировать код, изменять стили текста и т.д. — изучайте возможности во время использования.

Обратная связь: При проблемах или предложениях направляйте .

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

На этой странице вы можете настроить цветовую тему программы, макет страницы или для персонализации.

Здесь можно установить цветовую схему интерфейса по умолчанию (светлая, тёмная или в соответствии с системой).

Эти настройки определяют макет интерфейса беседы.

Расположение тем

Автоматическое переключение на тему

При включении этой настройки щелчок по имени ассистента автоматически переключит страницу на соответствующую тему.

Отображение времени темы

При включении под темой будет отображаться время её создания.

Эта настройка позволяет гибко изменять интерфейс под индивидуальные предпочтения. Подробные инструкции см. в раздела продвинутых настроек.

如何在 Cherry Studio 使用联网模式

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

В окне запроса Cherry Studio нажмите значок 【🌐】, чтобы активировать подключение.

Режим 1: Встроенная функция подключения у поставщиков моделей

Если модель изначально поддерживает интернет, после активации можно сразу использовать онлайн-функции.

Проверить поддержку подключения можно по значку 🌐 рядом с названием модели в интерфейсе чата.

Этот метод также работает на странице управления моделями для быстрой идентификации поддержки сети.

Поставщики моделей с поддержкой интернета в Cherry Studio

Google Gemini

OpenRouter (все модели)

Tencent Hunyuan

Zhipu AI

Alibaba Cloud Bailian

Особый случай: Даже без значка 🌐 некоторые модели могут работать в сети, как описано в руководстве ниже.

Режим 2: Использование сервиса Tavily для моделей без встроенной поддержки

Если модель не имеет значка 🌐, но требует обработки актуальных данных, используется сервис поиска Tavily.

При первом использовании Tavily появится окно настройки – следуйте инструкциям.

После нажатия откроется страница регистрации на официальном сайте Tavily. Зарегистрируйтесь, создайте API-ключ и вставьте его в Cherry Studio.

Инструкция по регистрации доступна в документации Tavily в этом каталоге.

Руководство по регистрации Tavily:

Интерфейс ниже подтверждает успешную регистрацию.

Тест работы: результаты показывают успешный поиск (по умолчанию выбрано 5 источников).

Внимание: Tavily имеет месячные бесплатные ограничения, превышение требует оплаты~

P.S.: При обнаружении ошибок обращайтесь в любое время.

Этот документ переведен с китайского языка с помощью ИИ и еще не был проверен.

Токены — это базовые единицы обработки текста в AI-моделях, которые можно рассматривать как минимальные "мыслительные" элементы модели. Они не полностью эквивалентны символам или словам в человеческом понимании, а представляют собой особый способ разделения текста, используемый самой моделью.

1. Токенизация китайского языка

Один иероглиф обычно кодируется в 1-2 токена

Например: "你好" ≈ 2-4 токена

2. Токенизация английского языка

Распространенные слова обычно составляют 1 токен

Длинные или редкие слова разбиваются на несколько токенов

Например:

"hello" = 1 токен

"indescribable" = 4 токена

3. Специальные символы

Пробелы, пунктуация и другие символы также занимают токены

Символ новой строки обычно составляет 1 токен

Токенизатор (Tokenizer) — это инструмент AI-модели для преобразования текста в токены. Он определяет, как входной текст разбивается на минимальные единицы, понятные модели.

1. Разные обучающие данные

Разные корпуса данных приводят к разным оптимизациям

Разный уровень поддержки многоязычности

Специальная оптимизация для конкретных областей (медицина, юриспруденция и т.д.)

2. Разные алгоритмы токенизации

BPE (Byte Pair Encoding) - OpenAI GPT series

WordPiece - Google BERT

SentencePiece - оптимален для многоязычных сценариев

3. Разные цели оптимизации

Одни фокусируются на эффективности сжатия

Другие на сохранении семантики

Третьи на скорости обработки

Один и тот же текст может иметь разное количество токенов в разных моделях:

Базовое понятие: Модель эмбеддингов — это технология преобразования высокоразмерных дискретных данных (текст, изображения и т.д.) в низкоразмерные непрерывные векторы. Этот процесс позволяет машинам лучше понимать и обрабатывать сложные данные. Представьте, что сложный пазл упрощается до простой координатной точки, сохраняющей ключевые характеристики оригинала. В экосистеме больших моделей эмбеддинги выступают "переводчиками", преобразующими информацию, понятную человеку, в числовую форму, понятную ИИ.

Принцип работы: В обработке естественного языка модели эмбеддингов сопоставляют слова с определенными позициями в векторном пространстве. В этом пространстве семантически близкие слова автоматически группируются. Например:

Векторы "король" и "королева" будут близки

Слова для домашних животных, такие как "кот" и "собака", также окажутся рядом

Семантически несвязанные слова, например "автомобиль" и "хлеб", будут далеки друг от друга

Основные сценарии применения:

Анализ текста: классификация документов, анализ тональности

Рекомендательные системы: персонализированные предложения контента

Обработка изображений: поиск похожих изображений

Поисковые системы: оптимизация семантического поиска

Ключевые преимущества:

Снижение размерности: упрощение сложных данных до управляемой векторной формы

Сохранение семантики: сохранение ключевой смысловой информации исходных данных

Вычислительная эффективность: значительное ускорение обучения и вывода моделей машинного обучения

Технологическая ценность: Модели эмбеддингов являются фундаментальным компонентом современных AI-систем, обеспечивая высококачественное представление данных для задач машинного обучения, и служат ключевой технологией для развития обработки естественного языка и компьютерного зрения.

Базовый рабочий процесс:

Этап предобработки базы знаний

Разделение документов на фрагменты (chunks) подходящего размера

Преобразование каждого фрагмента в вектор с помощью модели эмбеддингов

Сохранение векторов и исходного текста в векторной базе данных

Этап обработки запроса

Преобразование пользовательского вопроса в вектор

Поиск похожего контента в векторной базе

Передача найденного релевантного контента LLM в качестве контекста

MCP — это открытый протокол, предназначенный для стандартизированной передачи контекстной информации крупным языковым моделям (LLM).

Аналогия: MCP можно представить как "USB-флешку" для мира ИИ. Мы знаем, что флешка хранит различные файлы и при подключении к компьютеру сразу готова к использованию. Аналогично, на MCP Server можно "подключать" различные "плагины", предоставляющие контекст. LLM могут запрашивать эти плагины при необходимости, получая более богатый контекст для усиления своих возможностей.