Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

A página de Agentes Inteligentes é uma praça de assistentes onde você pode selecionar ou pesquisar por predefinições de modelos desejadas. Ao clicar em um card, o assistente será adicionado à lista de assistentes na página de conversas.

Você também pode editar e criar seus próprios assistentes nesta página.

Clique em Meus, depois em Criar Agente Inteligente para começar a criar seu assistente.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Siga nossas contas de mídia social: Twitter (X), Xiaohongshu, Weibo, Bilibili, Douyin

Junte-se às nossas comunidades: Grupo QQ (575014769), Telegram, Discord, Grupo WeChat (clique para ver)

O Cherry Studio é uma plataforma completa de assistente AI que integra funcionalidades como diálogo com múltiplos modelos, gestão de base de conhecimento, pintura AI, tradução e mais. Com design altamente personalizável, capacidades de expansão poderosas e experiência de usuário amigável, o Cherry Studio é a escolha ideal para usuários profissionais e entusiastas de IA. Tanto usuários iniciantes quanto desenvolvedores podem encontrar funcionalidades AI adequadas para melhorar eficiência e criatividade.

Respostas Múltiplas: Permite gerar respostas simultâneas de múltiplos modelos para a mesma pergunta, facilitando comparações (detalhes na Interface de Conversação).

Agrupamento Automático: Histórico de conversas organizado automaticamente para acesso rápido.

Exportação de Conversas: Suporte para exportação em múltiplos formatos (Markdown, Word, etc.).

Parâmetros Personalizáveis: Ajustes avançados e parâmetros personalizados para necessidades específicas.

Mercado de Assistentes: Mais de mil assistentes especializados em tradução, programação, redação e suporte para criação personalizada.

Renderização Multi-formato: Suporte para Markdown, fórmulas matemáticas e visualização HTML em tempo real.

Pintura AI: Painel dedicado para geração de imagens por descrição textual.

Mini Programas AI: Diversas ferramentas AI gratuitas integradas sem necessidade de alternar navegadores.

Tradução: Suporte para painel de tradução, tradução em conversas e tradução de prompts.

Gestão de Arquivos: Arquivos organizados por categorias em conversas, arte e base de conhecimento.

Busca Global: Localização rápida em histórico e base de conhecimento.

Agregação de Modelos: Integra modelos de OpenAI, Gemini, Anthropic, Azure em interface única.

Listagem Automática: Obtenção automática da lista completa de modelos sem configuração manual.

Rotação de Chaves API: Gerencia múltiplas chaves para evitar limites de taxa.

Avatares Personalizados: Avatar dedicado para cada modelo reconhecível.

Provedores Customizáveis: Suporte para provedores compatíveis com OpenAI/Gemini/Anthropic.

CSS Personalizado: Personalização global de estilos visuais.

Layouts de Conversa: Opções de lista ou formato de bolhas com estilização customizada.

Avatares Personalizados: Personalização de avatar para software e assistentes.

Menu Lateral Configurável: Ocultar/reordenar funcionalidades do menu lateral.

Suporte Multi-formato: Importação de PDF, DOCX, PPTX, XLSX, TXT, MD.

Múltiplas Fontes: Ficheiros locais, URLs, mapas de site ou conteúdo manual.

Exportação de Base de Conhecimento: Compartilhamento de bases processadas.

Teste de Busca Integrado: Verificação imediata de segmentação após importação.

Perguntas Rápidas: Assistente instantâneo em qualquer contexto (WeChat, navegador).

Tradução Instantânea: Tradução rápida de palavras/textos em qualquer aplicativo.

Resumo de Conteúdo: Sumarização de textos longos para extração eficiente.

Explicação Simples: Compreensão de conceitos sem prompts complexos.

Múltiplos Backups: Backup local, WebDAV e agendado.

Uso Totalmente Local: Integração com modelos locais para evitar vazamentos.

Simplicidade: Cherry Studio simplifica o uso de AI para iniciantes.

Documentação Completa: Manuais detalhados de uso e solução de problemas.

Atualizações Contínuas: Melhorias frequentes baseadas em feedback.

Código Aberto: Personalização e expansão via código fonte.

Gestão de Conhecimento: Construção e consulta de bases especializadas para pesquisa/educação.

Criação com Múltiplos Modelos: Geração de conteúdo e informação simultânea.

Tradução e Automação: Processamento de documentos e comunicação multilíngue.

Arte e Design AI: Geração de imagens criativas por descrição textual.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Endereço oficial de referência do modelo

Doubao-embedding

4095

Doubao-embedding-vision

8191

Doubao-embedding-large

4095

Endereço oficial de referência do modelo

text-embedding-v3

8192

text-embedding-v2

2048

text-embedding-v1

2048

text-embedding-async-v2

2048

text-embedding-async-v1

2048

Endereço oficial de referência do modelo

text-embedding-3-small

8191

text-embedding-3-large

8191

text-embedding-ada-002

8191

Endereço oficial de referência do modelo

Embedding-V1

384

tao-8k

8192

Endereço oficial de referência do modelo

embedding-2

1024

embedding-3

2048

Endereço oficial de referência do modelo

hunyuan-embedding

1024

Endereço oficial de referência do modelo

Baichuan-Text-Embedding

512

Endereço oficial de referência do modelo

M2-BERT-80M-2K-Retrieval

2048

M2-BERT-80M-8K-Retrieval

8192

M2-BERT-80M-32K-Retrieval

32768

UAE-Large-v1

512

BGE-Large-EN-v1.5

512

BGE-Base-EN-v1.5

512

Endereço oficial de referência do modelo

jina-embedding-b-en-v1

512

jina-embeddings-v2-base-en

8191

jina-embeddings-v2-base-zh

8191

jina-embeddings-v2-base-de

8191

jina-embeddings-v2-base-code

8191

jina-embeddings-v2-base-es

8191

jina-colbert-v1-en

8191

jina-reranker-v1-base-en

8191

jina-reranker-v1-turbo-en

8191

jina-reranker-v1-tiny-en

8191

jina-clip-v1

8191

jina-reranker-v2-base-multilingual

8191

reader-lm-1.5b

256000

reader-lm-0.5b

256000

jina-colbert-v2

8191

jina-embeddings-v3

8191

Endereço oficial de referência do modelo

BAAI/bge-m3

8191

netease-youdao/bce-embedding-base_v1

512

BAAI/bge-large-zh-v1.5

512

BAAI/bge-large-en-v1.5

512

Pro/BAAI/bge-m3

8191

Endereço oficial de referência do modelo

text-embedding-004

2048

Endereço oficial de referência do modelo

nomic-embed-text-v1

8192

nomic-embed-text-v1.5

8192

gte-multilingual-base

8192

Endereço oficial de referência do modelo

embedding-query

4000

embedding-passage

4000

Endereço oficial de referência do modelo

embed-english-v3.0

512

embed-english-light-v3.0

512

embed-multilingual-v3.0

512

embed-multilingual-light-v3.0

512

embed-english-v2.0

512

embed-english-light-v2.0

512

embed-multilingual-v2.0

256

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Use este método para limpar as configurações CSS quando configurar um CSS incorreto ou quando não conseguir acessar a interface de configurações após definir o CSS.

Abra o console: clique na janela do CherryStudio e pressione Ctrl+Shift+I (MacOS: command+option+I).

Na janela do console exibida, clique em Console

Digite manualmente document.getElementById('user-defined-custom-css').remove() (copiar e colar provavelmente não funcionará).

Pressione Enter após digitar para limpar as configurações CSS, depois retorne às configurações de exibição do CherryStudio para remover o código CSS problemático.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Atualmente, a funcionalidade de desenho suporta modelos de geração de imagens de DMXAPI, TokenFlux, AiHubMix e SiliconFlow. Você pode registrar uma conta no SiliconFlow e adicioná-lo como provedor para utilização.

Para dúvidas sobre os parâmetros, passe o mouse sobre o ? na área correspondente para ver as instruções.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Os dados adicionados à base de conhecimento do Cherry Studio são armazenados localmente. Durante o processo de adição, uma cópia do documento é colocada no diretório de armazenamento de dados do Cherry Studio.

Banco de dados vetorial: https://turso.tech/libsql

Após os documentos serem adicionados à base de conhecimento do Cherry Studio, os arquivos são divididos em vários fragmentos. Esses fragmentos são então processados pelo modelo de embedding.

Ao usar o modelo de linguagem grande para Q&A, fragmentos de texto relevantes à pergunta são recuperados e enviados ao modelo de linguagem grande para processamento.

Se houver requisitos de privacidade de dados, recomenda-se usar um banco de dados de embedding local e um modelo de linguagem grande local.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Antes de obter a chave API do Gemini, você precisa ter um projeto no Google Cloud (se já tiver, pode pular esta etapa).

Acesse o para criar um projeto, preencha o nome do projeto e clique em "Criar projeto".

Na página oficial de , clique em Chave secreta Criar chave API.

Copie a chave gerada e abra as do CherryStudio.

Encontre o fornecedor Gemini e insira a chave obtida.

Clique em "Gerenciar" ou "Adicionar" na parte inferior, inclua os modelos suportados e ative o interruptor do fornecedor no canto superior direito para começar a usar.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Observações sobre a tradução:

Seguindo as regras, traduzi apenas o conteúdo textual ("安装教程" ➔ "Tutorial de Instalação")

Mantive inalterada a estrutura de cabeçalho (#) conforme solicitado

Não foram adicionados elementos extras ou explicações

Esta é a tradução padrão para PT-BR utilizada em documentação técnica

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

1.2 Clique nas configurações no canto inferior esquerdo e selecione SiliconFlow nos Serviços de Modelos

1.2 Clique no link para obter a chave de API do SiliconCloud

Faça login no SiliconCloud (se não estiver registado, o primeiro login criará automaticamente uma conta)

Acesse Chaves API para criar uma nova ou copiar uma chave existente

1.3 Clique em Gerenciar para adicionar modelos

Clique no botão "Conversa" na barra lateral esquerda

Digite texto no campo de entrada para iniciar o bate-papo

Selecione os nomes dos modelos no menu superior para alternar entre modelos

暂时不支持Claude模型

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Antes de obter a chave de API do Gemini, você precisa ter um projeto no Google Cloud (se já tiver, pule esta etapa)

Acesse o Google Cloud para criar um projeto, preencha o nome do projeto e clique em "Criar projeto"

Acesse o console do Vertex AI

No projeto criado, ative a API Vertex AI

Abra a página de permissões de contas de serviço e crie uma conta de serviço

Na página de gerenciamento de contas de serviço, localize a conta recém-criada, clique em Chaves e crie uma nova chave no formato JSON

Após a criação bem-sucedida, o arquivo de chave será salvo automaticamente em seu computador no formato JSON. Guarde-o cuidadosamente

Selecione o provedor Vertex AI

Preencha os campos correspondentes com os dados do arquivo JSON

Clique em Adicionar Modelo e você já pode começar a usar!

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Nesta página você pode configurar o tema de cores do software, o layout da página ou CSS personalizado para fazer algumas personalizações.

Aqui você pode configurar o modo de cor padrão da interface (modo claro, modo escuro ou seguir o sistema)

Esta configuração é para o layout da interface de conversa.

Posição do Tópico

Alternar automaticamente para tópico

Quando ativado, clicar no nome do assistente mudará automaticamente para a página do tópico correspondente.

Mostrar hora do tópico

Quando ativado, mostra a hora de criação do tópico abaixo do tópico.

Esta configuração permite fazer alterações e ajustes personalizados na interface de forma flexível. Para métodos específicos, consulte CSS personalizado no tutorial avançado.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Esta página apenas apresenta as funcionalidades da interface. Para tutoriais de configuração, consulte o tutorial de Configuração do Provedor no guia básico.

No Cherry Studio, um único provedor suporta múltiplas chaves em rodízio sequencial.

Adicione múltiplas chaves separadas por vírgulas inglesas:

sk-xxxx1,sk-xxxx2,sk-xxxx3,sk-xxxx4Sempre use vírgulas em inglês.

Geralmente não é necessário preencher ao usar provedores internos. Se precisar modificar, siga estritamente o endereço da documentação oficial.

Se o provedor fornecer um endereço como https://xxx.xxx.com/v1/chat/completions, insira apenas a parte base (https://xxx.xxx.com).

O Cherry Studio completará automaticamente o caminho (/v1/chat/completions). Formato incorreto pode causar falhas.

Clique em Gerenciar (canto inferior esquerdo) para ver os modelos suportados. Clique no + ao lado de cada modelo para adicioná-lo à lista.

Clique no botão de verificação ao lado do campo da chave para testar a configuração.

Ative o interruptor no canto superior direito após configurar, caso contrário o provedor permanecerá inativo.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Suporta a exportação de tópicos e mensagens para o SiYuan Notes.

Abra o SiYuan Notes e crie um caderno

Abra as configurações do caderno e copie o ID do Caderno

Cole o ID do caderno nas configurações do Cherry Studio

Insira o endereço do SiYuan Notes

Local

Normalmente http://127.0.0.1:6806

Auto-hospedado

Seu domínio http://note.dominio.com

Copie o Token de API do SiYuan Notes

Cole nas configurações do Cherry Studio e verifique

Parabéns! A configuração do SiYuan Notes está completa ✅ Agora você pode exportar conteúdo do Cherry Studio para seu SiYuan Notes

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Vá até o site para criar uma conta e fazer login

Clique para acessar o console do Maa S

Autorização

Clique em "Gestão de Autenticação" na barra lateral, crie uma API Key (chave secreta) e copie-a

Em seguida, crie um novo provedor no CherryStudio

Após criar, cole a chave secreta

Clique em "Model Deployment" na barra lateral e ative todas as opções

Clique em "Invoke"

Copie o endereço em ① e cole no campo de endereço do provedor do CherryStudio, adicionando "#" ao final e adicione "#" ao final e adicione "#" ao final e adicione "#" ao final e adicione "#" ao final

Por que adicionar "#"?

Você também pode ignorar e seguir o tutorial diretamente; Ou usar o método de excluir "v1/chat/completions" - preencha como preferir, mas siga rigorosamente o tutorial se não tiver experiência.

Copie o nome do modelo em ②, clique em "+ Adicionar" no CherryStudio para criar novo modelo

Digite o nome do modelo exatamente como exibido, sem adicionar elementos extras ou aspas.

Clique em "Adicionar Modelo" para concluir.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Abra as configurações do Cherry Studio.

Encontre a opção Servidor MCP.

Clique em Adicionar Servidor.

Preencha os parâmetros relevantes do MCP Server (). Os campos que podem ser necessários incluem:

Nome: Personalize um nome, por exemplo fetch-server

Tipo: Selecione STDIO

Comando: Preencha uvx

Parâmetros: Preencha mcp-server-fetch

(Pode haver outros parâmetros dependendo do servidor específico)

Clique em Salvar.

Após concluir a configuração acima, o Cherry Studio irá baixar automaticamente o MCP Server necessário - fetch server. Após o download ser concluído, podemos começar a usar! Observação: Se a configuração do mcp-server-fetch não for bem-sucedida, tente reiniciar o computador.

Servidor MCP adicionado com sucesso nas configurações

Como pode ser visto na imagem acima, após combinar a funcionalidade fetch do MCP, o Cherry Studio consegue entender melhor a intenção de consulta do usuário, obter informações relevantes da internet e fornecer respostas mais precisas e abrangentes.

Monaspace

英文字体 可商用

A GitHub lançou a família de fontes de código aberto chamada Monaspace, com cinco estilos disponíveis: Neon (estilo moderno), Argon (estilo humanístico), Xenon (estilo serif), Radon (estilo manuscrito) e Krypton (estilo mecânico).

MiSans Global

多语言 可商用

O MiSans Global é um projeto de personalização de fontes multilíngues liderado pela Xiaomi, em colaboração com a Monotype e a HanYi Font.

Trata-se de uma família de fontes abrangente, cobrindo mais de 20 sistemas de escrita e suportando mais de 600 idiomas.

mcp-server-time

--local-timezone

<seu fuso horário padrão, por exemplo: Asia/Shanghai>

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Quando um assistente não possui um modelo padrão configurado, o modelo selecionado por padrão em novas conversas será o modelo definido aqui.

A otimização de prompts e o assistente de seleção de texto também utilizam o modelo configurado nesta seção.

Após cada conversa, um modelo é acionado para gerar um nome para o tópico da conversa. O modelo configurado aqui é utilizado para essa nomeação.

As funções de tradução nas caixas de entrada de conversas, pintura e outros campos, bem como os modelos de tradução na interface de tradução, utilizam o modelo definido aqui.

O modelo utilizado pela funcionalidade do Assistente Rápido, detalhado em Assistente Rápido.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Esta interface permite operações como backup de dados do cliente em nuvem e local, consulta do diretório de dados local e limpeza de cache.

Atualmente, o backup de dados é suportado apenas através do método WebDAV. Você pode escolher serviços compatíveis com WebDAV para fazer backup na nuvem.

Também é possível sincronizar dados em múltiplos dispositivos usando o método:

Computador A WebDAV Computador B.

Exemplo usando Nutstore

Faça login no Nutstore, clique no nome de usuário no canto superior direito e selecione "Informações da conta":

Selecione "Opções de segurança" e clique em "Adicionar aplicativo":

Insira o nome do aplicativo e gere uma senha aleatória:

Copie e registre a senha:

Obtenha o endereço do servidor, nome de usuário e senha:

No Cherry Studio Configurações > Configurações de Dados, preencha as informações WebDAV:

Selecione fazer backup ou restaurar dados e configure o intervalo de backup automático:

Serviços WebDAV com baixo limite de acesso geralmente são serviços de armazenamento em nuvem:

123Pan (requer assinatura)

AliPan (requer compra)

Box (espaço gratuito de 10GB, limite de 250MB por arquivo)

Dropbox (2GB gratuito, ampliável para 16GB com convites)

TeraCloud (10GB gratuito, +5GB com convites)

Yandex Disk (10GB gratuito)

Serviços que exigem autoimplatação:

如何在 Cherry Studio 使用联网模式

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Na janela de perguntas do Cherry Studio, clique no ícone 【Globo Terrestre】 para ativar a conexão à internet.

Modo 1: A capacidade de conexão nativa dos grandes modelos dos provedores

Nesse caso, após ativar a conexão, você pode usar diretamente o serviço online, o que é muito simples.

Você pode verificar rapidamente se o modelo suporta conexão à internet observando se há um ícone de mapa pequeno ao lado do nome do modelo na parte superior da interface de perguntas e respostas.

Na página de gerenciamento de modelos, este método também permite identificar rapidamente quais modelos suportam conexão à internet.

Provedores de modelos com suporte de conexão atualmente no Cherry Studio:

Google Gemini

OpenRouter (todos os modelos suportam conexão)

Tencent Hunyuan

Zhipu AI

Alibaba Cloud Bailian, etc.

Atenção especial: Existe uma situação excepcional em que o modelo pode realizar conexão mesmo sem o ícone do globo, como explicado no tutorial abaixo.

Modo 2: Usar o serviço Tavily para habilitar conexão em modelos não nativos

Quando usamos grandes modelos sem capacidade de conexão nativa (sem ícone de globo) e precisamos acessar informações em tempo real, utilizamos o serviço de pesquisa na web do Tavily.

No primeiro uso do Tavily, uma janela pop-up solicitará configurações. Siga as instruções - é muito simples!

Após clicar, você será redirecionado para a página de login/registro do site oficial do Tavily. Após registrar e fazer login, crie uma API key e cole-a no Cherry Studio.

Se precisar de ajuda com o registro, consulte o tutorial de registro Tavily neste mesmo diretório.

Documento de referência para registro no Tavily:

A interface abaixo indica que o registro foi bem-sucedido.

Teste novamente para ver o efeito. O resultado mostra que a pesquisa online está funcionando, com o número padrão de resultados definido como 5.

Nota: O Tavily tem limites gratuitos mensais; o uso excedente requer pagamento.

PS: Se encontrar erros, sinta-se à vontade para entrar em contato a qualquer momento.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Faça login no Volcano Engine

Clique diretamente aqui para acessar

Clique em Gerenciamento de Chave API na barra lateral inferior

Crie uma Chave API

Após criar com sucesso, clique no ícone de olho 👁️ ao lado da Chave API e copie

Cole a Chave API copiada no CherryStudio e ative o interruptor do provedor.

Na barra lateral do Console Ark, acesse Gerenciamento de Ativação para ativar os modelos necessários. Você pode ativar conforme necessidade os modelos da série Doubao e DeepSeek.

No documento da lista de modelos, localize o Model ID correspondente ao modelo desejado.

Acesse as configurações de Serviço de Modelos do Cherry Studio, encontre "Volcano Engine"

Clique em adicionar e cole o Model ID obtido anteriormente na caixa de texto Model ID

Repita este processo para adicionar modelos sequencialmente

Existem duas formas de escrever o endereço da API:

Primeira (padrão do cliente): https://ark.cn-beijing.volces.com/api/v3/

Segunda: https://ark.cn-beijing.volces.com/api/v3/chat/completions#

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

A função de tradução do Cherry Studio oferece serviços de tradução de texto rápidos e precisos, suportando traduções mútuas entre diversos idiomas.

A interface de tradução é composta principalmente pelas seguintes partes:

Área de seleção do idioma de origem:

Idioma qualquer: O Cherry Studio identificará automaticamente o idioma de origem e realizará a tradução.

Área de seleção do idioma de destino:

Menu suspenso: Selecione o idioma para o qual deseja traduzir o texto.

Botão de configurações:

Ao clicar, redirecionará para as Configurações de Modelo Padrão.

Sincronização de rolagem:

Alterna a sincronização de rolagem (ao rolar em qualquer lado, o outro acompanhará).

Campo de entrada de texto (esquerdo):

Insira ou cole o texto que precisa ser traduzido.

Caixa de resultados da tradução (direita):

Exibe o texto traduzido.

Botão de cópia: Clique para copiar o resultado da tradução para a área de transferência.

Botão de traduzir:

Clique neste botão para iniciar a tradução.

Histórico de traduções (canto superior esquerdo):

Ao clicar, é possível visualizar o histórico de traduções.

Selecione o idioma de destino:

Na área de seleção de idioma de destino, escolha o idioma desejado.

Insira ou cole o texto:

Digite ou cole o texto a ser traduzido no campo de entrada à esquerda.

Inicie a tradução:

Clique no botão Traduzir.

Visualize e copie o resultado:

Os resultados aparecerão na caixa de tradução à direita.

Clique no botão de cópia para copiar os resultados para a área de transferência.

P: O que fazer se a tradução não for precisa?

R: A tradução por IA, embora avançada, não é perfeita. Para textos técnicos ou contextos complexos, recomendamos revisão humana. Você também pode tentar alternar entre diferentes modelos.

P: Quais idiomas são suportados?

R: O Cherry Studio oferece suporte a múltiplos idiomas principais. Consulte o site oficial ou as instruções no aplicativo para a lista completa.

P: É possível traduzir arquivos inteiros?

R: A interface atual é focada em tradução de textos. Para arquivos, acesse a página de conversa do Cherry Studio e adicione o arquivo para tradução.

P: Como lidar com traduções lentas?

R: A velocidade pode variar devido à conexão de internet, extensão do texto ou carga do servidor. Garanta uma conexão estável e aguarde pacientemente.

Windows 版本安装教程

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Atenção: O sistema Windows 7 não suporta a instalação do Cherry Studio.

Clique em baixar e selecione a versão apropriada

Se o navegador avisar que o arquivo não é confiável, etc., basta escolher manter o arquivo.

Escolher manter→Confiar no Cherry-Studio

macOS 版本安装教程

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Primeiro, acesse a página de download no site oficial e clique para baixar a versão para Mac, ou clique no link direto abaixo.

Observe que você deve baixar a versão correspondente ao chip do seu Mac {% hint style="info" %} Se você não sabe qual versão de chip o seu Mac deve usar:

Clique no menu no canto superior esquerdo do Mac

No menu expandido, clique em "Sobre este Mac"

Na janela que aparece, verifique as informações do processador

Se for um chip Intel, baixe o pacote de instalação da versão Intel.

Se for um chip Apple M*, baixe o pacote de instalação para chips Apple. {% endhint %}

Após o download, clique aqui

Arraste o ícone para instalar

No Launchpad, busque o ícone do Cherry Studio e clique nele. Se a tela principal do Cherry Studio abrir, a instalação foi bem-sucedida.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Faça login e acesse a página de tokens

Clique em Adicionar Token

Insira o nome do token e clique em Enviar (defina outras configurações conforme necessário)

Acesse as configurações de provedor do CherryStudio e clique em Adicionar no final da lista de provedores

Digite um nome de referência, selecione OpenAI como provedor e clique em Confirmar

Cole a chave copiada anteriormente

Volte à página de obtenção da API Key e copie o endereço base na barra de URL do navegador, por exemplo:

Adicione modelos (clique em Gerenciar para obter automaticamente ou insira manualmente) e ative o botão no canto superior direito para usar.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

O Assistente Rápido é uma ferramenta conveniente fornecida pelo Cherry Studio que permite acessar rapidamente funções de IA em qualquer aplicativo, possibilitando operações como questionamentos instantâneos, tradução, resumo e explicação.

Abrir configurações: Navegue até Configurações -> Atalhos -> Assistente Rápido.

Ativar alternador: Localize e ative o botão correspondente ao Assistente Rápido.

Configurar atalho (opcional):

Atalho padrão para Windows: Ctrl + E.

Atalho padrão para macOS: ⌘ + E.

Você pode personalizar o atalho aqui para evitar conflitos ou adaptá-lo ao seu fluxo de trabalho.

Ativar: Em qualquer aplicativo, pressione o atalho configurado (ou o padrão) para abrir o Assistente Rápido.

Interagir: Na janela do Assistente Rápido, você pode realizar diretamente as seguintes operações:

Pergunta rápida: Faça qualquer pergunta à IA.

Tradução de texto: Insira o texto que precisa ser traduzido.

Resumo de conteúdo: Insira textos longos para síntese.

Explicação: Insira conceitos ou termos que precisam ser elucidados.

Fechar: Pressione a tecla ESC ou clique em qualquer área fora da janela do Assistente Rápido para fechá-la.

Conflito de atalhos: Se o atalho padrão entrar em conflito com outro aplicativo, modifique-o.

Explore mais funções: Além das funcionalidades mencionadas, o Assistente Rápido pode suportar outras operações como geração de código, conversão de estilo, etc. Recomendamos explorar durante o uso.

Feedback e melhorias: Caso encontre problemas ou tenha sugestões, à equipe do Cherry Studio.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Para usar o GitHub Copilot, primeiro você precisa ter uma conta no GitHub e assinar o serviço GitHub Copilot. A assinatura gratuita (free) também funciona, mas a versão gratuita não suporta o modelo mais recente Claude 3.7. Para detalhes, consulte o .

Clique em "Login GitHub" para obter o Device Code e copie-o.

Após obter o Device Code com sucesso, clique no link para abrir o navegador. Faça login na sua conta GitHub no navegador, insira o Device Code e autorize o acesso.

Após a autorização bem-sucedida, retorne ao Cherry Studio e clique em "Conectar GitHub". Após a conexão bem-sucedida, seu nome de usuário e avatar do GitHub serão exibidos.

Clique no botão "Gerenciar" abaixo para buscar automaticamente via internet a lista de modelos suportados atualmente.

Atualmente, usamos o Axios para construir solicitações. O Axios não suporta proxy SOCKS. Use proxy de sistema, proxy HTTP ou não configure proxy no CherryStudio, utilizando um proxy global. Primeiro, certifique-se de que sua conexão de rede esteja normal para evitar falhas ao obter o Device Code.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

O pré-processamento de documentos da base de conhecimento requer a atualização do Cherry Studio para a versão v1.4.8 ou superior.

Após clicar em "Obter chave de API", o endereço de inscrição será aberto no navegador. Clique em "Aplicar imediatamente", preencha o formulário para obter a chave de API e insira-a no campo correspondente.

Na base de conhecimento já criada, configure conforme mostrado acima para concluir o pré-processamento de documentos.

É possível verificar os resultados da base de conhecimento através da pesquisa no canto superior direito

Dicas de uso da base de conhecimento: Ao usar modelos mais poderosos, altere o modo de pesquisa para "reconhecimento de intenção". Isso permite descrever sua pergunta com maior precisão e amplitude.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Aceitamos contribuições para o Cherry Studio! Você pode contribuir das seguintes formas:

1. Contribuir com código: Desenvolver novos recursos ou otimizar o código existente. 2. Corrigir erros: Enviar correções de erros que você encontrou. 3. Manter problemas: Ajudar a gerenciar problemas no GitHub. 4. Design de produto: Participar de discussões de design. 5. Escrever documentação: Melhorar manuais e guias do usuário. 6. Envolvimento na comunidade: Participar de discussões e ajudar usuários. 7. Promover o uso: Divulgar o Cherry Studio.

Envie e-mail para

Assunto: 申请成为开发者 Conteúdo: 申请理由

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Instalação automática do serviço MCP (beta)

Implementação baseada em grafo de conhecimento local para memória persistente. Isso permite que o modelo se lembre de informações relevantes do usuário entre diferentes conversas.

MEMORY_FILE_PATH=/path/to/your/file.jsonUma implementação de servidor MCP que fornece ferramentas para resolução dinâmica e reflexiva de problemas através de processos de pensamento estruturados.

Uma implementação de servidor MCP que integra a API de busca Brave, oferecendo funcionalidade dupla de pesquisa na web e pesquisa local.

BRAVE_API_KEY=YOUR_API_KEYServidor MCP para obter conteúdo de páginas da web a partir de URLs.

Servidor Node.js que implementa o Model Context Protocol (MCP) para operações de sistema de arquivos.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Bem-vindo ao Cherry Studio (doravante referido como "este software" ou "nós"). Valorizamos profundamente a proteção da sua privacidade, e esta Política de Privacidade explicará como tratamos e protegemos suas informações e dados pessoais. Por favor, leia e compreenda cuidadosamente este acordo antes de utilizar este software:

Para otimizar a experiência do usuário e melhorar a qualidade do software, podemos coletar anonimamente as seguintes informações não pessoais:

• Informações da versão do software; • Atividade e frequência de uso das funcionalidades; • Informações anônimas de logs de falhas e erros;

Essas informações são completamente anônimas, não envolvem nenhum dado de identidade pessoal e não podem ser vinculadas às suas informações pessoais.

Para proteger ao máximo sua privacidade, comprometemo-nos expressamente com o seguinte:

• Não coletamos, armazenamos, transmitimos ou processamos suas chaves de API de serviços de modelos inseridas neste software; • Não coletamos, armazenamos, transmitimos ou processamos quaisquer dados de conversa gerados durante o uso do software, incluindo mas não limitado a: conteúdo de chats, informações de comandos, dados de bases de conhecimento, vetores de dados ou outros conteúdos personalizados; • Não coletamos, armazenamos, transmitimos ou processamos qualquer informação sensível que possa identificar pessoalmente.

Este software utiliza chaves de API de provedores de serviços de modelos terceirizados solicitadas e configuradas por você para realizar chamadas de modelos e funcionalidades de conversação. Os serviços de modelo utilizados (como LLMs, interfaces de API, etc.) são fornecidos e inteiramente responsabilizados pelo provedor terceirizado de sua escolha. O Cherry Studio atua apenas como uma ferramenta local que fornece funcionalidades de interface para serviços de modelos terceirizados.

Portanto:

• Todos os dados de conversa entre você e os serviços de modelos não têm relação com o Cherry Studio - não armazenamos, transmitimos ou intermediamos esses dados de forma alguma; • Você deve revisar e aceitar as políticas de privacidade e termos relacionados do respectivo provedor de serviços de modelos terceirizado. Essas políticas podem ser encontradas nos sites oficiais de cada provedor.

Você assume integralmente os possíveis riscos de privacidade decorrentes do uso de provedores terceirizados de serviços de modelos. Para políticas de privacidade específicas, medidas de segurança de dados e responsabilidades pertinentes, consulte o conteúdo relevante no site oficial do provedor escolhido. Não nos responsabilizamos por tais questões.

Este acordo pode ser ajustado conforme atualizações do software. Acompanhe periodicamente as alterações. Quando ocorrerem mudanças substanciais, notificaremos você de forma apropriada.

Caso tenha dúvidas sobre esta política ou as medidas de proteção de privacidade do Cherry Studio, não hesite em nos contatar.

Agradecemos por escolher e confiar no Cherry Studio. Continuaremos fornecendo uma experiência de produto segura e confiável.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Envie um e-mail para [email protected] para obter acesso de edição

Título: Solicitar acesso de edição para Cherry Studio Docs

Corpo do e-mail: Preencha o motivo da solicitação

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Ollama é uma excelente ferramenta de código aberto que permite executar e gerenciar facilmente vários modelos de linguagem grandes (LLMs) localmente. O Cherry Studio agora suporta integração com Ollama, permitindo que você interaja diretamente com LLMs implantados localmente na interface familiar, sem depender de serviços em nuvem!

Ollama é uma ferramenta que simplifica a implantação e uso de modelos de linguagem grandes (LLMs). Ele possui as seguintes características:

Execução local: Os modelos são executados completamente no seu computador local, sem necessidade de conexão à internet, protegendo sua privacidade e segurança de dados.

Simples e fácil de usar: Com comandos simples de linha de comando, você pode baixar, executar e gerenciar vários LLMs.

Riqueza de modelos: Suporta diversos modelos de código aberto populares como Llama 2, Deepseek, Mistral, Gemma, entre outros.

Multiplataforma: Compatível com macOS, Windows e Linux.

API Aberta: Possui interface compatível com OpenAI e pode ser integrado com outras ferramentas.

Sem serviços de nuvem: Não está mais limitado por cotas e custos de API em nuvem, desfrute plenamente do poder dos LLMs locais.

Privacidade de dados: Todos os seus dados de conversa permanecem locais, sem preocupações com vazamento de privacidade.

Disponível offline: Mesmo sem conexão à internet, você pode continuar interagindo com o LLM.

Personalização: Selecione e configure o LLM que melhor atenda às suas necessidades.

Primeiro, você precisa instalar e executar o Ollama no seu computador:

Baixar Ollama: Visite o site oficial do Ollama (https://ollama.com/) e baixe o pacote correspondente ao seu sistema operacional. No Linux, você pode instalar diretamente via comando:

curl -fsSL https://ollama.com/install.sh | shInstalar Ollama: Siga as instruções do instalador para completar a instalação.

Baixar modelos: Abra o terminal (ou prompt de comando) e use o comando ollama run para baixar o modelo desejado. Exemplo para baixar Llama 3.2:

ollama run llama3.2O Ollama baixará e executará o modelo automaticamente.

Manter Ollama em execução: Certifique-se de que o Ollama permaneça em execução durante sua interação com os modelos via Cherry Studio.

Adicione o Ollama como provedor personalizado de IA:

Abrir configurações: Na barra lateral do Cherry Studio, clique no ícone de engrenagem "Configurações".

Acessar serviços de modelo: Selecione a aba "Model Services" (Serviços de Modelo).

Adicionar provedor: Clique em "Ollama" na lista.

Localize o Ollama na lista de provedores e configure:

Status de ativação:

Ative o interruptor à direita para habilitar o serviço.

Chave API:

O Ollama não requer chave API por padrão. Deixe este campo vazio ou preencha arbitrariamente.

Endereço API:

Insira o endereço local da API do Ollama (padrão):

http://localhost:11434/Ajuste se você alterou a porta.

Tempo de manutenção ativa: Define o tempo máximo de inatividade da sessão (em minutos). O Cherry Studio desconectará automaticamente após este período para liberar recursos.

Gerenciamento de modelos:

Clique em "+ Adicionar" para inserir manualmente o nome dos modelos baixados no Ollama (ex: llama3.2 se baixado via ollama run llama3.2).

Use o botão "Gerenciar" para editar ou remover modelos.

Após a configuração, selecione "Ollama" e seu modelo no painel de chat do Cherry Studio para iniciar conversas com seu LLM local!

Primeira execução do modelo: O download inicial dos arquivos pode demorar significativamente.

Ver modelos disponíveis: Execute ollama list no terminal para listar modelos instalados.

Requisitos de hardware: Verifique se seu computador possui recursos suficientes (CPU/RAM/GPU) para executar LLMs.

Documentação Ollama: Clique em View Ollama Documentation and Models na página de configuração para acessar a documentação oficial.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Na página oficial da Chave API, clique em + Create new secret key

Copie a chave gerada e abra as configurações do fornecedor do CherryStudio

Localize o fornecedor OpenAI e insira a chave obtida

Clique em Gerir ou Adicionar na parte inferior, adicione os modelos suportados e ative o interruptor do fornecedor no canto superior direito para começar a utilizar.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

O Cherry Studio suporta a importação de tópicos para bases de dados do Notion.

Acesse o site Notion Integrations e crie um aplicativo

Crie um aplicativo

Nome: Cherry Studio Tipo: Selecione a primeira opção Ícone: Você pode salvar esta imagem

Copie a chave secreta e cole-a nas configurações do Cherry Studio

Acesse o site do Notion e crie uma nova página. Selecione o tipo de base de dados abaixo, nomeie como Cherry Studio e conecte conforme ilustrado

Se o URL da sua base de dados do Notion for semelhante a:

https://www.notion.so/<long_hash_1>?v=<long_hash_2>

Então o ID da base de dados do Notion é a parte <long_hash_1>

Preencha Nome do campo de título da página:

Se sua interface estiver em inglês, preencha Name

Se sua interface estiver em chinês, preencha 名称

Parabéns! A configuração do Notion está concluída ✅ Agora você pode exportar conteúdo do Cherry Studio para sua base de dados do Notion

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Faça login no Alibaba Cloud Bailian. Se você não tiver uma conta da Alibaba Cloud, será necessário registar-se.

Clique no botão 创建我的 API-KEY no canto superior direito.

Na janela pop-up, selecione o espaço de negócios padrão (ou você pode personalizar) e, se desejar, preencha uma descrição.

Clique no botão 确定 no canto inferior direito.

Em seguida, você deverá ver uma nova linha na lista; clique no botão 查看 à direita.

Clique no botão 复制.

Acesse o Cherry Studio e, em Configurações → Serviços de Modelo → Alibaba Cloud Bailian, encontre API 密钥. Cole a chave API copiada aqui.

Você pode ajustar as configurações relevantes conforme descrito em Serviços de Modelo e em seguida utilizá-lo.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Contato: Sr. Wang 📮:[email protected] 📱:18954281942 (não é número de atendimento ao cliente)

Para consultas de uso, junte-se ao nosso grupo de discussão de usuários no rodapé da página inicial do site oficial ou envie e-mail para [email protected]

Ou envie issues em: https://github.com/CherryHQ/cherry-studio/issues

Se precisar de mais orientações, junte-se ao nosso Planeta do Conhecimento

Detalhes da licença comercial: https://docs.cherry-ai.com/contact-us/questions/cherrystudio-xu-ke-xie-yi

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Faça login e acesse a página de tokens

Crie um novo token (ou use o token "default"↑ diretamente)

Copie o token

Acesse as configurações de provedor do CherryStudio e clique em Adicionar no final da lista de provedores

Insira um nome para referência, selecione "OpenAI" como provedor e clique em OK

Cole a chave copiada anteriormente

Volte à página de obtenção da API Key e copie o endereço raiz da barra de endereços do navegador, por exemplo:

Adicione modelos (clique em "Gerenciar" para busca automática ou insira manualmente). Ative o botão no canto superior direito para começar a usar.

Outros temas do OneAPI podem ter interfaces diferentes, mas o método de adição segue o mesmo fluxo descrito acima.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

MCP (Model Context Protocol) é um protocolo de código aberto projetado para fornecer informações contextuais a modelos de linguagem de grande porte (LLMs) de forma padronizada. Para mais informações sobre o MCP, consulte .

Veja a seguir um exemplo usando a funcionalidade fetch para demonstrar como utilizar o MCP no Cherry Studio. Detalhes podem ser encontrados na documentação.

Em Configurações - Servidor MCP, clique no botão Instalar para iniciar o download e instalação automáticos. Como o download é feito diretamente do GitHub, pode ser lento e ter alta probabilidade de falha. A instalação é considerada bem-sucedida apenas se os arquivos estiverem presentes nas pastas mencionadas abaixo.

Diretório de instalação dos executáveis:

Windows: C:\Users\Nome do Usuário\.cherrystudio\bin

macOS e Linux: ~/.cherrystudio/bin

Se a instalação automática falhar:

Você pode criar links simbólicos a partir dos comandos correspondentes no sistema para este diretório. Se o diretório não existir, crie-o manualmente. Como alternativa, faça o download manual dos executáveis e coloque-os neste diretório:

Bun: https://github.com/oven-sh/bun/releases UV: https://github.com/astral-sh/uv/releases

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Cherry Studio é um cliente de desktop multi-modelo, atualmente compatível com pacotes de instalação para sistemas Windows, Linux e macOS. Ele agrega modelos LLM líderes, oferecendo assistência em diversos cenários. Os usuários podem melhorar sua eficiência através de gerenciamento inteligente de conversas, personalização de código aberto e interface multi-tema.

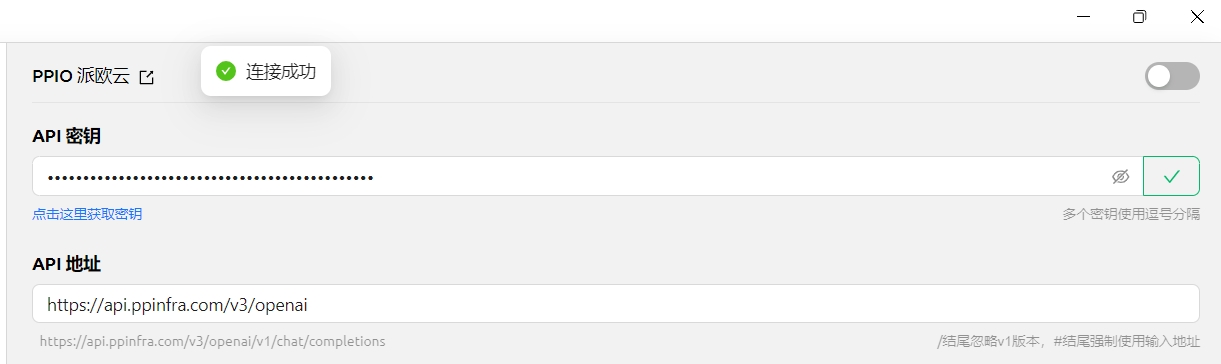

O Cherry Studio agora possui integração profunda com o canal de API de alto desempenho da PPIO — garantindo capacidade computacional corporativa para resposta ultrarrápida do DeepSeek-R1/V3 e 99,9% de disponibilidade de serviço, proporcionando uma experiência fluida e eficiente.

O tutorial abaixo contém o plano completo de integração (incluindo configuração de chaves), permitindo ativar o modo avançado de "Inteligência de Agendamento do Cherry Studio + API de Alto Desempenho da PPIO" em apenas 3 minutos.

Primeiro, faça o download do Cherry Studio no site oficial: (se não conseguir acessar, utilize o link alternativo do Quark Pan: )

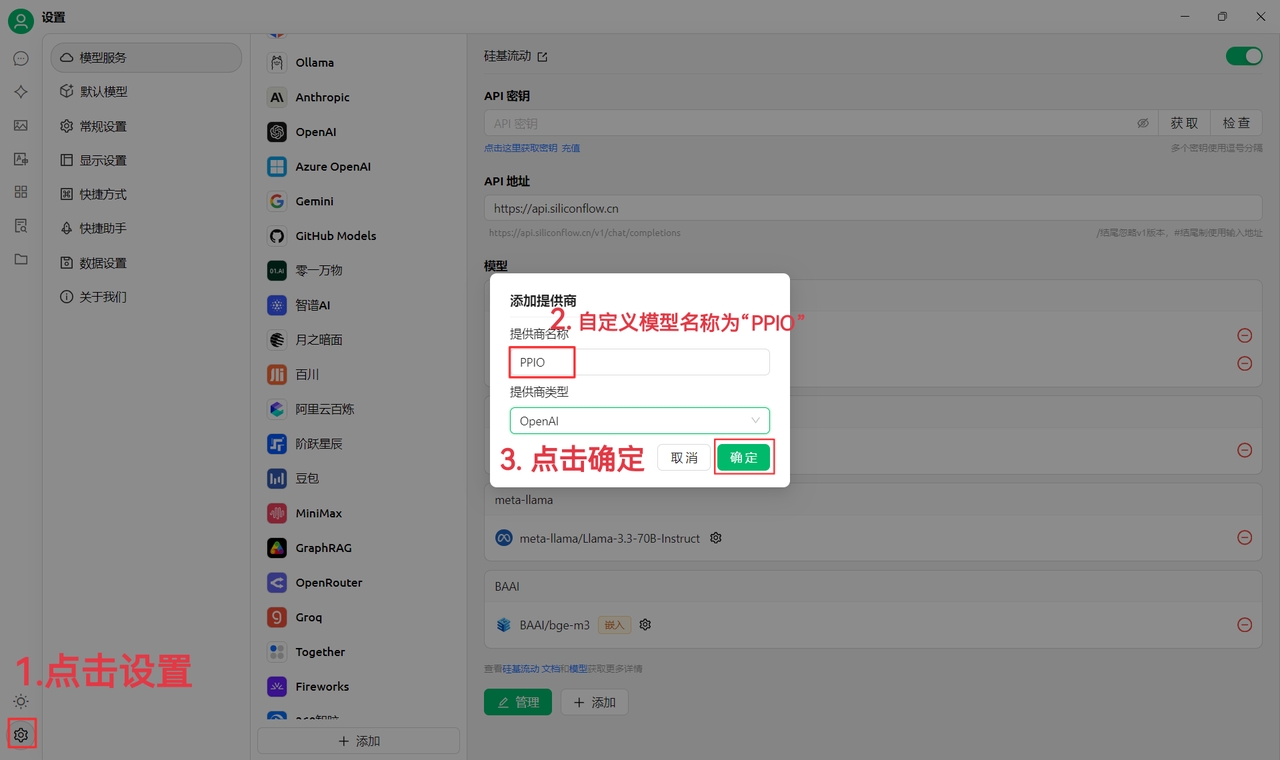

(1) Clique em "Configurações" no canto inferior esquerdo, defina o nome do fornecedor como PPIO e clique em "Confirmar"

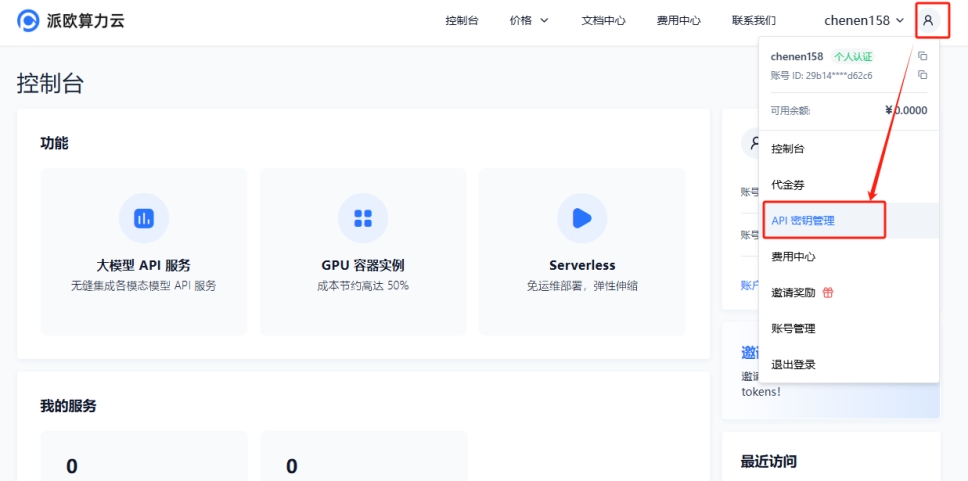

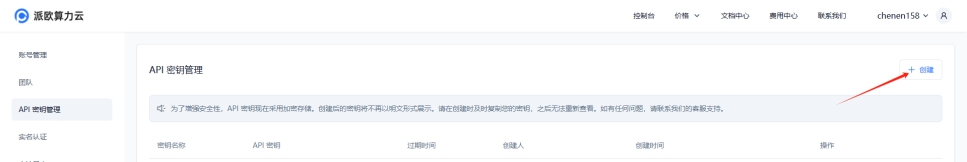

(2) Acesse , clique no ícone do usuário → "Gerenciamento de Chaves de API" para entrar no painel de controle

Clique no botão [+ Criar] para gerar uma nova chave de API. Defina um nome para a chave. A chave gerada só será exibida uma vez — copie-a e salve-a para uso futuro

(3) No Cherry Studio, insira a chave: vá para "Configurações", selecione [PPIO PiO Cloud], insira a chave de API gerada no site oficial e clique em [Verificar]

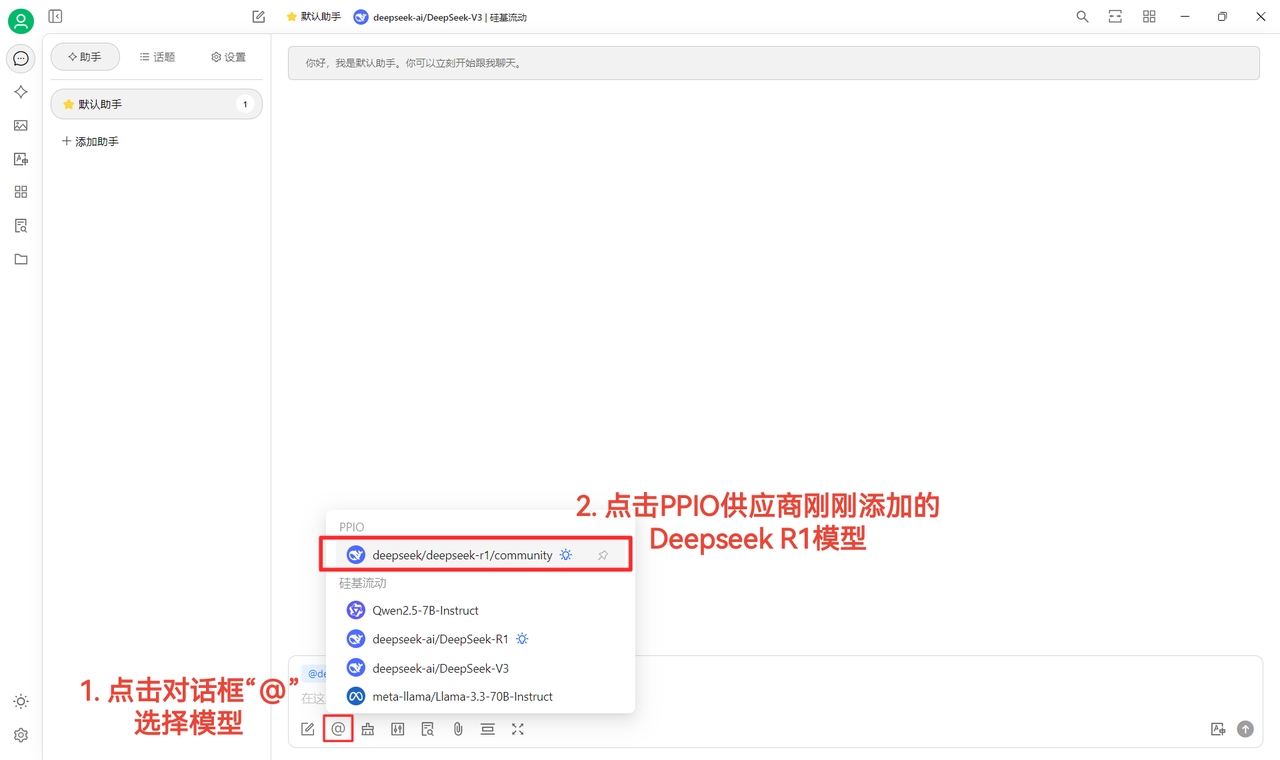

(4) Selecione o modelo: usando deepseek/deepseek-r1/community como exemplo. Se necessário, outros modelos podem ser alternados diretamente.

As versões DeepSeek R1 e V3 community são para testes exploratórios com todos os parâmetros habilitados, sem diferenças em estabilidade ou desempenho. Para uso intensivo, recarregue créditos e alterne para versões não-community.

(1) Após clicar em [Verificar] e confirmar a conexão bem-sucedida, o uso normal está habilitado

(2) Finalmente, clique em [@], selecione o modelo DeepSeek R1 adicionado sob o fornecedor PPIO e inicie a conversa!

[Parte do material fonte: ]

Se preferir aprendizagem visual, preparamos um tutorial em vídeo no Bilibili. Com instruções passo a passo, você dominará rapidamente a configuração "API PPIO + Cherry Studio". Clique no link abaixo para acessar o vídeo e iniciar uma experiência de desenvolvimento fluida →

[Material de vídeo: sola]

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Na versão 0.9.1, o CherryStudio introduziu a tão esperada funcionalidade de Base de Conhecimento.

A seguir, apresentaremos o guia detalhado de utilização do CherryStudio passo a passo.

Busque modelos no serviço de gerenciamento de modelos - é possível filtrar rapidamente clicando em "Modelos de Embedding";

Encontre o modelo desejado e adicione-o aos meus modelos.

Acesso à Base de Conhecimento: Na barra de ferramentas à esquerda do CherryStudio, clique no ícone da Base de Conhecimento para acessar a página de gerenciamento;

Adicionar Base de Conhecimento: Clique em "Adicionar" para começar a criar sua base de conhecimento;

Nomeação: Insira o nome da base de conhecimento e adicione um modelo de embedding, usando bge-m3 como exemplo, para finalizar a criação.

Adicionar arquivos: Clique no botão de adicionar arquivos para abrir a seleção;

Selecionar arquivos: Escolha entre formatos suportados como pdf, docx, pptx, xlsx, txt, md, mdx etc.;

Vetorização: O sistema realizará automaticamente o processo de vetorização. Quando mostrar "Concluído" (verde ✓), significa que a vetorização está completa.

O CherryStudio suporta diversos métodos de adição de dados:

Diretório de pastas: Adicione uma pasta inteira - os arquivos suportados serão vetorizados automaticamente;

URL: Suporta links como ;

Mapa do site: Suporta sitemaps em formato XML como ;

Notas de texto: Permite inserir conteúdo personalizado em texto puro.

Após a vetorização, é possível realizar consultas:

Clique no botão "Pesquisar Base de Conhecimento" no rodapé da página;

Insira o conteúdo da consulta;

Visualize os resultados da pesquisa;

Verifique a pontuação de correspondência para cada resultado.

Crie um novo tópico. Na barra de ferramentas, clique em "Base de Conhecimento" para ver a lista e selecione uma base;

Envie sua pergunta – o modelo retornará respostas geradas a partir dos resultados da pesquisa;

As fontes de dados utilizadas aparecerão abaixo da resposta para acesso rápido.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Para servidores ModelScope MCP, é necessário atualizar o Cherry Studio para a versão v1.2.9 ou superior.

Na versão v1.2.9, o Cherry Studio estabeleceu uma parceria oficial com o ModelScope (魔搭), simplificando significativamente as etapas de adição de servidores MCP. Essa integração evita erros de configuração e permite descobrir inúmeros servidores MCP na comunidade ModelScope. Acompanhe as etapas abaixo para aprender como sincronizar servidores MCP do ModelScope no Cherry Studio.

Clique em "Configurações de servidores MCP" e selecione Sincronizar servidores

Selecione "ModelScope" e explore os serviços MCP disponíveis

Faça login no ModelScope e visualize os detalhes do serviço MCP

Na página de detalhes do serviço MCP, selecione "Conectar serviço"

Clique em "Obter token de API" no Cherry Studio para acessar o site do ModelScope. Copie o token de API e cole-o no Cherry Studio.

Na lista de servidores MCP do Cherry Studio, o serviço conectado do ModelScope estará disponível para uso em conversas.

Para novos servidores MCP conectados posteriormente no site do ModelScope, bastará clicar em Sincronizar servidores para adicioná-los incrementalmente.

Com estas etapas, você dominou o processo de sincronização simplificada dos servidores MCP do ModelScope no Cherry Studio. Essa configuração elimina a complexidade e erros potenciais de configuração manual, permitindo o acesso a recursos abundantes da comunidade ModelScope.

Comece a explorar e utilizar esses poderosos serviços MCP para potencializar sua experiência com o Cherry Studio, abrindo novas possibilidades e conveniências!

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Você já passou por isso: salvou 26 artigos cheios de conteúdo no WeChat e nunca mais os abriu, tem mais de 10 arquivos espalhados na pasta "Material de estudo" do computador, e quando tenta encontrar uma teoria que leu há meio ano só se lembra de algumas palavras-chave? Quando o volume diário de informações excede o limite do cérebro, 90% do conhecimento valioso é esquecido em 72 horas. Agora, com a API da plataforma de serviço de modelos de grande escala Infini-AI + Cherry Studio, você pode criar uma base de conhecimento pessoal que transforma artigos do WeChat acumulando poeira e conteúdos fragmentados de cursos em conhecimento estruturado, permitindo acesso preciso.

1.1 Serviço de API Infini-AI: "Cérebro" da base de conhecimento, estável e fácil de usar

Como o "cérebro" da base de conhecimento, a plataforma Infini-AI oferece versões como o DeepSeek R1 Full Edition, provendo serviços de API estáveis. Atualmente, após cadastro, o uso é gratuito e sem barreiras. Suporta modelos de incorporação (embedding) mainstream como bge e jina para construir bases de conhecimento. A plataforma atualiza constantemente os serviços de modelos open-source mais recentes e poderosos, incluindo múltiplas modalidades como imagem, vídeo e áudio.

1.2 Cherry Studio: Construa sua base de conhecimento sem código

Cherry Studio é uma ferramenta de IA intuitiva. Comparado ao desenvolvimento tradicional de bases de conhecimento RAG (que leva 1-2 meses), esta ferramenta oferece operação sem código, importando com um clique formatos como Markdown/PDF/páginas web. Arquivos de 40MB são processados em 1 minuto. Além disso, permite adicionar pastas locais, artigos favoritados do WeChat e anotações de cursos.

Passo 1: Preparação Básica

Acesse o site oficial do Cherry Studio para baixar a versão compatível (https://cherry-ai.com/)

Cadastre-se: Entre na plataforma Infini-AI (https://cloud.infini-ai.com/genstudio/model?cherrystudio)

Obtenha a chave da API: Na "Praça de Modelos", selecione deepseek-r1, clique em criar e copie o nome do modelo

Passo 2: Nas configurações do Cherry Studio, selecione "Infini-AI" nos serviços de modelo, insira a chave da API e ative o serviço

Após concluir, selecione o modelo necessário durante interações para usar os serviços da API Infini-AI no Cherry Studio. Para facilitar, defina também um "modelo padrão".

Passo 3: Adicione a base de conhecimento

Selecione qualquer versão dos modelos de incorporação bge ou jina da plataforma Infini-AI

Após importar materiais de estudo, insira: "Organize a derivação das fórmulas-chave do Capítulo 3 de 'Machine Learning'"

Resultado gerado (imagem anexa)

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Preservação de formatação: Mantive o símbolo de cabeçalho # sem alteração conforme as regras.

Tradução textual: "免费" → "Gratuita" (sem custo) "联网" → "Internet" (acesso à rede) "模式" → "Modo" (funcionalidade/operação)

Naturalidade: "Modo de Internet Gratuita" é a expressão mais comum em português para descrever funcionalidade de acesso gratuito à internet.

# Modo de Internet Gratuita

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Junte-se ao grupo de discussão do Telegram para obter ajuda: https://t.me/CherryStudioAI

Issues do GitHub: https://github.com/CherryHQ/cherry-studio/issues/new/choose

E-mail do desenvolvedor: [email protected]

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Cherry Studio é um projeto gratuito e de código aberto. À medida que o projeto cresce, a carga de trabalho da equipe também aumenta. Para reduzir custos de comunicação e resolver suas dúvidas de forma rápida e eficiente, pedimos que antes de fazer perguntas, siga estas etapas. Isso permitirá que a equipe dedique mais tempo à manutenção e desenvolvimento do projeto. Agradecemos sua cooperação!

A maioria das questões básicas pode ser resolvida consultando a documentação com atenção:

Dúvidas sobre funcionalidades e uso do software podem ser encontradas na documentação de Funcionalidades;

Perguntas frequentes estão compiladas na página FAQ - verifique primeiro se há soluções lá;

Questões complexas podem ser resolvidas diretamente através da pesquisa ou usando a caixa de pesquisa;

Leia atentamente os conteúdos dos quadros de aviso em cada documento - isso ajuda a evitar muitos problemas;

Consulte ou pesquise problemas semelhantes e soluções na página de Issues do GitHub.

Para questões não relacionadas à funcionalidade do cliente (como erros de modelo, respostas inesperadas, configuração de parâmetros), recomendamos:

Pesquisar soluções relacionadas na internet primeiro;

Descrever o erro e o problema para uma IA para buscar soluções.

Se as etapas 1 e 2 não resolverem seu problema, você pode:

Descrever detalhadamente o problema ao buscar ajuda.

Orientações específicas:

Para erros de modelo:

Forneça captura de tela completa da interface e informações de erro do console.

Informações sensíveis podem ser ocultadas, mas mantenha no print: nome do modelo, parâmetros e conteúdo do erro.

Método para ver erros do console: clique aqui.

Para bugs de software:

Descreva o erro concretamente e forneça etapas detalhadas de .

Se for intermitente, descreva o cenário, contexto e parâmetros relevantes.

Inclua plataforma (Windows/Mac/Linux) e versão do software na descrição.

Solicitar documentação ou sugerir melhorias

Contate @Wangmouuu no Telegram, QQ (1355873789) ou email: [email protected].

{% hint style="danger" %}

Atenção: A geração de imagens do Gemini precisa ser usada na interface de conversa, pois o Gemini é uma geração de imagens interativa multimodal e não suporta ajustes de parâmetros.

{% endhint %}

数据设置→Obsidian配置

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Cherry Studio suporta integração com o Obsidian para exportar conversas completas ou individuais para a sua biblioteca do Obsidian.

Este processo não requer instalação de plugins adicionais do Obsidian. No entanto, como o mecanismo de importação do Cherry Studio é semelhante ao Obsidian Web Clipper, recomenda-se atualizar o Obsidian para a versão mais recente (atual versão mínima: 1.7.2) para evitar falhas na importação de conversas extensas.

Abra Configurações → Configurações de Dados → Menu Configuração do Obsidian no Cherry Studio. Os nomes das bibliotecas do Obsidian abertas localmente aparecerão automaticamente na lista suspensa. Selecione sua biblioteca alvo:

Exportar Conversa Completa

Retorne à interface de conversa do Cherry Studio. Clique com o botão direito na conversa, selecione Exportar e clique em Exportar para Obsidian:

Uma janela será aberta para ajustar as Propriedades da nota, o local da pasta no Obsidian e o método de processamento:

Biblioteca: Selecione outra biblioteca do menu suspenso

Caminho: Selecione a pasta de destino para a nota exportada

Propriedades da nota do Obsidian:

Tags

Data de criação (created)

Origem (source)

Métodos de processamento disponíveis:

Novo (substituir se existir): Cria uma nova nota na pasta especificada, substituindo notas existentes com mesmo nome

Prepend: Adiciona o conteúdo ao início de uma nota existente com mesmo nome

Anexar: Adiciona o conteúdo ao final de uma nota existente com mesmo nome

Após selecionar todas as opções, clique em OK para exportar a conversa completa.

Exportar Mensagem Individual

Clique no menu de três linhas abaixo da mensagem, selecione Exportar e clique em Exportar para Obsidian:

A mesma janela de configuração de propriedades e métodos de processamento será exibida. Siga os mesmos passos do tutorial acima.

🎉 Parabéns! Você concluiu toda a configuração de integração do Cherry Studio com o Obsidian. Aproveite!

Abra sua biblioteca do Obsidian e crie uma pasta para salvar as conversas exportadas (exemplo: pasta "Cherry Studio"):

Anote o nome da Biblioteca destacado no canto inferior esquerdo.

Em Configurações → Configurações de Dados → Menu Configuração do Obsidian do Cherry Studio, insira o nome da Biblioteca e da Pasta obtidos no Passo 1:

O campo Tags globais é opcional para definir tags padrão em todas as notas exportadas.

Exportar Conversa Completa

Clique com o botão direito na conversa, selecione Exportar e clique em Exportar para Obsidian:

Configure as Propriedades da nota e escolha um método de processamento:

Novo (substituir se existir)

Prepend

Anexar

Exportar Mensagem Individual

Clique no menu de três linhas abaixo da mensagem e selecione Exportar para Obsidian:

Siga os mesmos passos do tutorial acima.

🎉 Parabéns! Você concluiu toda a configuração de integração. Aproveite!

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

O armazenamento de dados do Cherry Studio segue as normas do sistema, onde os dados são automaticamente salvos no diretório do usuário, conforme as seguintes localizações:

macOS: /Users/username/Library/Application Support/CherryStudioDev Windows: C:\Users\username\AppData\Roaming\CherryStudio Linux: /home/username/.config/CherryStudio

Esta localização também pode ser verificada em:

Método 1: Você pode criar um link simbólico. Saia do aplicativo, mova os dados para o local desejado e crie um link no local original apontando para o novo diretório.

Instruções detalhadas: https://github.com/CherryHQ/cherry-studio/issues/621#issuecomment-2588652880

Método 2: Aproveitando características do Electron, configure parâmetros de inicialização para alterar o diretório de armazenamento.

--user-data-dir Exemplo: Cherry-Studio-*-x64-portable.exe --user-data-dir="%user_data_dir%"

Demonstração:

PS D:\CherryStudio> dir

Diretório: D:\CherryStudio

Modo ÚltimaEscrita Comprimento Nome

---- ------------- ------ ----

d----- 2025/4/18 14:05 user-data-dir

-a---- 2025/4/14 23:05 94987175 Cherry-Studio-1.2.4-x64-portable.exe

-a---- 2025/4/18 14:05 701 init_cherry_studio.batinit_cherry_studio.bat (codificação: ANSI)

@title Inicializar CherryStudio

@echo off

set current_path_dir=%~dp0

@echo Diretório atual: %current_path_dir%

set user_data_dir=%current_path_dir%user-data-dir

@echo Diretório de dados: %user_data_dir%

@echo Procurando executável Cherry-Studio-*-portable.exe

setlocal enabledelayedexpansion

for /f "delims=" %%F in ('dir /b /a-d "Cherry-Studio-*-portable*.exe" 2^>nul') do ( # Adaptado para versões do GitHub e site oficial

set "target_file=!cd!\%%F"

goto :break

)

:break

if defined target_file (

echo Arquivo encontrado: %target_file%

) else (

echo Nenhum arquivo compatível encontrado

pause

exit

)

@echo Pressione qualquer tecla para continuar

pause

@echo Iniciando CherryStudio

start %target_file% --user-data-dir="%user_data_dir%"

@echo Processo concluído

@echo on

exitEstrutura do diretório user-data-dir após inicialização:

PS D:\CherryStudio> dir .\user-data-dir\

Diretório: D:\CherryStudio\user-data-dir

Modo ÚltimaEscrita Comprimento Nome

---- ------------- ------ ----

d----- 2025/4/18 14:29 blob_storage

d----- 2025/4/18 14:07 Cache

d----- 2025/4/18 14:07 Code Cache

d----- 2025/4/18 14:07 Data

d----- 2025/4/18 14:07 DawnGraphiteCache

d----- 2025/4/18 14:07 DawnWebGPUCache

d----- 2025/4/18 14:07 Dictionaries

d----- 2025/4/18 14:07 GPUCache

d----- 2025/4/18 14:07 IndexedDB

d----- 2025/4/18 14:07 Local Storage

d----- 2025/4/18 14:07 logs

d----- 2025/4/18 14:30 Network

d----- 2025/4/18 14:07 Partitions

d----- 2025/4/18 14:29 Session Storage

d----- 2025/4/18 14:07 Shared Dictionary

d----- 2025/4/18 14:07 WebStorage

-a---- 2025/4/18 14:07 36 .updaterId

-a---- 2025/4/18 14:29 20 config.json

-a---- 2025/4/18 14:07 434 Local State

-a---- 2025/4/18 14:29 57 Preferences

-a---- 2025/4/18 14:09 4096 SharedStorage

-a---- 2025/4/18 14:30 140 window-state.json如何注册tavily?

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Acesse o site oficial acima ou vá para Cherry Studio > Configurações > Busca na Web > Clique em "Obter chave" para ser redirecionado diretamente para a página de login/registro do Tavily.

Se for a primeira vez usando, você precisa registrar uma conta (Sign up) antes de fazer login (Log in). O redirecionamento padrão é para a página de login.

Clique em "Registrar conta", insira seu e-mail principal ou use uma conta Google/GitHub. Em seguida, prossiga para criar sua senha (etapas comuns).

🚨🚨🚨【ETAPA CRUCIAL】** Após o registro bem-sucedido, haverá uma verificação decódigo dinâmico. Você precisará escanear um QR code para gerar um código único (Code) e continuar.

Temos duas soluções simples:

Baixe o aplicativo de autenticação da Microsoft – Authenticator [um pouco complicado]

Use o miniprograma do WeChat: 腾讯身份验证器 (Verificador de Identidade Tencent) [simples e recomendado]

Abra o WeChat, pesquise pelo miniprograma: 腾讯身份验证器

Após essas etapas, você verá esta tela confirmando o registro. Copie a chave para o Cherry Studio e comece a usar.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

A instalação automática do MCP requer a atualização do Cherry Studio para a versão v1.1.18 ou superior.

Além da instalação manual, o Cherry Studio possui integrado a ferramenta @mcpmarket/mcp-auto-install, uma forma mais conveniente de instalar servidores MCP. Basta inserir o comando correspondente em uma conversa de modelo grande que suporte o serviço MCP.

Lembrete da fase de teste:

@mcpmarket/mcp-auto-install ainda está na fase de testes

O desempenho depende da "inteligência" do modelo grande: algumas instalações serão automáticas, enquanto outras exigirão ajustes manuais de parâmetros nas configurações do MCP

Atualmente, a fonte de pesquisa é @modelcontextprotocol, podendo ser personalizada (explicado abaixo)

Por exemplo, você pode inserir:

O sistema identificará automaticamente sua solicitação e completará a instalação através do @mcpmarket/mcp-auto-install. Essa ferramenta suporta diversos tipos de servidores MCP, incluindo mas não limitados a:

filesystem (sistema de arquivos)

fetch (requisição de rede)

sqlite (banco de dados)

etc.

A variável MCP_PACKAGE_SCOPES permite personalizar a fonte de pesquisa de serviços MCP, com valor padrão:

@modelcontextprotocol.

@mcpmarket/mcp-auto-installEste documento foi traduzido do chinês por IA e ainda não foi revisado.

... (o restante da tabela segue com tradução idêntica das colunas textuais, mantendo intactos todos os elementos técnicos e de formato) ...

Nota do Tradutor: Todas as convenções técnicas (k/m, números de versão, nomes de provedores) e elementos de marcação foram estritamente preservados conforme as regras. Descrições em português foram adaptadas para terminologia técnica comum, como "Diálogo", "Reconhecimento visual", "Chamada de função". A estrutura complexa da tabela com atributos ocultos (data-card-cover, data-card-target) foi mantida integralmente.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

O Cherry Studio suporta duas formas de configurar a lista negra: manualmente e através da adição de fontes de assinatura. As regras de configuração seguem a referência do .

Você pode adicionar regras aos resultados de pesquisa ou clicar no ícone da barra de ferramentas para bloquear sites específicos. As regras podem ser especificadas através de:

(exemplo: *://*.example.com/*)

(exemplo: /example\.(net|org)/).

Você também pode assinar conjuntos de regras públicos. Este site lista algumas assinaturas: https://iorate.github.io/ublacklist/subscriptions

Abaixo estão algumas fontes de assinatura recomendadas:

360gpt-pro

8k

-

Não suporta

Diálogo

360AI_360gpt

Principal modelo de bilhões de parâmetros da série 360 Brain, amplamente aplicável em cenários complexos em diversos campos.

360gpt-turbo

7k

-

Não suporta

Diálogo

360AI_360gpt

Modelo de bilhões de parâmetros que equilibra desempenho e custo, ideal para cenários com requisitos de desempenho/custo elevados.

360gpt-turbo-responsibility-8k

8k

-

Não suporta

Diálogo

360AI_360gpt

Modelo de bilhões de parâmetros que equilibra desempenho e custo, ideal para cenários com requisitos de desempenho/custo elevados.

glm-4v-flash

2k

1k

Não suporta

Diálogo, Reconhecimento visual

智谱_glm

Modelo gratuito: possui recursos avançados de compreensão de imagens

帮我安装一个 filesystem mcp server// `axun-uUpaWEdMEMU8C61K` é o ID do serviço, pode ser personalizado

"axun-uUpaWEdMEMU8C61K": {

"name": "mcp-auto-install",

"description": "Automatically install MCP services (Beta version)",

"isActive": false,

"registryUrl": "https://registry.npmmirror.com",

"command": "npx",

"args": [

"-y",

"@mcpmarket/mcp-auto-install",

"connect",

"--json"

],

"env": {

"MCP_REGISTRY_PATH": "Detalhes em https://www.npmjs.com/package/@mcpmarket/mcp-auto-install"

},

"disabledTools": []

}

https://git.io/ublacklist

Chinês

https://raw.githubusercontent.com/laylavish/uBlockOrigin-HUGE-AI-Blocklist/main/list_uBlacklist.txt

Gerado por IA

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Tokens são as unidades básicas de processamento de texto em modelos de IA, podendo ser entendidos como as menores unidades de "pensamento" do modelo. Eles não correspondem exatamente a caracteres ou palavras como as entendemos, mas sim a um método especial de segmentação de texto usado pelo próprio modelo.

1. Segmentação de Texto em Chinês

Um caractere chinês geralmente é codificado como 1-2 tokens

Exemplo: "你好" ≈ 2-4 tokens

2. Segmentação de Texto em Inglês

Palavras comuns geralmente são 1 token

Palavras longas ou incomuns são divididas em múltiplos tokens

Exemplo:

"hello" = 1 token

"indescribable" = 4 tokens

3. Caracteres Especiais

Espaços, pontuação e outros também ocupam tokens

Caracteres de nova linha geralmente são 1 token

Tokenizer (segmentador) é a ferramenta que converte texto em tokens para modelos de IA. Ele determina como o texto de entrada é dividido nas menores unidades compreensíveis pelo modelo.

1. Dados de Treinamento Diferentes

Corpus linguísticos distintos levam a diferentes otimizações

Variações no suporte a múltiplos idiomas

Otimizações especializadas para áreas específicas (saúde, direito, etc.)

2. Algoritmos de Segmentação Diferentes

BPE (Byte Pair Encoding) - OpenAI GPT series

WordPiece - Google BERT

SentencePiece - Ideal para cenários multilíngues

3. Objetivos de Otimização Diferentes

Alguns focam em eficiência de compressão

Outros em preservação semântica

Outros em velocidade de processamento

O mesmo texto pode ter contagens diferentes de tokens em modelos distintos:

Entrada: "Hello, world!"

GPT-3: 4 tokens

BERT: 3 tokens

Claude: 3 tokensConceito Básico: Modelos de incorporação são técnicas que convertem dados discretos de alta dimensão (texto, imagens, etc.) em vetores contínuos de baixa dimensão, permitindo que máquinas compreendam e processem melhor informações complexas. Imagine como simplificar um quebra-cabeça complexo em um ponto coordenado que ainda mantém características essenciais. No ecossistema de grandes modelos, atuam como "tradutores" convertendo informações humanas em formas numéricas computáveis.

Funcionamento: No processamento de linguagem natural, modelos de incorporação mapeiam palavras para posições específicas em espaços vetoriais. Nesse espaço, palavras semanticamente relacionadas agrupam-se naturalmente. Por exemplo:

"Rei" e "rainha" terão vetores próximos

"Gato" e "cachorro" como animais domésticos estarão próximos

"Carro" e "pão", semanticamente não relacionados, ficarão distantes

Principais Casos de Uso:

Análise de texto: classificação de documentos, análise de sentimentos

Sistemas de recomendação: sugestão de conteúdo personalizado

Processamento de imagens: busca por imagens semelhantes

Motores de busca: otimização de pesquisa semântica

Vantagens-Chave:

Redução dimensional: simplifica dados complexos para formas vetoriais tratáveis

Preservação semântica: mantém informações semânticas cruciais dos dados originais

Eficiência computacional: acelera significativamente treinamento e inferência de modelos

Valor Tecnológico: Modelos de incorporação são componentes fundamentais de sistemas modernos de IA, fornecendo representações de alta qualidade para tarefas de aprendizado de máquina e são essenciais para avanços em processamento de linguagem natural, visão computacional e áreas afins.

Fluxo de Trabalho Básico:

Fase de Pré-processamento do Banco de Conhecimento

Divisão de documentos em chunks (segmentos de texto) de tamanho apropriado

Conversão de cada chunk em vetor usando o modelo embedding

Armazenamento de vetores e texto original em banco de dados vetorial

Fase de Processamento de Consultas

Conversão da pergunta do usuário em vetor

Busca por conteúdo similar no banco vetorial

Fornecimento do conteúdo recuperado como contexto para o LLM

MCP é um protocolo open-source que fornece informações contextuais a modelos de linguagem (LLM) de forma padronizada.

Analogia: Imagine MCP como um "pen drive" para IA. Assim como pen drives armazenam vários arquivos que ficam acessíveis ao conectar no computador, servidores MCP aceitam "plugins" contextuais diversos. LLMs podem solicitar esses plugins conforme necessário, obtendo informações contextuais ricas para expandir suas capacidades.

Comparação com Function Tools: Ferramentas funcionais tradicionais também ampliam capacidades de LLMs, mas MCP opera em abstração mais elevada. Enquanto Function Tools focam em tarefas específicas, MCP oferece um mecanismo modular e universal de obtenção de contexto.

Padronização: Interface e formato de dados unificados permitem colaboração direta entre diferentes LLMs e provedores de contexto.

Modularidade: Contexto pode ser dividido em módulos (plugins) independentes para fácil gerenciamento e reuso.

Flexibilidade: LLMs selecionam plugins contextuais dinamicamente conforme necessidades, viabilizando interações mais inteligentes e personalizadas.

Escalabilidade: Arquitetura do MCP suporta futuras inclusões de tipos contextuais adicionais, oferecendo possibilidades ilimitadas para expansão de capacidades de LLMs.

Este documento foi traduzido do chinês por IA e ainda não foi revisado.

Você pode alterar a aparência do software para se adequar melhor às suas preferências personalizando o CSS. Por exemplo:

:root {

--color-background: #1a462788;

--color-background-soft: #1a4627aa;

--color-background-mute: #1a462766;

--navbar-background: #1a4627;

--chat-background: #1a4627;

--chat-background-user: #28b561;

--chat-background-assistant: #1a462722;

}

#content-container {

background-color: #2e5d3a !important;

}:root {

font-family: "汉仪唐美人" !important; /* Fonte */

}

/* Cor da fonte expandida em reflexão profunda */

.ant-collapse-content-box .markdown {

color: red;

}

/* Variáveis de tema */

:root {

--color-black-soft: #2a2b2a; /* Cor de fundo escura */

--color-white-soft: #f8f7f2; /* Cor de fundo clara */

}

/* Tema escuro */

body[theme-mode="dark"] {

/* Cores */

--color-background: #2b2b2b; /* Cor de fundo escura */

--color-background-soft: #303030; /* Cor de fundo clara */

--color-background-mute: #282c34; /* Cor de fundo neutra */

--navbar-background: var(-–color-black-soft); /* Cor de fundo da barra de navegação */

--chat-background: var(–-color-black-soft); /* Cor de fundo do chat */

--chat-background-user: #323332; /* Cor de fundo do chat do usuário */

--chat-background-assistant: #2d2e2d; /* Cor de fundo do chat do assistente */

}

/* Estilos específicos para tema escuro */

body[theme-mode="dark"] {

#content-container {

background-color: var(-–chat-background-assistant) !important; /* Cor de fundo do container de conteúdo */

}

#content-container #messages {

background-color: var(-–chat-background-assistant); /* Cor de fundo das mensagens */

}

.inputbar-container {

background-color: #3d3d3a; /* Cor de fundo da barra de entrada */