Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Lorsqu'aucun modèle d'assistant par défaut n'est défini pour un assistant, le modèle configuré ici sera sélectionné par défaut dans ses nouvelles conversations.

L'optimisation des mots d'incitation (prompts) et l'assistant de sélection de texte utilisent également le modèle défini ici.

Après chaque conversation, un modèle est appelé pour générer un nom de sujet à la conversation. Le modèle configuré ici est celui utilisé pour cette dénomination.

Les fonctions de traduction dans les champs de saisie de conversation, de peinture IA, ainsi que le modèle de traduction dans l'interface de traduction utilisent tous le modèle configuré ici.

Modèle utilisé pour les fonctions d'assistant rapide. Voir détails dans Assistant rapide

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Cette interface permet d'effectuer des sauvegardes et restaurations locales ou cloud, de consulter le répertoire des données locales et de vider le cache, d'exporter les paramètres et de configurer des connexions tierces.

Actuellement, la sauvegarde prend en charge trois méthodes : sauvegarde locale, sauvegarde WebDAV et sauvegarde dans un stockage compatible S3 (stockage d'objets). Pour des explications détaillées et des tutoriels, veuillez consulter les documents suivants :

Les paramètres d'exportation permettent de configurer les options d'exportation affichées dans le menu. Vous pouvez également définir le chemin par défaut pour l'export Markdown, le style d'affichage, etc.

Cette section configure la connexion entre Cherry Studio et des applications tierces pour exporter rapidement le contenu des conversations vers vos outils de gestion des connaissances. Actuellement pris en charge : Notion, Obsidian, SiYuan Note, YuQue et Joplin. Tutoriels de configuration :

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Pour l'utilisation de la base de connaissances, consultez le tutoriel avancé : Tutoriel sur la base de connaissances.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

La page Agents est une place d'assistants où vous pouvez sélectionner ou rechercher le modèle prédéfini souhaité. En cliquant sur une carte, vous ajouterez l'assistant à la liste des assistants dans la page de conversation.

Vous pouvez également modifier et créer vos propres assistants sur cette page.

Cliquez sur Mon espace, puis sur Créer un agent pour commencer à créer votre propre assistant.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Sur cette interface, vous pouvez activer (désactiver) et configurer les raccourcis clavier de certaines fonctionnalités. Suivez les instructions spécifiques affichées sur l'interface pour effectuer les réglages.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Dans la page des mini-programmes, vous pouvez utiliser les versions web des applications liées à l'IA des principaux fournisseurs directement dans le client. Actuellement, l'ajout et la suppression personnalisés ne sont pas pris en charge.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Sur cette page, vous pouvez configurer le thème de couleur du logiciel, la mise en page ou personnaliser le CSS pour effectuer des réglages personnalisés.

Vous pouvez définir ici le mode de couleur par défaut de l'interface (mode clair, mode sombre ou suivi du système)

Ces paramètres concernent la mise en page de l'interface de discussion.

Lorsque ce paramètre est activé, cliquer sur le nom de l'assistant basculera automatiquement vers la page de conversation correspondante.

Lorsqu'activé, affiche l'heure de création sous chaque conversation.

Ce paramètre permet d'apporter des modifications personnalisées flexibles à l'interface. Voir les méthodes spécifiques dans le tutoriel avancé : Personnalisation CSS.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

La fonction de peinture prend actuellement en charge les modèles de DMXAPI, TokenFlux, AiHubMix et SiliconFlow. Vous pouvez créer un compte sur SiliconFlow et l'ajouter comme fournisseur de services pour l'utiliser.

Pour toute question sur les paramètres, passez votre souris sur le ? dans la zone correspondante pour voir les explications.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Cette page présente uniquement les fonctionnalités de l'interface. Pour le tutoriel de configuration, veuillez consulter dans les tutoriels de base.

Dans Cherry Studio, un seul fournisseur supporte l'utilisation rotative de plusieurs clés via un cycle séquentiel dans la liste.

Ajoutez plusieurs clés en les séparant par des virgules anglaises. Par exemple :

Vous devez utiliser des virgules anglaises.

Aucun renseignement n'est généralement nécessaire pour les fournisseurs intégrés. Si modification requise, suivez scrupuleusement l'adresse fournie dans la documentation officielle correspondante.

Si le fournisseur indique une adresse au format https://xxx.xxx.com/v1/chat/completions, saisissez uniquement la partie racine (https://xxx.xxx.com).

Cherry Studio ajoutera automatiquement le chemin restant (/v1/chat/completions). Un format incorrect peut entraîner des dysfonctionnements.

Cliquez généralement sur le bouton Gérer en bas à gauche de la page de configuration du fournisseur pour récupérer automatiquement tous ses modèles disponibles, puis ajoutez-les à la liste via le +.

Cliquez sur le bouton de vérification situé après le champ de clé API pour tester la configuration.

Après une configuration réussie, activez impérativement l'interrupteur en haut à droite, sans quoi le fournisseur restera inactif et ses modèles invisibles.

Windows 版本安装教程

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Remarque : Windows 7 ne prend pas en charge l'installation de Cherry Studio.

Cliquez pour télécharger et sélectionner la version appropriée

Si le navigateur indique que le fichier n'est pas approuvé, etc., choisissez simplement "Conserver"

Choisir Conserver→Faire confiance à Cherry-Studio

macOS 版本安装教程

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Tout d'abord, allez sur la page de téléchargement du site officiel et cliquez pour télécharger la version Mac, ou cliquez directement ci-dessous :

Veuillez télécharger la version correspondant à la puce de votre Mac

Une fois le téléchargement terminé, cliquez ici

Faites glisser l'icône pour installer

Dans le Launchpad, cherchez l'icône de Cherry Studio et cliquez dessus. Si l'interface principale de Cherry Studio s'ouvre, l'installation a réussi.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

1.2 Cliquez sur Paramètres en bas à gauche, sélectionnez【SiliconFlow】dans Services de modèles

1.2 Obtenir la clé API SiliconCloud

Connectez-vous à (l'inscription est automatique lors de la première connexion)

Accédez aux pour créer ou copier une clé existante

1.3 Cliquez sur Gérer pour ajouter des modèles

Cliquez sur le bouton "Conversation" dans le menu de gauche

Saisissez du texte dans la zone de saisie pour commencer à discuter

Changez de modèle via le menu déroulant en haut

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Utilisez cette méthode lorsque des paramètres CSS incorrects sont appliqués ou si vous ne pouvez pas accéder à l'interface après avoir défini des CSS.

Ouvrez la console, cliquez sur la fenêtre CherryStudio, puis appuyez sur le raccourci Ctrl+Shift+I (macOS : command+option+I).

Dans la console qui s'ouvre, cliquez sur Console

Saisissez manuellement document.getElementById('user-defined-custom-css').remove() – le copier-coller ne fonctionnera probablement pas.

Appuyez sur Entrée pour confirmer et effacer les paramètres CSS, puis retournez dans les paramètres d'affichage de CherryStudio pour supprimer le code CSS problématique.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

MCP (Model Context Protocol) est un protocole open-source conçu pour fournir des informations contextuelles aux grands modèles de langage (LLM) de manière standardisée. Pour plus d'informations sur MCP, consultez

Voici un exemple avec la fonction fetch démontrant comment utiliser MCP dans Cherry Studio. Les détails complets sont disponibles dans la .

Cherry Studio utilise actuellement uniquement les versions intégrées de et , sans réutiliser les installations existantes de uv et bun sur votre système.

Dans Paramètres → Serveurs MCP, cliquez sur le bouton Installer pour télécharger et installer automatiquement. Le téléchargement direct depuis GitHub peut être lent et échouer fréquemment. L'installation est réussie si les fichiers apparaissent dans les dossiers mentionnés ci-dessous.

Répertoires d'installation des exécutables :

Windows : C:\Users\Nom_utilisateur\.cherrystudio\bin

macOS/Linux : ~/.cherrystudio/bin

En cas d'échec d'installation :

Créez manuellement le répertoire s'il n'existe pas.

Vous pouvez soit :

Créer des liens symboliques vers les commandes système existantes

Télécharger manuellement les exécutables aux liens ci-dessous et les placer dans le répertoire :

Bun :

UV :

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Installation automatique du service MCP (version bêta)

Implémentation de base de mémoire persistante basée sur un graphe de connaissances local. Cela permet au modèle de mémoriser les informations pertinentes de l'utilisateur entre différentes conversations.

Implémentation d'un serveur MCP fournissant des outils pour la résolution dynamique et réflexive de problèmes grâce à un processus de pensée structuré.

Implémentation d'un serveur MCP intégrant l'API de recherche Brave, offrant une double fonctionnalité de recherche web et locale.

Serveur MCP pour récupérer le contenu de pages web via URL.

Serveur Node.js implémentant le protocole de contexte de modèle (MCP) pour les opérations sur le système de fichiers.

MEMORY_FILE_PATH=/path/to/your/file.jsonBRAVE_API_KEY=YOUR_API_KEYMiSans Global

Multilingue Usage commercial autorisé

MiSans Global est un projet de police personnalisée pour langues mondiales, dirigé par Xiaomi et développé conjointement avec Monotype et HanYi Foundries.

Il s'agit d'une vaste famille de polices couvrant plus de 20 systèmes d'écriture et prenant en charge plus de 600 langues.

mcp-server-time

--local-timezone

<votre fuseau horaire standard, par exemple : Asia/Shanghai>

sk-xxxx1,sk-xxxx2,sk-xxxx3,sk-xxxx4

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

La fonction de traduction de Cherry Studio vous offre un service de traduction de texte rapide et précis, prenant en charge les traductions entre plusieurs langues.

L'interface de traduction comprend principalement les éléments suivants :

Zone de sélection de la langue source :

N'importe quelle langue : Cherry Studio détectera automatiquement la langue source et effectuera la traduction.

Zone de sélection de la langue cible :

Menu déroulant : Choisissez la langue dans laquelle vous souhaitez traduire le texte.

Bouton Paramètres :

Cliquez pour accéder aux paramètres des modèles par défaut.

Défilement synchronisé :

Cliquez pour activer/désactiver la synchronisation du défilement (le défilement d'un côté entraîne le défilement de l'autre côté).

Zone de saisie de texte (gauche) :

Saisissez ou collez le texte à traduire.

Zone des résultats de traduction (droite) :

Affiche le texte traduit.

Bouton Copier : Cliquez pour copier le résultat dans le presse-papiers.

Bouton Traduire :

Cliquez pour lancer la traduction.

Historique des traductions (coin supérieur gauche) :

Cliquez pour consulter l'historique des traductions.

Sélectionnez la langue cible :

Dans la zone de sélection de la langue cible, choisissez la langue souhaitée.

Saisissez ou collez le texte :

Entrez ou collez le texte à traduire dans la zone de gauche.

Lancez la traduction :

Cliquez sur le bouton Traduire.

Consultez et copiez les résultats :

Le résultat s'affiche dans la zone de droite.

Cliquez sur le bouton Copier pour transférer le texte dans le presse-papiers.

Q : Que faire si la traduction est inexacte ?

R : Bien que la traduction IA soit puissante, elle n'est pas parfaite. Pour les textes techniques ou contextes complexes, une relecture humaine est recommandée. Vous pouvez aussi essayer différents modèles.

Q : Quelles langues sont prises en charge ?

R : La fonction prend en charge de nombreuses langues principales. Consultez le site officiel ou les instructions dans l'application pour la liste complète.

Q : Peut-on traduire un fichier entier ?

R : L'interface actuelle est conçue pour des textes. Pour les fichiers, accédez à la page de conversation de Cherry Studio pour ajouter des fichiers à traduire.

Q : Que faire en cas de lenteur de traduction ?

R : La vitesse peut être affectée par le réseau, la longueur du texte ou la charge du serveur. Assurez-vous d'avoir une connexion stable et patientez.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Connectez-vous à Alibaba Cloud Bailian. Si vous n'avez pas de compte Alibaba Cloud, vous devrez en créer un.

Cliquez sur le bouton Créer mon API-KEY en haut à droite.

Dans la fenêtre contextuelle, sélectionnez l'espace d'affaires par défaut (ou personnalisez-le si vous le souhaitez). Vous pouvez éventuellement ajouter une description.

Cliquez sur le bouton Confirmer en bas à droite.

Vous devriez alors voir une nouvelle ligne apparaître dans la liste. Cliquez sur le bouton Afficher à droite.

Cliquez sur le bouton Copier.

Rendez-vous dans Cherry Studio. Accédez à Paramètres → Services de modèle → Alibaba Cloud Bailian, trouvez le champ Clé API et collez-y la clé copiée.

Vous pouvez ajuster les paramètres selon les instructions dans Services de modèle, puis commencer à l'utiliser.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Cherry Studio permet d'importer des sujets dans la base de données Notion.

Accédez au site Notion Integrations pour créer une application

Créez une application

Nom : Cherry Studio

Type : Sélectionnez le premier

Icône : Vous pouvez sauvegarder cette image

Copiez la clé secrète et collez-la dans les paramètres de Cherry Studio

Ouvrez le site Notion, créez une nouvelle page, sélectionnez le type base de données en bas, nommez-la Cherry Studio, et connectez comme indiqué

Si l'URL de votre base de données Notion ressemble à ceci :

https://www.notion.so/<long_hash_1>?v=<long_hash_2>

Alors l'ID de la base de données Notion est la partie <long_hash_1>

Remplissez le Nom du champ de titre de la page :

Si votre interface est en anglais : saisissez Name

Si votre interface est en chinois : saisissez 名称

Félicitations, la configuration Notion est terminée ✅ Vous pouvez désormais exporter du contenu Cherry Studio vers votre base de données Notion

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Cherry Studio permet de configurer les listes noires manuellement ou via des sources d'abonnement. Les règles de configuration suivent les références ublacklist.

Vous pouvez ajouter des règles aux résultats de recherche ou cliquer sur l'icône de la barre d'outils pour bloquer des sites spécifiques. Les règles peuvent être définies via :

Modèles de correspondance (ex: *://*.example.com/*)

Expressions régulières (ex: /example\.(net|org)/)

Vous pouvez également souscrire à des ensembles de règles publics. Ce site liste certains abonnements : https://iorate.github.io/ublacklist/subscriptions

Voici quelques sources d'abonnement recommandées :

https://git.io/ublacklist

Chinois

https://raw.githubusercontent.com/laylavish/uBlockOrigin-HUGE-AI-Blocklist/main/list_uBlacklist.txt

Généré par IA

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Pour utiliser GitHub Copilot, vous devez d'abord disposer d'un compte GitHub et souscrire au service GitHub Copilot. L'abonnement gratuit est possible, mais la version gratuite ne prend pas en charge le dernier modèle Claude 3.7. Pour plus de détails, consultez le site officiel de GitHub Copilot.

Cliquez sur « Se connecter à GitHub » pour obtenir le Device Code et copiez-le.

Après avoir obtenu le Device Code, cliquez sur le lien pour ouvrir le navigateur. Connectez-vous à votre compte GitHub, saisissez le Device Code et autorisez l'accès.

Après autorisation réussie, revenez à Cherry Studio et cliquez sur « Connecter GitHub ». Une fois connecté, votre nom d'utilisateur et votre avatar GitHub s'afficheront.

Cliquez sur le bouton « Gérer » ci-dessous pour récupérer automatiquement la liste des modèles actuellement pris en charge.

Les requêtes actuelles utilisent Axios, qui ne prend pas en charge les proxy SOCKS. Utilisez un proxy système ou HTTP, ou ne configurez pas de proxy dans CherryStudio pour utiliser un proxy global. Assurez-vous d'abord que votre connexion réseau est normale pour éviter cet échec.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Avant d'obtenir la clé API Gemini, vous devez disposer d'un projet Google Cloud (si vous en avez déjà un, cette étape peut être ignorée)

Accédez à Google Cloud pour créer un projet, saisissez le nom du projet et cliquez sur "Créer un projet"

Sur la page officielle des Clés API, cliquez sur Clé > Créer une clé API

Copiez la clé générée et ouvrez les Paramètres du fournisseur de CherryStudio

Localisez le fournisseur Gemini, entrez la clé que vous venez d'obtenir

Cliquez sur "Gérer" ou "Ajouter" en bas, ajoutez les modèles pris en charge et activez le commutateur du fournisseur en haut à droite pour commencer à l'utiliser.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Toutes les données ajoutées à la base de connaissances de Cherry Studio sont stockées localement. Lors de l'ajout, une copie du document est placée dans le répertoire de stockage des données de Cherry Studio.

Base de données vectorielle : https://turso.tech/libsql

Lorsqu'un document est ajouté à la base de connaissances de Cherry Studio, il est découpé en plusieurs segments. Ces segments sont ensuite traités par un modèle d'incorporation.

Lors de l'utilisation d'un grand modèle pour des questions-réponses, les segments de texte pertinents pour la question sont recherchés et transmis ensemble au grand modèle de langage pour traitement.

Si vous avez des exigences concernant la confidentialité des données, il est recommandé d'utiliser une base de données d'incorporation locale et un grand modèle de langage local.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Vous vivez peut-être cette situation : 26 articles utiles épinglés sur WeChat jamais relus, plus de 10 fichiers éparpillés dans votre dossier "Ressources d'apprentissage", cherchant désespérément une théorie lue il y a six mois avec seulement quelques mots-clés en tête. Quand le volume quotidien d'information dépasse la capacité de traitement de votre cerveau, 90% des connaissances précieuses sont oubliées en 72 heures. Désormais, avec l'API de la plateforme de grands modèles Infini-AI + Cherry Studio, vous pouvez créer une base de connaissances personnelle transformant articles WeChat oubliés et contenus fragmentés en savoir structuré, accessible avec précision.

1. Service API Infini-AI : le « cerveau réflexif » de votre base, fiable et performant

En tant que « cerveau réflexif » de la base de connaissances, la plateforme Infini-AI propose des versions de modèles comme DeepSeek R1 version complète, offrant un service API stable. Actuellement, l'utilisation est gratuite après inscription, sans conditions. Elle prend en charge les modèles d'embedding populaires (bge, jina) pour construire votre base, tout en intégrant continuellement les derniers modèles open-source puissants, incluant des capacités multimodales (images, vidéos, audio).

2. Cherry Studio : construisez votre base sans code

Cherry Studio est un outil IA intuitif. Alors que le développement traditionnel d'une base RAG nécessite 1 à 2 mois, cet outil offre l'avantage d'une configuration zéro code. Importez en un clic des contenus aux formats Markdown/PDF/web. L'analyse d'un fichier de 40MB prend 1 minute. Ajoutez également des dossiers locaux, des articles sauvegardés dans WeChat ou des notes de cours.

Étape 1 : Préparatifs

Téléchargez Cherry Studio sur le site officiel (https://cherry-ai.com/)

Créez un compte : connectez-vous à la plateforme Infini-AI (https://cloud.infini-ai.com/genstudio/model?cherrystudio)

Obtenez votre clé API : dans la « Place des modèles », choisissez deepseek-r1, cliquez sur Créer et copiez la clé API + le nom du modèle

Étape 2 : Dans les paramètres de Cherry Studio, sélectionnez "Infini-AI", saisissez votre clé API et activez le service

Après ces étapes, choisissez le modèle dans l'interface pour utiliser le service API Infini-Ai dans Cherry Studio. Pour plus de simplicité, vous pouvez définir un « modèle par défaut ».

Étape 3 : Ajoutez une base de connaissances

Sélectionnez un modèle d'embedding (série bge ou jina) de la plateforme Infini-AI.

Après import de ressources d'apprentissage : "Synthétisez les dérivations clés du chapitre 3 du livre 'Machine Learning'"

Résultat généré :

Ce document a été traducido del chino por IA y aún no ha sido revisado.

La sauvegarde des données de Cherry Studio prend en charge le stockage compatible S3 (stockage objet). Les services de stockage compatibles S3 courants incluent : AWS S3, Cloudflare R2, Alibaba Cloud OSS, Tencent Cloud COS et MinIO.

Grâce au stockage compatible S3, vous pouvez synchroniser les données entre plusieurs appareils via la méthode : Ordinateur A Stockage S3 Ordinateur B.

Créez un compartiment de stockage d'objets (Bucket) et notez son nom. Il est fortement recommandé de définir le compartiment en lecture/écriture privée pour éviter les fuites de données de sauvegarde !!

Consultez la documentation et accédez à la console du service cloud pour obtenir les informations du stockage compatible S3 telles que Access Key ID, Secret Access Key, Endpoint, Bucket, Region, etc.

Endpoint : Adresse d'accès du stockage compatible S3, généralement sous la forme https://<bucket-name>.<region>.amazonaws.com ou https://<ACCOUNT_ID>.r2.cloudflarestorage.com.

Region : Région où se trouve le compartiment, par exemple us-west-1, ap-southeast-1, etc. Pour Cloudflare R2, indiquez auto.

Bucket : Nom du compartiment.

Access Key ID et Secret Access Key : Informations d'identification pour l'authentification.

Root Path : Optionnel, spécifie le chemin racine lors de la sauvegarde dans le compartiment, vide par défaut.

Documentation associée

Cloudflare R2 : Obtenir Access Key ID et Secret Access Key

Alibaba Cloud OSS : Obtenir Access Key ID et Access Key Secret

Tencent Cloud COS : Obtenir SecretId et SecretKey

Dans les paramètres de sauvegarde S3, remplissez les informations ci-dessus, cliquez sur le bouton Sauvegarder pour effectuer la sauvegarde, et cliquez sur le bouton Gérer pour afficher et gérer la liste des fichiers de sauvegarde.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

L'Assistant Rapide est un outil pratique proposé par Cherry Studio qui vous permet d'accéder rapidement aux fonctionnalités d'IA dans n'importe quelle application, permettant ainsi des opérations instantanées comme poser des questions, traduire, résumer et expliquer.

Ouvrir les paramètres : Accédez à Paramètres -> Raccourcis -> Assistant Rapide.

Activer l'interrupteur : Localisez et activez le bouton correspondant à Assistant Rapide.

Configurer un raccourci clavier (optionnel) :

Raccourci par défaut Windows : Ctrl + E

Raccourci par défaut macOS : ⌘ + E

Vous pouvez personnaliser le raccourci ici pour éviter les conflits ou l'adapter à vos habitudes.

Invoquer : Dans n'importe quelle application, appuyez sur votre raccourci configuré (ou le raccourci par défaut) pour ouvrir l'Assistant Rapide.

Interagir : Dans la fenêtre de l'Assistant Rapide, vous pouvez directement effectuer les opérations suivantes :

Poser des questions rapides : Interrogez l'IA sur n'importe quel sujet.

Traduire du texte : Saisissez le texte à traduire.

Résumer du contenu : Entrez un texte long pour en obtenir un résumé.

Expliquer des concepts : Saisissez des termes ou concepts nécessitant une explication.

Fermer : Appuyez sur ESC ou cliquez n'importe où en dehors de la fenêtre pour fermer.

Conflits de raccourcis : Si le raccourci par défaut entre en conflit avec une autre application, modifiez-le.

Découvrir plus de fonctionnalités : Au-delà des fonctions documentées, l'Assistant Rapide peut supporter d'autres opérations comme la génération de code ou la conversion de style. Explorez pendant l'utilisation.

Retours et améliorations : Si vous rencontrez des problèmes ou avez des suggestions, contactez l'équipe Cherry Studio via les retours.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Permet d'exporter des sujets et messages vers SiYuan Note.

Ouvrez SiYuan Note et créez un carnet

Ouvrez les paramètres du carnet et copiez l'ID du carnet

Collez l'ID du carnet dans les paramètres de Cherry Studio

Entrez l'adresse de SiYuan Note

Local

Généralement http://127.0.0.1:6806

Auto-hébergé

Votre domaine http://note.domain.com

Copiez le Jeton d'API de SiYuan Note

Collez-le dans les paramètres de Cherry Studio et vérifiez

Félicitations, la configuration de SiYuan Note est terminée ✅ Vous pouvez maintenant exporter le contenu de Cherry Studio vers votre SiYuan Note

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Connectez-vous et accédez à la page des jetons

Créez un nouveau jeton (vous pouvez aussi utiliser le jeton par défaut ↑)

Copiez le jeton

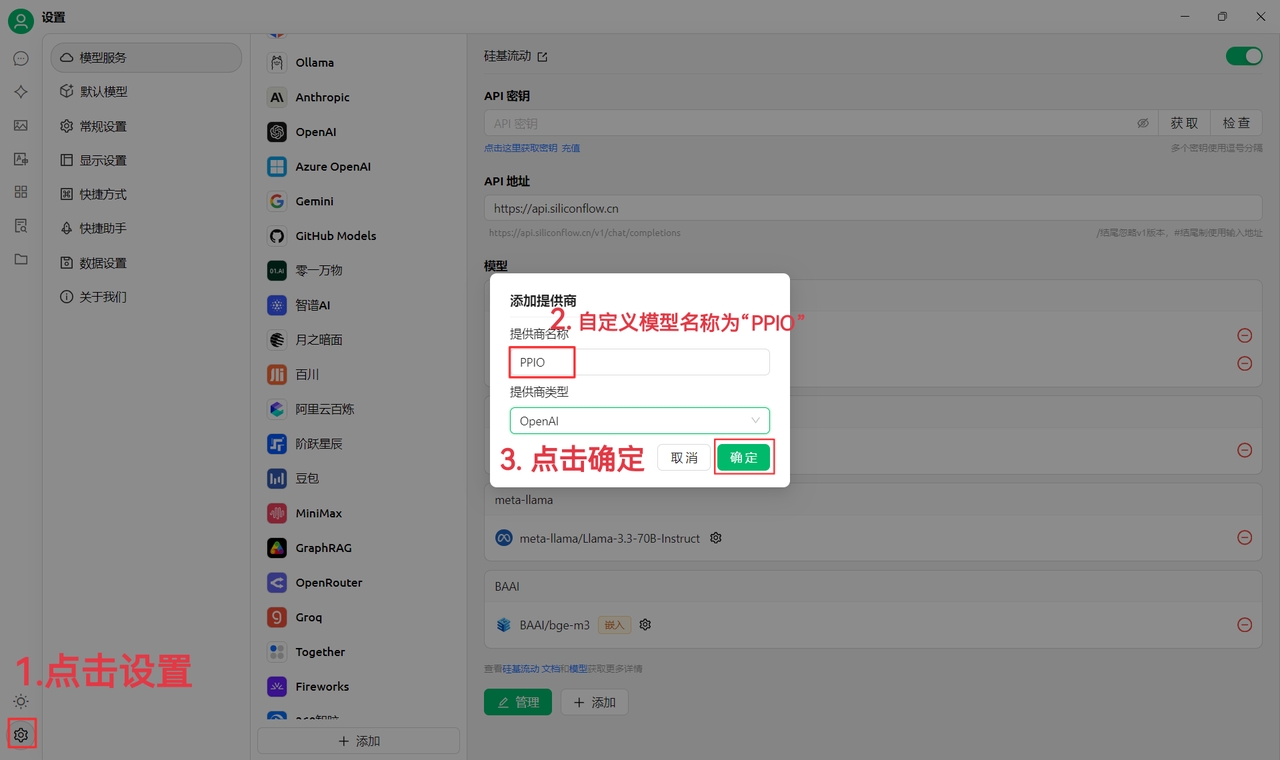

Ouvrez les paramètres des fournisseurs de CherryStudio, cliquez sur Ajouter en bas de la liste des fournisseurs

Entrez un nom de note, sélectionnez OpenAI comme fournisseur, puis cliquez sur OK

Entrez la clé que vous venez de copier

Retournez à la page où vous avez obtenu la clé API, copiez l'adresse racine dans la barre d'adresse du navigateur, par exemple :

Ajoutez les modèles (cliquez sur Gérer pour obtenir automatiquement ou saisissez manuellement) et activez l'interrupteur en haut à droite pour commencer à utiliser.

L'interface peut varier selon le thème OneAPI, mais la méthode d'ajout reste identique aux étapes ci-dessus.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Le serveur ModelScope MCP nécessite de mettre à jour Cherry Studio à la version v1.2.9 ou supérieure.

Dans la version v1.2.9, Cherry Studio a établi un partenariat officiel avec ModelScope Mofada, simplifiant considérablement les étapes d'ajout des serveurs MCP et évitant les erreurs de configuration. Vous pouvez également découvrir d'innombrables serveurs MCP dans la communauté ModelScope. Suivez maintenant les étapes pour découvrir comment synchroniser les serveurs MCP ModelScope dans Cherry Studio.

Cliquez sur les paramètres des serveurs MCP dans les réglages, sélectionnez Synchroniser les serveurs

Sélectionnez ModelScope et parcourez les services MCP disponibles

Connectez-vous à ModelScope et consultez les détails du service MCP ;

Dans les détails du service MCP, sélectionnez "Connecter le service" ;

Cliquez sur "Obtenir le jeton API" dans Cherry Studio, accédez au site officiel de ModelScope, copiez le jeton API et collez-le dans Cherry Studio.

Dans la liste des serveurs MCP de Cherry Studio, vous verrez les services MCP connectés à ModelScope et pourrez les utiliser dans les conversations.

Pour les nouveaux serveurs MCP connectés ultérieurement via la page web ModelScope, cliquez simplement sur Synchroniser les serveurs pour les ajouter de manière incrémentielle.

Grâce à ces étapes, vous maîtrisez désormais la synchronisation pratique des serveurs MCP ModelScope dans Cherry Studio. Ce processus de configuration est non seulement grandement simplifié mais évite aussi les erreurs potentielles des configurations manuelles. Vous pourrez ainsi exploiter facilement les innombrables ressources de serveurs MCP fournies par la communauté ModelScope.

Commencez à explorer et utiliser ces puissants services MCP pour enrichir votre expérience avec Cherry Studio !

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Connectez-vous et ouvrez la page des jetons

Cliquez sur "Ajouter un jeton"

Entrez le nom du jeton et cliquez sur "Soumettre" (configurez d'autres paramètres si nécessaire)

Accédez aux paramètres des fournisseurs de CherryStudio, cliquez sur Ajouter en bas de la liste des fournisseurs

Saisissez un nom de référence, sélectionnez "OpenAI" comme fournisseur, puis cliquez sur "Confirmer"

Collez la clé copiée précédemment

Revenez à la page de l'API Key, copiez l'adresse racine dans la barre d'adresse du navigateur. Exemple :

Ajoutez les modèles (cliquez sur "Gérer" pour une détection automatique ou saisissez manuellement), puis activez le commutateur en haut à droite pour les utiliser.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Ouvrez les paramètres de Cherry Studio.

Trouvez l'option Serveur MCP.

Cliquez sur Ajouter un serveur.

Remplissez les paramètres du serveur MCP (lien de référence). Les informations à fournir peuvent inclure :

Nom : un nom personnalisé, par exemple fetch-server

Type : sélectionnez STDIO

Commande : entrez uvx

Arguments : entrez mcp-server-fetch

(d'autres paramètres peuvent exister selon le serveur spécifique)

Cliquez sur Enregistrer.

Après cette configuration, Cherry Studio téléchargera automatiquement le serveur MCP requis - fetch server. Une fois le téléchargement terminé, vous pouvez commencer à l'utiliser ! Remarque : si la configuration de mcp-server-fetch échoue, essayez de redémarrer votre ordinateur.

Le serveur MCP a été ajouté avec succès dans les paramètres

Comme le montre l'image ci-dessus, grâce à la fonction fetch intégrée au MCP, Cherry Studio peut mieux comprendre l'intention des requêtes utilisateur, récupérer des informations pertinentes sur Internet et fournir des réponses plus précises et complètes.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Connectez-vous à

Cliquez directement

Cliquez sur dans la barre latérale

Créez une clé API

Après création réussie, cliquez sur l'icône en forme d'œil à côté de votre clé API pour l'afficher et la copier

Collez la clé API copiée dans CherryStudio, puis activez le commutateur du fournisseur de service.

Activez les modèles nécessaires dans de la console Ark. Vous pouvez activer la série Doubao, DeepSeek ou d'autres modèles selon vos besoins.

Dans le , localisez l'ID de modèle correspondant au modèle requis.

Accédez aux de Cherry Studio et sélectionnez Volc Engine

Cliquez sur "Ajouter" et collez l'ID de modèle obtenu dans la zone de texte ID de modèle

Ajoutez les modèles un par un en suivant ce processus

L'adresse API peut s'écrire de deux manières

La première est celle par défaut du client : https://ark.cn-beijing.volces.com/api/v3/

La deuxième écriture est : https://ark.cn-beijing.volces.com/api/v3/chat/completions#

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Suivez nos comptes sociaux : , , , ,

Rejoignez nos communautés : , , ,

Cherry Studio est une plateforme d'assistant IA polyvalente intégrant des fonctionnalités multiformes telles que dialogues multimodèles, gestion de bases de connaissances, peinture IA et traduction. La conception hautement personnalisable, les capacités d'extension puissantes et l'expérience utilisateur conviviale de Cherry Studio en font un choix idéal pour les professionnels et les passionnés d'IA. Que vous soyez débutant ou développeur, chacun trouvera dans Cherry Studio les fonctionnalités IA adaptées pour améliorer sa productivité et créativité.

Réponses multiples : Permet d'obtenir simultanément plusieurs réponses à une même question via différents modèles, facilitant la comparaison des performances. Voir .

Regroupement automatique : L'historique des conversations est automatiquement organisé par assistant pour un accès rapide.

Export des dialogues : Export complet ou partiel au format Markdown, Word etc.

Paramètres hautement personnalisables : Paramètres avancés et possibilité d'entrer des paramètres personnalisés.

Marché d'assistants : Des milliers d'assistants spécialisés par secteur (traduction, programmation, rédaction) + assistants personnalisables.

Multiformats de rendu : Prise en charge du Markdown, des formules mathématiques et du prévisualisation HTML.

Peinture IA : Panneau dédié pour générer des images via description textuelle.

Mini-applications IA : Intégration d'outils IA web sans navigation externe.

Traduction : Scénarios multiples (panneau dédié, traduction conversationnelle).

Gestion des fichiers : Classification unifiée des fichiers des conversations, peinture et connaissances.

Recherche globale : Localisation rapide dans l'historique et les bases de connaissances.

Aggrégation de modèles : Intégration OpenAI, Gemini, Anthropic, Azure etc.

Récupération automatique : Liste complète des modèles sans configuration manuelle.

Rotation de clés : Utilisation cyclique de multiples clés API contre les limitations.

Avatars personnalisés : Attribution automatique d'icônes identitaires par modèle.

Fournisseurs personnalisés : Compatibilité avec services tiers respectant les normes OpenAI/Gemini/Anthropic.

CSS personnalisé : Personnalisation globale du style visuel.

Dispositions de chat : Différents modes d'affichage inclus.

Personnalisation d'avatar : Icônes personnalisées pour logiciel et assistants.

Menu latéral ajustable : Masquage/réorganisation des éléments selon besoins.

Multiformats : Import PDF, DOCX, PPTX, XLSX, TXT, MD etc.

Sources variées : Fichiers locaux, URL, sitemaps ou saisie manuelle.

Export des connaissances : Partage des bases traitées.

Vérification intégrée : Tests de segmentation et résultats immédiats après import.

Questions rapides : Assistance instantanée depuis toute application (Wechat, navigateur).

Traduction rapide : Traduction contextuelle de textes sélectionnés.

Résumé : Synthèse rapide de contenus longs.

Explications contextuelles : Clarification sans prompts complexes.

Sauvegardes multiples : Locale, WebDAV et programmée.

Confiance locale totale : Usage complet en environnement offline avec modèles locaux.

Convivial pour débutants : Accessible sans connaissances techniques préalables.

Documentation complète : Guides détaillés et FAQ complète.

Améliorations continues : Évolutions régulières basées sur les retours utilisateurs.

Ouverture et extensibilité : Code source ouvert pour customisations avancées.

Gestion & consultation de connaissances : Recherche académique, éducation...

Dialogues créatifs : Génération de contenu multimodal.

Traduction & automatisation : Communication multilingue et traitement documentaire.

Peinture IA & design : Visualisation créative par description textuelle.

暂时不支持Claude模型

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Avant d'obtenir une clé API Gemini, vous devez avoir un projet Google Cloud (si vous en avez déjà un, cette étape peut être ignorée)

Accédez à pour créer un projet, remplissez le nom du projet et cliquez sur "Créer un projet"

Accédez à la

Activez dans le projet créé

Ouvrez l'interface des permissions et créez un compte de service

Sur la page de gestion des comptes de service, trouvez le compte nouvellement créé, cliquez sur Clés et créez une nouvelle clé au format JSON

Après création réussie, le fichier de clé sera automatiquement enregistré sur votre ordinateur au format JSON - veuillez le conserver en lieu sûr

Sélectionnez le fournisseur de services Vertex AI

Remplissez les champs correspondants avec les données du fichier JSON

Cliquez sur "Ajouter " pour commencer à utiliser joyeusement !

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Sur la page officielle des , cliquez sur + Create new secret key

Copiez la clé générée, puis accédez aux de CherryStudio

Recherchez le fournisseur OpenAI et saisissez la clé obtenue

Cliquez sur "Gérer" ou "Ajouter" en bas de page, ajoutez les modèles pris en charge, puis activez le bouton du fournisseur en haut à droite pour commencer à l'utiliser.

如何在 Cherry Studio 使用联网模式

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Dans la fenêtre de question de Cherry Studio, cliquez sur l'icône 【Globe terrestre】 pour activer le mode en ligne.

Mode 1 : Les modèles des opérateurs possèdent une fonction de recherche en ligne intégrée

Dans ce cas, après avoir activé le mode en ligne, vous pouvez directement utiliser le service, c'est très simple.

Vous pouvez rapidement vérifier si un modèle prend en charge la connexion Internet en cherchant une petite icône de carte après son nom dans la partie supérieure de l'interface de question-réponse.

Sur la page de gestion des modèles, cette méthode vous permet également de distinguer rapidement les modèles prenant en charge le mode en ligne.

Opérateurs de modèles avec fonction de recherche en ligne actuellement pris en charge par Cherry Studio

Google Gemini

OpenRouter (tous les modèles prennent en charge la connexion Internet)

Tencent Hunyuan

Zhipu AI

Alibaba Cloud Bailian, etc.

Remarque importante : Il existe un cas particulier où même sans l'icône de globe terrestre, un modèle peut accéder à Internet, comme expliqué dans le tutoriel ci-dessous.

Mode 2 : Les modèles sans fonction de recherche utilisent le service Tavily pour accéder à Internet

Lorsqu'un modèle ne possède pas de fonction de recherche intégrée (pas d'icône de globe après son nom), mais que vous avez besoin d'informations en temps réel, utilisez le service de recherche Internet Tavily.

Lors de la première utilisation du service Tavily, une fenêtre contextuelle vous guidera dans la configuration. Suivez simplement les instructions !

Après avoir cliqué "Obtenir la clé", vous serez redirigé vers le site officiel de Tavily. Inscrivez-vous, connectez-vous, créez une clé API, puis copiez-la dans Cherry Studio.

Besoin d'aide pour l'inscription ? Consultez le tutoriel dans ce même répertoire.

Document de référence pour Tavily :

L'interface suivante indique une inscription réussie.

Testez à nouveau : les résultats montrent une recherche Internet fonctionnelle, avec un nombre de résultats par défaut de 5.

Remarque : Tavily impose des limites d'utilisation gratuite mensuelle. Le dépassement entraîne des frais.

PS : Si vous détectez des erreurs, n'hésitez pas à nous contacter.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

L'installation automatique du MCP nécessite la mise à niveau de Cherry Studio en version v1.1.18 ou ultérieure.

En complément de l'installation manuelle, Cherry Studio intègre l'outil @mcpmarket/mcp-auto-install, offrant une méthode plus pratique pour installer un serveur MCP. Il suffit d'entrer la commande appropriée dans une conversation avec un modèle prenant en charge les services MCP.

Rappel de la phase de test :

@mcpmarket/mcp-auto-install est actuellement en phase de test

L'efficacité dépend de "l'intelligence" du modèle : certaines configurations s'appliquent automatiquement, d'autres exigent des ajustements manuels dans les paramètres MCP

La source de recherche actuelle est @modelcontextprotocol, modifiable via configuration (voir ci-dessous)

Par exemple, saisissez :

Le système identifie automatiquement votre requête et complète l'installation via @mcpmarket/mcp-auto-install. Cet outil prend en charge divers types de serveurs MCP, notamment :

filesystem (système de fichiers)

fetch (requête réseau)

sqlite (base de données)

etc.

La variable MCP_PACKAGE_SCOPES permet de personnaliser les sources de recherche des services MCP (valeur par défaut :

@modelcontextprotocol).

@mcpmarket/mcp-auto-installCe document a été traducido del chino por IA y aún no ha sido revisado.

La base de connaissances Dify MCP nécessite de mettre à jour Cherry Studio vers la version v1.2.9 ou supérieure.

Ouvrez 搜索MCP.

Ajoutez le serveur dify-knowledge.

Il est nécessaire de configurer les paramètres et les variables d'environnement

La clé de la base de connaissances Dify peut être obtenue de la manière suivante

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Le prétraitement des documents de la base de connaissances nécessite la mise à niveau de Cherry Studio vers la version v1.4.8 ou ultérieure.

Après avoir cliqué sur "Obtenir la clé API", l'adresse de demande s'ouvrira dans votre navigateur. Cliquez sur "Demander maintenant", remplissez le formulaire pour obtenir votre clé API, puis saisissez-la dans le champ correspondant.

Dans la base de connaissances créée, effectuez la configuration ci-dessus pour finaliser la configuration du prétraitement des documents.

Vous pouvez utiliser la recherche en haut à droite pour vérifier les résultats de la base de connaissances

Astuce pour la base de connaissances : Lors de l'utilisation de modèles plus performants, modifiez le mode de recherche de la base de connaissances en "reconnaissance d'intention". Cette méthode permet une description plus précise et complète de votre question.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Nous sommes heureux d'accueillir les contributions à Cherry Studio ! Vous pouvez contribuer de plusieurs manières :

Contribuer au code : Développer de nouvelles fonctionnalités ou optimiser le code existant.

Corriger des bugs : Soumettre des corrections pour les bogues que vous découvrez.

Gérer les problèmes : Aider à administrer les issues GitHub.

Conception du produit : Participer aux discussions de design.

Rédiger la documentation : Améliorer les manuels utilisateurs et guides.

Participation communautaire : Rejoindre les discussions et aider les utilisateurs.

Promouvoir l'utilisation : Faire connaître Cherry Studio.

Envoyez un email à

Objet : Demande pour devenir contributeur Corps : Raison de votre candidature

# Huawei Cloud

I. Créez un compte et connectez-vous sur [Huawei Cloud](https://auth.huaweicloud.com/authui/login)

II. Cliquez sur [ce lien](https://console.huaweicloud.com/modelarts/?region=cn-southwest-2#/model-studio/homepage) pour accéder à la console ModelArts

III. Autorisation

<details>

<summary>Procédure d'autorisation (ignorer si déjà autorisé)</summary>

1. Après avoir accédé au lien (II), suivez les instructions pour accéder à la page d'autorisation (cliquez sur Utilisateur IAM → Nouvelle délégation → Utilisateur standard)

.png>)

2. Après avoir cliqué sur Créer, revenez à la page du lien (II)

3. Un message indique des autorisations d'accès insuffisantes, cliquez sur "Cliquez ici" dans le message

4. Ajoutez l'autorisation existante et confirmez

.png>)

Note : Cette méthode convient aux débutants, pas besoin de lire beaucoup de contenu, suivez simplement les instructions. Si vous parvenez à obtenir l'autorisation du premier coup, utilisez votre propre méthode.

</details>

IV. Cliquez sur Gestion de l'authentification dans la barre latérale, créez une clé API (secret) et copiez-la

<figure><img src="../../.gitbook/assets/微信截图_20250214034650.png" alt=""><figcaption></figcaption></figure>

Puis créez un nouveau fournisseur dans CherryStudio

<figure><img src="../../.gitbook/assets/image (1) (2).png" alt="" width="300"><figcaption></figcaption></figure>

Après création, saisissez la clé secrète

V. Cliquez sur Déploiement de modèles dans la barre latérale et récupérez tous

<figure><img src="../../.gitbook/assets/微信截图_20250214034751.png" alt=""><figcaption></figcaption></figure>

VI. Cliquez sur Appel

<figure><img src="../../.gitbook/assets/image (1) (2) (1).png" alt=""><figcaption></figcaption></figure>

Copiez l'adresse à ①, collez-la dans l'adresse du fournisseur CherryStudio et ajoutez un "#" à la fin

et ajoutez un "#" à la fin

et ajoutez un "#" à la fin

et ajoutez un "#" à la fin

et ajoutez un "#" à la fin

Pourquoi ajouter un "#" ? [Voir ici](https://docs.cherry-ai.com/cherrystudio/preview/settings/providers#api-di-zhi)

> Bien sûr, vous pouvez aussi ignorer cela et suivre simplement le tutoriel;

> Vous pouvez également utiliser la méthode de suppression de v1/chat/completions pour remplir. Utilisez votre méthode si vous savez comment faire, sinon suivez strictement le tutoriel.

<figure><img src="../../.gitbook/assets/image (2) (3).png" alt=""><figcaption></figcaption></figure>

Copiez ensuite le nom du modèle à ②, dans CherryStudio cliquez sur le bouton "+Ajouter" pour créer un nouveau modèle

<figure><img src="../../.gitbook/assets/image (4) (3).png" alt=""><figcaption></figcaption></figure>

Saisissez le nom du modèle tel quel, sans modifications ou guillemets. Copiez exactement comme dans l'exemple.

<figure><img src="../../.gitbook/assets/image (3) (3).png" alt=""><figcaption></figcaption></figure>

Cliquez sur Ajouter un modèle pour terminer.

{% hint style="info" %}

Dans Huawei Cloud, chaque modèle ayant une adresse différente, chaque modèle nécessite un nouveau fournisseur. Répétez simplement les étapes ci-dessus.

{% endhint %}

帮我安装一个 filesystem mcp server// `axun-uUpaWEdMEMU8C61K` correspond à l'ID de service, personnalisable

"axun-uUpaWEdMEMU8C61K": {

"name": "mcp-auto-install",

"description": "Automatically install MCP services (Beta version)",

"isActive": false,

"registryUrl": "https://registry.npmmirror.com",

"command": "npx",

"args": [

"-y",

"@mcpmarket/mcp-auto-install",

"connect",

"--json"

],

"env": {

"MCP_REGISTRY_PATH": "Détails sur https://www.npmjs.com/package/@mcpmarket/mcp-auto-install"

},

"disabledTools": []

}

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Contactez par e-mail [email protected] pour obtenir l'accès éditeur

Sujet : Demande d'accès éditeur à Cherry Studio Docs Corps : Indiquez vos motivations

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Bienvenue sur Cherry Studio (ci-après dénommé "ce logiciel" ou "nous"). Nous accordons une grande importance à la protection de votre vie privée. Cette politique de confidentialité explique comment nous traitons et protégeons vos informations personnelles et vos données. Veuillez lire attentivement et comprendre cette politique avant d'utiliser ce logiciel :

Pour optimiser l'expérience utilisateur et améliorer la qualité du logiciel, nous ne collectons que les informations non personnelles suivantes de manière anonyme :

• Informations sur la version du logiciel ; • Activité et fréquence d'utilisation des fonctionnalités du logiciel ; • Journaux de plantages et d'erreurs anonymes ;

Ces informations sont totalement anonymes, ne concernent aucune donnée d'identification personnelle et ne peuvent être associées à vos informations personnelles.

Pour protéger au maximum votre vie privée, nous nous engageons explicitement à :

• Ne pas collecter, conserver, transmettre ou traiter les informations de clé API des services de modèles que vous saisissez dans ce logiciel ; • Ne pas collecter, conserver, transmettre ou traiter les données de conversation générées lors de votre utilisation de ce logiciel, y compris mais sans s'y limiter : contenu des discussions, informations d'instruction, données de base de connaissances, données vectorielles et autres contenus personnalisés ; • Ne pas collecter, conserver, transmettre ou traiter des informations sensibles permettant d'identifier personnellement un individu.

Ce logiciel utilise la clé API des fournisseurs de services de modèles tiers que vous avez demandée et configurée vous-même, afin d'effectuer les appels aux modèles correspondants et d'assurer les fonctionnalités de conversation. Les services de modèles que vous utilisez (par exemple, grands modèles, interfaces API, etc.) sont fournis par le fournisseur tiers que vous avez choisi et relèvent entièrement de sa responsabilité. Cherry Studio agit uniquement comme un outil local fournissant des fonctions d'appel d'interface avec les services de modèles tiers.

Par conséquent :

• Toutes les données de conversation générées entre vous et les services de grands modèles sont indépendantes de Cherry Studio. Nous ne participons ni au stockage des données, ni à toute forme de transmission ou de transit de données ; • Vous devez consulter et accepter vous-même la politique de confidentialité et les politiques associées du fournisseur de services de modèles tiers correspondant. Ces politiques de confidentialité sont accessibles sur les sites officiels de chaque fournisseur.

Vous assumez vous-même les risques potentiels pour la vie privée liés à l'utilisation des services de fournisseurs de modèles tiers. Pour les politiques de confidentialité spécifiques, les mesures de sécurité des données et les responsabilités associées, veuillez consulter le contenu pertinent sur le site officiel du fournisseur de services de modèles choisi. Nous déclinons toute responsabilité à cet égard.

Cette politique peut être ajustée lors des mises à jour des versions du logiciel. Veuillez la consulter régulièrement. En cas de modification substantielle de la politique, nous vous en informerons par des moyens appropriés.

Si vous avez des questions concernant le contenu de cette politique ou les mesures de protection de la vie privée de Cherry Studio, n'hésitez pas à nous contacter à tout moment.

Nous vous remercions d'avoir choisi et fait confiance à Cherry Studio. Nous continuerons à vous offrir une expérience produit sûre et fiable.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Pour permettre à chaque développeur et utilisateur d'expérimenter facilement les capacités des grands modèles de pointe, Zhipu ouvre gratuitement le modèle GLM-4.5-Air aux utilisateurs de Cherry Studio. Conçu spécialement pour les applications d'agents intelligents (Agent), ce modèle fondamental efficace offre un équilibre exceptionnel entre performance et coût, représentant le choix idéal pour construire des applications intelligentes.

🚀 Qu'est-ce que GLM-4.5-Air ?

GLM-4.5-Air est le dernier modèle linguistique haute performance de Zhipu, utilisant une architecture avancée d'experts mixtes (Mixture-of-Experts, MoE) qui maintient une capacité de raisonnement exceptionnelle tout en réduisant significativement la consommation de ressources informatiques.

Paramètres totaux : 106 milliards

Paramètres activés : 12 milliards

Grâce à sa conception épurée, GLM-4.5-Air offre une meilleure efficacité d'inférence, idéale pour des déploiements en environnement contraint tout en conservant une aptitude à traiter des tâches complexes.

📚 Flux de formation unifié, base solide d'intelligence

GLM-4.5-Air partage le même flux de formation que la série phare, garantissant une base solide de capacités universelles :

Préformation à grande échelle : Entraînement sur un corpus général de 15 000 milliards de tokens accumulant une large compréhension ;

Optimisation spécifique : Renforcement sur tâches clés comme la génération de code, le raisonnement logique et les interactions agents ;

Contexte étendu : Longueur de contexte augmentée à 128K tokens, traitant documents longs, dialogues complexes ou projets de code volumineux ;

Amélioration par apprentissage par renforcement : Optimisation des capacités décisionnelles en planification et appel d'outils via RL.

Ce système confère à GLM-4.5-Air une excellente capacité de généralisation et d'adaptation aux tâches.

⚙️ Capacités optimisées pour les agents intelligents

GLM-4.5-Air est spécialement adapté aux scénarios d'agents avec ces capacités pratiques :

✅ Appel d'outils : Interfaçage normé pour automatiser des tâches via des outils externes ✅ Navigation et extraction web : Compréhension et interaction avec du contenu dynamique via extensions ✅ Assistance génie logiciel : Analyse des besoins, génération de code, détection/réparation de bugs ✅ Support front-end : Bonne compréhension/génération des technologies HTML/CSS/JavaScript

Intégrable aux frameworks d'agents de code comme Claude Code ou Roo Code, il sert aussi de moteur central pour tout agent personnalisé.

💡 Mode "réflexion intelligente", adaptation souple aux requêtes

GLM-4.5-Air propose un mode de raisonnement hybride contrôlé par le paramètre thinking.type :

enabled : Réflexion approfondie pour tâches complexes nécessitant une planification

disabled : Désactivée pour requêtes simples ou réponses instantanées

Valeur par défaut : mode réflexion dynamique (auto-évaluation de la nécessité d'analyse)

Tâche simple (réflexion déconseillée)

• Question : "Quand Zhipu AI a été créée ?" • Traduction : "Traduis 'I love you' en chinois"

Tâche moyenne (réflexion conseillée)

• Comparaison avion/TGV Pékin-Shanghai • Explication du nombre élevé de lunes de Jupiter

Tâche complexe (réflexion fortement conseillée)

• Explication de la collaboration experte dans MoE • Analyse d'opportunité d'achat d'ETF

🌟 Efficace et rentable, déploiement simplifié

GLM-4.5-Air atteint un équilibre optimal performance/coût pour déploiements professionnels :

⚡ Vitesse > 100 tokens/sec pour interactions réactives à faible latence

💰 Coût API très bas : Entrée 0.8 ¥ / million tokens, sortie 2 ¥ / million tokens

🖥️ Faible consommation de ressources informatiques, déploiement aisé local/cloud haute concurrency

Une véritable expérience IA "haute performance, faible barrière d'entrée".

🧠 Capacité clé : génération intelligente de code

GLM-4.5-Air excelle en génération de code avec :

Support des langages Python, JavaScript, Java

Génération de code lisible, maintenable via instructions naturelles

Réduction du code "boilerplate", alignement aux besoins réels

Idéal pour prototypage rapide, complétion auto et correction de bugs.

Expérimentez gratuitement GLM-4.5-Air dès maintenant et lancez votre projet d'agent intelligent ! Que vous construisiez un assistant auto, un compagnon de programmation ou une application IA nouvelle génération, GLM-4.5-Air sera votre moteur IA fiable et performant.

📘 Connectez-vous immédiatement pour libérer votre créativité !

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Cherry Studio prend en charge la sauvegarde des données via le protocole WebDAV. Vous pouvez choisir un service WebDAV adapté pour effectuer des sauvegardes dans le cloud.

Basé sur WebDAV, il est possible de synchroniser les données entre plusieurs appareils via le schéma : Ordinateur A WebDAV Ordinateur B.

Connectez-vous à Nutstore, cliquez sur votre nom d'utilisateur en haut à droite et sélectionnez "Informations du compte" :

Choisissez "Options de sécurité" puis cliquez sur "Ajouter une application" :

Entrez le nom de l'application et générez un mot de passe aléatoire :

Copiez et enregistrez le mot de passe :

Récupérez l'adresse du serveur, le compte et le mot de passe :

Dans les paramètres de Cherry Studio → Paramètres des données, renseignez les informations WebDAV :

Sélectionnez la sauvegarde ou la restauration des données, et configurez si besoin la périodicité des sauvegardes automatiques :

Les services WebDAV les plus accessibles sont généralement les solutions de stockage cloud :

123 Pan (abonnement requis)

Aliyun Drive (achat requis)

Box (espace gratuit de 10 Go, limitation à 250 Mo par fichier)

Dropbox (2 Go gratuits, extensibles à 16 Go par parrainage)

TeraCloud (10 Go gratuits + 5 Go supplémentaires par invitation)

Yandex Disk (10 Go pour les utilisateurs gratuits)

Solutions nécessitant un déploiement autonome :

如何注册tavily?

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Accédez au site officiel ci-dessus ou, depuis Cherry Studio > Paramètres > Recherche Web > Cliquez sur "Obtenir une clé", ce qui vous redirigera directement vers la page de connexion/d'inscription de Tavily.

Si c'est votre première utilisation, vous devez d'abord créer un compte (Sign up) avant de pouvoir vous connecter (Log in). Par défaut, vous serez redirigé vers la page de connexion.

Cliquez sur "S'inscrire", entrez votre e-mail habituel ou utilisez votre compte Google/GitHub, puis définissez un mot de passe (procédure standard).

🚨🚨🚨ÉTAPE CRUCIALE Après l'inscription, une vérification en deux étapes est nécessaire : scannez le QR code pour générer un code à usage unique.

Deux solutions :

Téléchargez l'application Microsoft Authenticator (légèrement complexe)

Utilisez le mini-programme WeChat : Authentificateur Tencent (simple, recommandé)

Sur WeChat, recherchez le mini-programme : Authentificateur Tencent

Après ces étapes, l'interface ci-dessous s'affiche : copiez votre clé dans Cherry Studio pour commencer à l'utiliser.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Ollama est un excellent outil open source qui vous permet d'exécuter et de gérer facilement divers grands modèles de langage (LLM) localement. Cherry Studio prend désormais en charge l'intégration d'Ollama, vous permettant d'interagir directement avec des LLM déployés localement dans une interface familière, sans dépendre des services cloud !

Ollama est un outil qui simplifie le déploiement et l'utilisation des grands modèles de langage (LLM). Il présente les caractéristiques suivantes :

Exécution locale : Les modèles s'exécutent entièrement sur votre ordinateur local, sans nécessiter de connexion Internet, protégeant ainsi votre vie privée et la sécurité de vos données.

Simplicité d'utilisation : Avec de simples commandes en ligne de commande, vous pouvez télécharger, exécuter et gérer divers LLM.

Modèles variés : Prend en charge de nombreux modèles open source populaires tels que Llama 2, Deepseek, Mistral, Gemma, etc.

Multiplateforme : Compatible avec les systèmes macOS, Windows et Linux.

API ouverte : Prend en charge une interface compatible avec OpenAI, permettant une intégration avec d'autres outils.

Pas de service cloud nécessaire : Plus de limitations de quotas ou de frais liés aux API cloud, profitez pleinement de la puissance des LLM locaux.

Confidentialité des données : Toutes vos données de conversation restent sur votre appareil local, vous n'avez pas à craindre la fuite de vos données privées.

Disponible hors ligne : Vous pouvez continuer à interagir avec le LLM même sans connexion Internet.

Personnalisation : Vous pouvez sélectionner et configurer le LLM qui vous convient le mieux selon vos besoins.

Tout d'abord, vous devez installer et exécuter Ollama sur votre ordinateur. Suivez ces étapes :

Télécharger Ollama : Visitez le site officiel d'Ollama (https://ollama.com/), téléchargez le package d'installation correspondant à votre système d'exploitation. Pour Linux, vous pouvez directement exécuter la commande suivante pour installer Ollama :

curl -fsSL https://ollama.com/install.sh | shInstaller Ollama : Suivez les instructions de l'installateur pour terminer l'installation.

Télécharger un modèle : Ouvrez un terminal (ou invite de commandes), utilisez la commande ollama run pour télécharger le modèle que vous souhaitez utiliser. Par exemple, pour télécharger le modèle Llama 2, vous pouvez exécuter :

ollama run llama3.2Ollama téléchargera et exécutera automatiquement ce modèle.

Gardez Ollama en cours d'exécution : Pendant que vous interagissez avec les modèles Ollama via Cherry Studio, assurez-vous qu'Ollama reste en cours d'exécution.

Ensuite, ajoutez Ollama en tant que fournisseur de services d'IA personnalisé dans Cherry Studio :

Ouvrir les paramètres : Dans la barre de navigation gauche de l'interface Cherry Studio, cliquez sur "Paramètres" (icône d'engrenage).

Accéder aux services de modèle : Sur la page des paramètres, sélectionnez l'onglet "Services de modèle".

Ajouter un fournisseur : Cliquez sur Ollama dans la liste.

Dans la liste des fournisseurs de services, trouvez l'Ollama que vous venez d'ajouter et configurez-le en détail :

État d'activation :

Assurez-vous que l'interrupteur à l'extrême droite du fournisseur Ollama est activé, indiquant qu'il est en service.

Clé API :

Ollama n'a pas besoin par défaut d'une clé API. Vous pouvez laisser ce champ vide ou y mettre n'importe quel contenu.

Adresse API :

Remplissez l'adresse de l'API locale fournie par Ollama. Généralement, l'adresse est :

http://localhost:11434/Si vous avez modifié le port, ajustez-le en conséquence.

Temps de maintien en activité : Cette option définit la durée de maintien de la session en minutes. Si aucune nouvelle conversation n'a lieu dans le temps imparti, Cherry Studio se déconnecte automatiquement d'Ollama pour libérer des ressources.

Gestion des modèles :

Cliquez sur le bouton "+ Ajouter" pour ajouter manuellement le nom du modèle que vous avez déjà téléchargé dans Ollama.

Par exemple, si vous avez téléchargé le modèle llama3.2 via ollama run llama3.2, vous pouvez entrer llama3.2 ici.

Cliquez sur le bouton "Gérer" pour modifier ou supprimer les modèles ajoutés.

Une fois la configuration ci-dessus terminée, vous pouvez dans l'interface de chat de Cherry Studio, sélectionner le fournisseur de services Ollama et le modèle que vous avez téléchargé, et commencer à dialoguer avec votre LLM local !

Première exécution d'un modèle : Lors de la première exécution d'un modèle, Ollama a besoin de télécharger les fichiers du modèle, ce qui peut prendre du temps, soyez patient.

Voir les modèles disponibles : Exécutez la commande ollama list dans un terminal pour voir la liste des modèles Ollama que vous avez téléchargés.

Exigences matérielles : L'exécution de grands modèles de langage nécessite certaines ressources informatiques (CPU, mémoire, GPU), assurez-vous que la configuration de votre ordinateur répond aux exigences du modèle.

Documentation d'Ollama : Vous pouvez cliquer sur le lien Voir la documentation et les modèles d'Ollama dans la page de configuration pour accéder rapidement à la documentation officielle d'Ollama.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

L'Assistant permet de personnaliser les paramètres du modèle sélectionné pour l'utiliser, comme les préréglages de prompts et de paramètres. Ces réglages permettent d'aligner le modèle sur vos attentes de travail.

L'Assistant par défaut du système contient des paramètres génériques (sans prompt). Vous pouvez l'utiliser directement ou chercher des préréglages adaptés dans la .

L'Assistant est le parent des Sujets. Un assistant unique peut créer plusieurs sujets (conversations). Tous les sujets partagent les mêmes paramètres et prompts de l'assistant.

Nouveau sujet Crée un nouveau sujet dans l'assistant actuel.

Importer image ou document

Images : nécessitent une prise en charge par le modèle

Documents : analysés automatiquement en texte comme contexte pour le modèle.

Recherche web Configurez d'abord les paramètres dans les réglages. Les résultats alimentent le contexte du modèle. Voir .

Base de connaissances Active la base de connaissances. Voir .

Serveur MCP Active la fonctionnalité de serveur MCP. Voir .

Générer une image Non affiché par défaut. Pour les modèles compatibles (ex : Gemini), activez manuellement pour générer des images.

Choisir un modèle Change le modèle pour les réponses suivantes tout en conservant le contexte.

Phrases rapides Utilisez des phrases prédéfinies dans les réglages. Supporte les variables.

Effacer les messages Supprime tout le contenu du sujet actuel.

Agrandir Agrandit la zone de dialogue pour les longs textes.

Effacer le contexte Réinitialise le contexte du modèle sans supprimer le contenu ("oubli" des conversations précédentes).

Estimation Tokens Affiche :

Contexte actuel

Contexte max (∞ = illimité)

Caractères saisis

Tokens estimés

Traduire Traduit le contenu actuel en anglais.

Synchronisés avec les Paramètres du modèle des paramètres de l'assistant. Voir .

Séparateur de messages :Ajoute une ligne de séparation entre le contenu et les actions.

Utiliser les polices serif :Change le style de police. Personnalisation via .

Afficher les numéros de ligne des blocs de code :Affiche les numéros de ligne pour les extraits de code.

Blocs de code repliables :Replie automatiquement les blocs de code longs.

Retour à la ligne dans les blocs de code :Retourne à la ligne automatiquement pour les longues lignes de code.

Repli automatique des processus de réflexion :Replie automatiquement le raisonnement des modèles après réflexion.

Style des messages :Bulle de discussion ou style liste.

Thème des blocs de code :Change le style d'affichage des extraits de code.

Moteur de formules mathématiques :KaTeX : Rendu rapide (optimisé performance)

MathJax : Rendu lent mais complet (plus de symboles)

Taille de police des messages :Ajuste la taille du texte.

Afficher l'estimation de Tokens :Affiche les Tokens estimés pour le texte saisi (indicatif).

Coller les longs textes en tant que fichier :Transforme les longs textes collés en fichiers pour éviter les interférences.

Rendu Markdown pour les messages entrants :Désactivé : Ne rend que les réponses du modèle. Activé : Rend aussi les messages envoyés.

Ce document a été traducido del chino por IA y aún no ha sido revisado.

La plateforme de service MaaS renommée "Silicom Flow" offre gratuitement un service d'appel du modèle Qwen3-8B à tous. Membre à haut rendement de la série Qwen3 de Tongyi Qianwen, Qwen3-8B allie performances puissantes et format compact, idéal pour les applications intelligentes et le développement efficace.

🚀 Qu'est-ce que Qwen3-8B ?

Qwen3-8B est un modèle dense de 8 milliards de paramètres de la troisième génération de grands modèles Tongyi Qianwen publié par Alibaba en avril 2025. Adoptant la licence open source Apache 2.0, il peut être librement utilisé dans des contextes commerciaux et de recherche.

Paramètres totaux : 8 milliards

Type d'architecture : Dense (structure purement dense)

Longueur contextuelle : 128K tokens

Multilingue : prend en charge 119 langues et dialectes

Malgré sa taille compacte, Qwen3-8B affiche des performances stables en raisonnement, code, mathématiques et capacités d'agent, rivalisant avec les grands modèles précédents et démontrant une praticabilité exceptionnelle.

📚 Base d'entraînement solide, grande intelligence dans un petit format

Qwen3-8B est pré-entraîné sur environ 36 billions de tokens de données multilingues de haute qualité, couvrant textes web, documents techniques, bases de code et données synthétiques spécialisées pour une vaste couverture des connaissances.

Sa post-formation intègre un processus de renforcement en quatre étapes, optimisant spécifiquement :

✅ Compréhension et génération du langage naturel ✅ Raisonnement mathématique et analyse logique ✅ Traduction et expression multilingues ✅ Appel d'outils et planification de tâches

Grâce à cette amélioration systémique, les performances réelles de Qwen3-8B égalent voire surpassent Qwen2.5-14B, marquant un bond significatif en efficacité paramétrique.

💡 Mode de raisonnement hybride : réfléchir ou répondre rapidement ?

Qwen3-8B permet une commutation flexible entre "mode réflexion" et "mode non-réflexion", permettant aux utilisateurs de choisir la réponse selon la complexité de la tâche.

Contrôle via :

Paramètre API : enable_thinking=True/False

Commande dans le prompt : ajouter /think ou /no_think à l'entrée

Ce design offre un équilibre personnalisable entre vitesse de réponse et profondeur de raisonnement, optimisant l'expérience utilisateur.

⚙️ Capacités Agent natives pour des applications intelligentes

Qwen3-8B possède d'excellentes capacités d'agentisation, s'intégrant facilement dans divers systèmes automatisés :

🔹 Appel de fonctions (Function Calling) : prise en charge des appels d'outils structurés 🔹 Compatibilité MCP : support natif du protocole de contexte de modèle pour étendre les capacités externes 🔹 Collaboration multi-outils : intègre des plugins comme la recherche, calculatrice, exécution de code, etc.

Recommandé avec le framework Qwen-Agent pour construire rapidement des assistants intelligents dotés de mémoire, planification et capacités d'exécution.

🌐 Support linguistique étendu pour des applications mondiales

Qwen3-8B prend en charge 119 langues et dialectes dont chinois, anglais, arabe, espagnol, japonais, coréen et indonésien. Idéal pour :

Développement de produits internationaux

Service client multilingue

Génération de contenu polyglotte

Excellente compréhension du chinois (simplifié, traditionnel, cantonais), adapté aux marchés de Hong Kong, Macao, Taiwan et communautés chinoises d'outre-mer.

🧠 Fortes capacités pratiques, large spectre d'applications

Qwen3-8B excelle dans des scénarios fréquents :

✅ Génération de code : Python, JavaScript, Java, etc. ; produit du code exécutable sur demande ✅ Raisonnement mathématique : résultats stables sur des benchmarks comme GSM8K, adapté aux applications éducatives ✅ Création de contenu : rédige e-mails, rapports, textes avec structure claire et langage naturel ✅ Assistant intelligent : construit des IA légères pour FAQ de bases de connaissances, gestion d'agendas, extraction d'informations

Essayez gratuitement Qwen3-8B dès maintenant via Silicom Flow et lancez votre voyage dans l'IA légère !

📘 Utilisez-le maintenant, rendez l'IA accessible !

Ce document a été traducido del chino por IA y aún no ha sido revisado.

Cherry Studio intègre non seulement les principaux services de modèles d'IA, mais vous offre également une puissante capacité de personnalisation. Grâce à la fonctionnalité Fournisseurs d'IA personnalisés, vous pouvez facilement intégrer n'importe quel modèle d'IA dont vous avez besoin.

Flexibilité : Libérez-vous des limites des listes prédéfinies de fournisseurs, choisissez librement le modèle d'IA qui correspond le mieux à vos besoins.

Diversité : Essayez divers modèles d'IA de différentes plateformes, découvrez leurs avantages uniques.

Contrôle : Gérez directement vos clés API et adresses d'accès pour garantir la sécurité et la confidentialité.

Personnalisation : Intégrez des modèles déployés en privé pour répondre aux besoins de scénarios métiers spécifiques.

En quelques étapes simples, vous pouvez ajouter votre fournisseur d'IA personnalisé à Cherry Studio :

Ouvrir les paramètres : Dans la barre de navigation de gauche de l'interface Cherry Studio, cliquez sur "Paramètres" (icône d'engrenage).

Accéder aux services de modèles : Dans la page des paramètres, sélectionnez l'onglet "Services de modèles".

Ajouter un fournisseur : Sur la page "Services de modèles", vous verrez la liste des fournisseurs existants. Cliquez sur le bouton "+ Ajouter" sous la liste pour ouvrir la fenêtre contextuelle "Ajouter un fournisseur".

Remplir les informations : Dans la fenêtre contextuelle, vous devez remplir les informations suivantes :

Nom du fournisseur : Attribuez un nom facilement identifiable à votre fournisseur personnalisé (exemple : MyCustomOpenAI).

Type de fournisseur : Sélectionnez le type de votre fournisseur dans la liste déroulante. Actuellement pris en charge :

OpenAI

Gemini

Anthropic

Azure OpenAI

Enregistrer la configuration : Après avoir rempli les informations, cliquez sur le bouton "Ajouter" pour sauvegarder votre configuration.

Après l'ajout, vous devez trouver le fournisseur que vous venez d'ajouter dans la liste et effectuer une configuration détaillée :

État d'activation : À l'extrémité droite de la liste des fournisseurs personnalisés se trouve un interrupteur d'activation. L'activer signifie que ce service personnalisé est activé.

Clé API :

Saisissez la clé API (API Key) fournie par votre fournisseur de services d'IA.

Cliquez sur le bouton "Vérifier" à droite pour vérifier la validité de la clé.

Adresse API :

Renseignez l'adresse d'accès API (Base URL) du service d'IA.

Veuillez consulter la documentation officielle de votre fournisseur d'IA pour obtenir l'adresse API correcte.

Gestion des modèles :

Cliquez sur le bouton "+ Ajouter" pour ajouter manuellement l'ID du modèle que vous souhaitez utiliser sous ce fournisseur. Par exemple gpt-3.5-turbo, gemini-pro, etc.

* Si vous n'êtes pas sûr du nom exact du modèle, référez-vous à la documentation officielle de votre fournisseur d'IA. * Cliquez sur le bouton "Gérer" pour modifier ou supprimer les modèles déjà ajoutés.

Une fois la configuration ci-dessus terminée, vous pouvez sélectionner votre fournisseur d'IA personnalisé et votre modèle dans l'interface de chat de Cherry Studio pour commencer à dialoguer avec l'IA !

vLLM est une bibliothèque d'inférence LLM rapide et facile à utiliser, similaire à Ollama. Voici comment l'intégrer à Cherry Studio :

Installer vLLM : Suivez la documentation officielle de vLLM () pour l'installer.

Lancer le service vLLM : Démarrez le service en utilisant l'interface compatible OpenAI fournie par vLLM. Deux méthodes principales sont disponibles :

Lancer via vllm.entrypoints.openai.api_server

Lancer via uvicorn

Assurez-vous que le service démarre avec succès et qu'il écoute sur le port par défaut 8000. Vous pouvez également spécifier le port du service vLLM avec le paramètre --port.

Ajouter le fournisseur vLLM dans Cherry Studio :

Suivez les étapes décrites précédemment pour ajouter un nouveau fournisseur d'IA personnalisé.

Nom du fournisseur : vLLM

Type de fournisseur : Sélectionnez OpenAI.

Configurer le fournisseur vLLM :

Clé API : vLLM ne nécessitant pas de clé API, vous pouvez laisser ce champ vide ou saisir n'importe quel contenu.

Adresse API : Renseignez l'adresse API du service vLLM. Par défaut, l'adresse est : http://localhost:8000/ (si un port différent est utilisé, modifiez-le en conséquence).

Gestion des modèles : Ajoutez le nom du modèle que vous avez chargé dans vLLM. Dans l'exemple python -m vllm.entrypoints.openai.api_server --model gpt2, vous devez saisir gpt2.

Commencer à dialoguer : Vous pouvez désormais sélectionner le fournisseur vLLM et le modèle gpt2 dans Cherry Studio pour dialoguer avec le LLM alimenté par vLLM !

Lire attentivement la documentation : Avant d'ajouter un fournisseur personnalisé, lisez attentivement la documentation officielle de votre fournisseur d'IA pour connaître les informations clés telles que la clé API, l'adresse d'accès et les noms de modèles.

Vérifier la clé API : Utilisez le bouton "Vérifier" pour confirmer rapidement la validité de votre clé API et éviter les erreurs.

Attention à l'adresse API : L'adresse API peut varier selon les fournisseurs et modèles d'IA, assurez-vous de saisir l'adresse correcte.